G検定の概要と学習方法

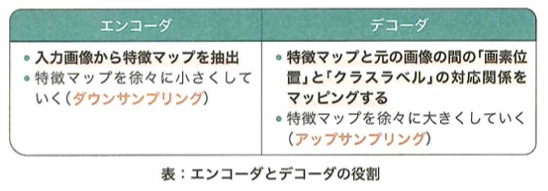

G検定の試験時間は120分で全て選択式の知識問題で自宅にてオンライン受験になります。受験費用は一般は12000円で学生は5000円になります。G検定はキーワードを覚えておくだけでは解けない問題も多く出題され、理解が重要視される検定です。問われていることは何か?を理解し、どう調べれば答えが見つかるかが分かるレベルに達すると、解ける問題が増えます。

ディープラーニング→数理統計や機械学習→人工知能

ディープラーニングの箇所が最も頻出で、人工知能になると頻度は少なくなります。

法律・倫理の問題は全体の約2割を占めると考えて問題集ベースの学習を行いましょう。

問題数は約220問(最近は200問以下)で120分で解くので1問あたり約30秒の計算です。調べてもわからなさそう、どう調べるか分からない問題は、後回しにしましょう。近年は出題数が減少傾向で、考えさせる問題が増えている様子です。また、法律系の出題が増えています。必要ならば下記の法律・倫理のテキストを参照しながらの学習をおすすめします。2025年3月8日の試験で無事に合格することができました。

僕は『最短突破 ディープラーニングG検定(ジェネラリスト) 問題集 第2版』などで合格を目指します。本書を選んだ理由は、教科書と問題集が一体になっていて、特に問題の解説が教科書のように詳しいという評判を知ったからです。本記事は本書などを勉強した際の学習記憶としての役割もあります。

G検定はインプットのみでは漠然とした理解になりやすいので、合格のためにはアウトプット用の教材が必須です。特に法律系の内容は出題数もそこそこある上で受験者にとって失点の原因になる範囲です。僕はこの分野を『ディープラーニングG検定(ジェネラリスト) 法律・倫理テキスト』を用いて理解確認を行います。全体のアウトプットは有名な黒本『徹底攻略ディープラーニングG検定ジェネラリスト問題集 第3版』と類書『ディープラーニングG検定(ジェネラリスト)最強の合格問題集[第2版] [究極の332問+模試2回(PDF)] (まっすぐ合格シリーズ)』を用いて得点力の底上げを行います。

これらの書籍には模試も付属しているので、本番本番前にネット上の模試も含めて十分な対策ができます。長い目で見るとG検定は複数書籍での対策が良いと考えます。

人工知能とは

人工知能の定義

人工知能の分類や代表名

人工知能やAIとは汎用型(人間のような)人工知能をイメージする人が多いが、近年では特化型人工知能の活躍が目立ちます。例えば囲碁に特化した人工知能AlphaGo(2016)などです。ある特定のタスクについて人間より秀でているものを作るのは可能だが、善悪の判断などの哲学的問題や、多角的に判断するタスクはまだ実現できていません。汎用型人工知能を強いAI、特化型人工知能を弱いAIとも言います。

Ponanzaは将棋AIで、StockfishはチェスAIです。ただし2017年以降にはelmo、Stockfishにも少しの学習で勝てるAlphaZeroというAIが開発されています。AIの強さや弱さはジョン・サールによって論文で提示されました。

人工知能の始まり

1956年のアメリカのダートマス大学にてダートマス会議という研究発表が行われた際のジョン・マッカーシーが、会議の提案書において初めて人工知能という言葉を使いました。ジョン・マッカーシーは研究分野の区分に対しても人工知能という研究分野にしようと同会議で命名しました。

ジョン・マッカーシーはダートマス会議の発起人です。アラン・チューリングは人工知能の概念の提唱者と言われています。

人工知能のレベル別の分類

人工知能の分類方法において、『エージェント アプローチ人工知能』にて示されている分類を学びます。レベル1はシンプルな制御工学で、一般的な電化製品に搭載される全ての振る舞いがあらかじめ決められているものです。レベル2は古典的な人工知能で、掃除ロボットなどの探索・推論、知識データを利用し、状況に応じて複雑な振る舞いを行います。レベル3は機械学習を取り入れた人工知能で、非常に多くのデータをもとに入力と出力の関係を学習したものです。検索エンジンや交通渋滞の予測などで用いられます。レベル4はディープラーニングを取り入れた人工知能です。レベル3で行っているものの中でもディープラーニングを用いているものです。画像認識、音声認識、機械翻訳などの従来コンピュータでは難しい分野での応用が盛んになっています。

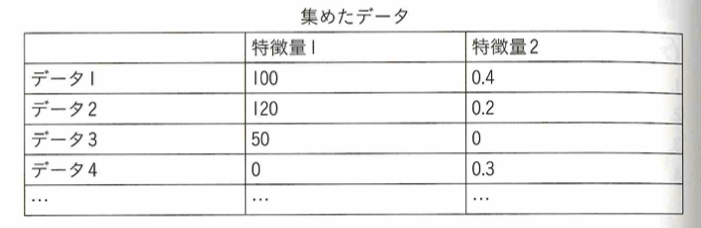

特徴量とはデータの特徴を表す量で説明変数とも呼ばれます。プログラミングはレベル1から使われています。VBAはマイクロソフトオフィスにおけるプログラミング言語のことです。人間工学はプロダクトのUI/UX(ユーザーのサービスによる体験など)を主に考える学問です。ベイズ統計モデリングは計算量の多さから実務に応用されているとは言い難いですが、実務に応用できれば、予測の不確実性まで定量的に扱えるので盛んに研究が行われています。

AI効果

人工知能分野において、新しい技術が開発されてもその仕組みが浸透し原理がわかってしまうと、人工知能を単なる自動化であって人工知能ではないと考えてしまうことをAI効果といいます。

ELIZA効果とは、意識的にはわかっていても無意識的にコンピュータが人間と似た動機があると感じてしまう現象です。エライザはチャットボットの元祖「ELIZA」からきています。単におうむ返しの返答をしたり、関連することを投げかけたりするプログラムですが、エライザ自身が興味を持っていると感じてしまうところから命名されています。

人工知能の歴史

初期のコンピュータ

1946年ペンシルベニア大学で開発された汎用電子式コンピュータをエニアック(ENIAC)と言います。

electoronic numerical integrator and computerで電子計算機と命名されています。第二次世界大戦での暗号解読に軍資金がつぎ込まれ研究が行われました。チューリングマシンは、1930年代にアラン・チューリングが考えた自動計算機の理論のことです。自動計算機とは、機械に自動的に計算を行わせる理論です。エニグマ(ENIGMA)はナチス・ドイツが用いていた暗号機の名前です。エドサック(EDSAC)とは1949年に開発されたイギリスのコンピュータです。これは現代のコンピュータと相違ないものです。

初めての人工知能プログラム「ロジック・セオリスト」

ロジック・セオリストは初めての人工知能プログラムで、1956年のダートマス会議で、アレン・ニューウェルとハーバート・サイモンによってデモンストレーションされました。ロジック・セオリストは記号論理学において定理を証明するコンピュータプログラムです。プリンキピア・マテマティカという数学書に含まれる定理のうち73%を証明しました。ジョン・マッカーシーはダートマス会議の提案(1955年)において人工知能という言葉を生み出しました。論理表現では→やvは論理結合子と呼びます。ロジック・セオリストではこのように記号によって知識を階層的に表現します。ロジック・セオリストは証明すべき定理から逆算的に有効な推論をしていき、それを公理に到達するまで続けます。ロジック・セオリストにおいて、問題をヒューリスティックに解決します。

ヒューリスティックは、ある程度正解に近い解を見つけ出すための経験則や発見方法のことで、発見法とも呼ばれます。いつも正解するとは限らないが、概ね正解するだろいう直感的思考です。これと対極の考えがアルゴリズムです。

AIの歴史

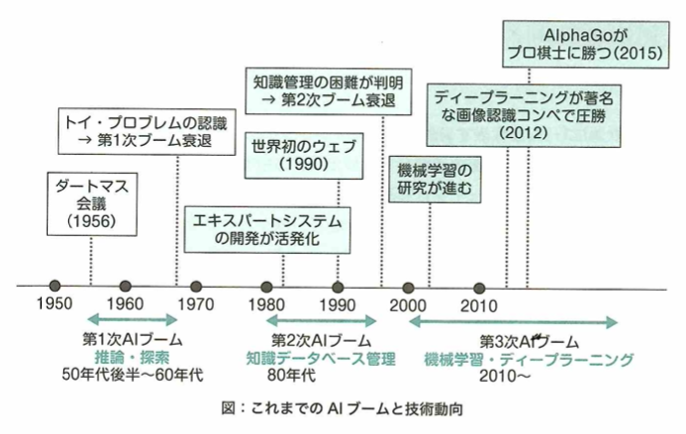

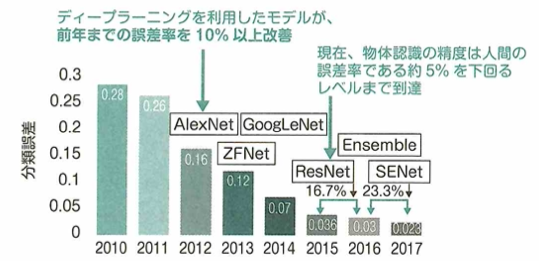

AIブームは何度も流行しては冬の時代を迎えてきました。第1次AIブームは推論と探索の時代です。1950年代末〜1960年ごろに流行し、トイプロブレムと呼ばれるような簡単な迷路の問題を解けるAIが開発され、話題になり流行しました。しかし複雑な問題には対応できず、1970年代後半から冬の時代に入りました。第2次AIブームは知識の時代で、1980年代頃から再度注目されました。当時専門家の知識を用いて質問に答えたり問題を解いたりするプログラムエキスパートシステムが話題になりましたが、データベースの管理の大変さや用途が限定的すぎることにより、また冬の時代に入りました。第3次AIブームは機械学習・特徴表現学習の時代、もしくはディープラーニングの時代と呼ばれ、再ブームになりました。2012年に物体の認識率を競うILSVRCという大会でディープラーニングを用いた技術が圧倒的な精度を出したことや、2016年に囲碁大戦用AI「AlphaGo」が人間のプロ囲碁士に勝利して注目を浴びてブームになりました。

シークレタリープロブレムは秘書問題で最適化の問題です。エキスパートシステムは2020年代の現代でもレコメンドシステムとして活用されています。

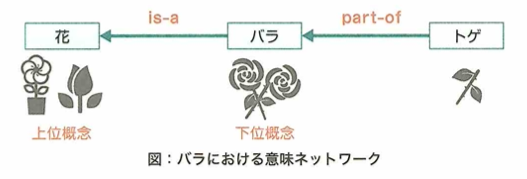

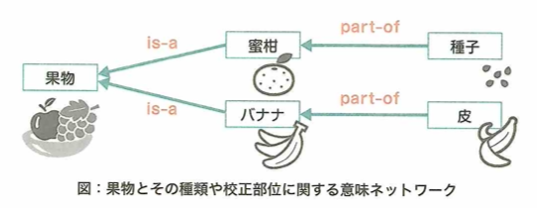

セマンティックネットワークは意味ネットワークともいい、知識をネットワーク構造で表したものです。ナレッジグラフは意味ネットワークの雑多な情報の中から半自動的に構成しているものです。少ないコストでできるメリットはあります。現在はGoogleが使用しているナレッジグラフのことを指します。エキスパートアドバイザーは自動売買取引ツールです。

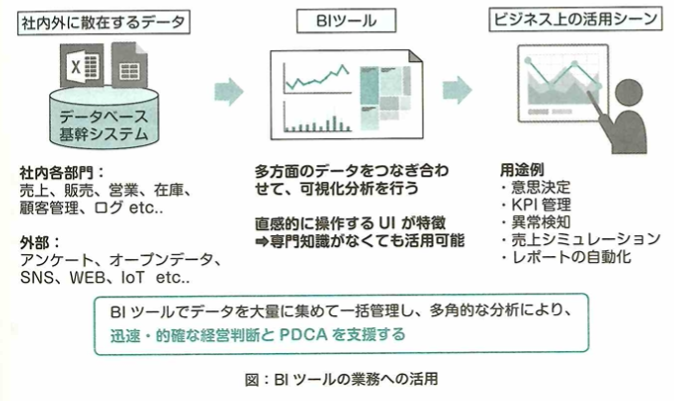

Kaggleはデータサイエンティストをサポートする目的で設立した世界的なウェブプラットフォームです。SIGNATEは日本企業などが多く採用しています。AtCoderは競技プログラミングでどれだけ素早く問題をプログラミングで解けるかを競うコンテストです。

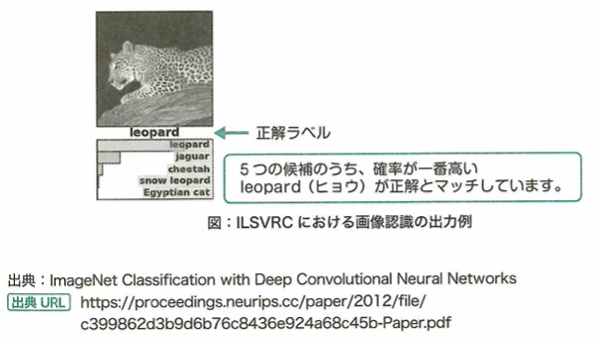

ディープラーニングを利用した成果

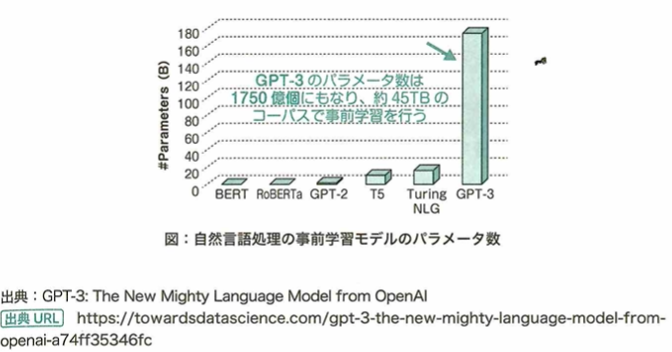

2012年にディープラーニングを利用したAlexNetというモデルが画像認識の大会で優勝し注目されました。以降はディープラーニングを用いた手法は様々な分野で成果を上げています。例えば次のような事例です。囲碁においてAlphaGoというモデルが人間のプロ棋士に勝利しました。1000クラスの画像分類においてPReLU-netというモデルが人間の分類精度を超えました。GPT-3という言語モデルが大学のレポート課題に合格しました。

ディープブルーはIBMが開発したチェス専用のスーパーコンピュータで1997年に人間のグランドマスターに勝利しました。ディープブルーはディープラーニングを使用してはいません。

以下、黒本『徹底攻略ディープラーニングG検定ジェネラリスト問題集 第3版』の該当章の大事なポイントの復習です。

ルールベース機械翻訳→統計的機械翻訳→ニューラル機械翻訳の順番です。

語呂的にるとにで覚えます。

人工知能をめぐる動向と問題

探索・推論

探索木

1960年代頃の第1次AIブームの研究の1つで探索木の考えは現在も汎用的に使われています。1ステップずつ全ての場合分けを同時にメモリに保存しながら深くしていく探索方法を幅優先探索と言います。他にも行き止まりかゴールに着くまで一度探索し、行き止まりの場合は他の場合分けをまた最後まで探索する方法を深さ優先探索と言います。

幅優先探索=縦型探索、深さ優先探索=横型探索とも言います。

ハノイの塔

ハノイの塔を考えます。構造自体単純ですが、円板の枚数が増えるたびに、指数関数的に手間が増えます。これを組合せ爆発と呼びます。

バックギャモンとは世界最古のボードゲームと言われます。スライディングブロックパズルとは、ケースの中に収められたコマを動かして目的の配置にするパズルゲームです。

探索手法

ボードゲームの問題ではコストを考えます。コストはある局面の状態が自分にとってどの程度有利かを表すスコアと言い換えられます。自分のターンがスコアが最大になり、相手のターンでは自分のスコアが最小になる手を選ぶだろうと仮定し、探索する手法があります。これをMini-Max法と言います。

通常は相手は自分に意地悪な手を打ってくると考えます。Negaとつくと相手が相手自身のスコアが高くなるような手を取ると仮定します。あくまでも通常のMini-Max法では深さ優先探索で、スコアは自分のスコアという点に注意しましょう。

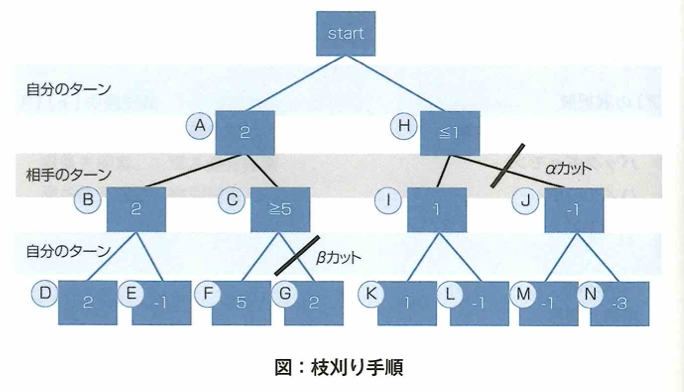

αβ法

3手先読みのαβ法について深さ優先探索のMini-Max法で進めます。まず左の選択肢から探索します。DとEを探索しスコアが分かりました。この時は自分のターンなのでDを取ります。するとBは暫定2を取れるスコアだと判断します。次にFを探索し5とわかった時点で自分が5以上取れるとわかりました。それを相手も把握しているとすると、相手はスコアを低くする手を取りたいので、明らかにBとCではBを取るはずです。すると、Gは探索しても意味がないので、探索せずにすみます。このβカットにおいてβは現状2であり それにより大きい値が出ました。ここまでで、Aの手のスコアは2だとわかります。今度はH側の手を探索します。最初にKとLを探索すると、Kを選択するはずなので、Iの手は1だと判明しました。その時点で、仮に自分がHの手を選択すると、相手は相手は1以下の手を取れてしまうので、自分は確実にHでなくAの選択肢を取るべきです。よってJ以降のて探索する必要がなくなります。これをαカットと言います。αは2であり、それにより小さい値が出ました。

αβ法は条件が最も良い場合は、Mini-Max法の約2倍の速度で計算が終わるとされ、最も悪い場合でもMini-Max法と変わらないので、現在の探索アルゴリズムの中でも現役で使われているものです。

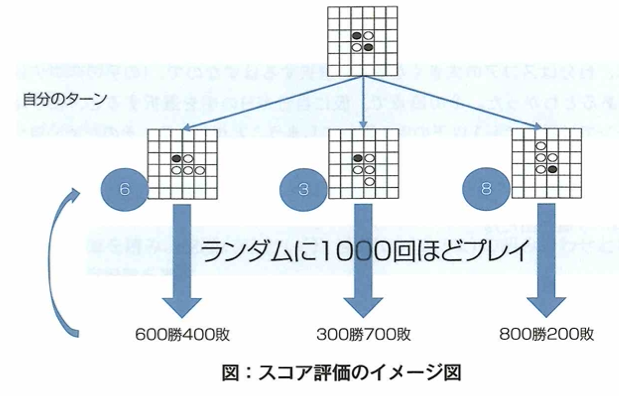

モンテカルロ法

ボードゲームにおいてスコア評価では小さな囲碁でもアマチュア初段に勝てなかったので、スコア自体の評価がそもそもあまり正しくないと分かってきたので、 モンテカルロ法を導入しました。結果の正誤を許容しつつ、数多くのシミュレーションをして最良な手(最適スコア)を探索(評価)していくという手法です。それぞれの手を差した後でランダムに1000回プレイし、勝った数をそのままスコアに換算する考えです。

αβ法などはゲームの終盤で用います。モンテカルロ法では序盤中盤のスコアを暫定的に決めるようにしたら、小さい囲碁では人間のプロとほぼ同じレベルに達しました。ラスベガス法はモンテカルロ法の一種ですが結果が必ず1つに定まります。正しい結果を返せない場合は失敗を意味します。メトロポリス法はある状態から新しい状態をランダムに作った際に、それを棄却するか採択するかを考える方法です。

ロボットの自動計画

第1次AIブームの時に機械は四則演算や簡単な動作しかできなかったので、命令を簡単な処理に切り替える自動計画に焦点が置かれました。1971年にリチャード・ファイクスとニルス・ニクソンにより開発された前提条件、行動、結果の組み合わせで自動計画を記述できる言語をSTRIPSと言います。このような自動計画を端末の画面の中の小さな積み木の世界に存在する様々な物体を動かすことで完全に実現しようとする研究も行われました。実際にAIはこれらを実行して画面に反映できました。1970年にスタンフォード大学のテリー・ウィノグラードによって行われたこのプロジェクトをSHRDLUと言います。

自動計画は戦略や行動順序の具体化を言います。自動計画を行うものをプランナ(自動計画機)と呼びますが、初期状態、ゴール、アクションの集合の3つを入力して取ります。アクションの集合には、前提条件、行動、結果を与えます。

PDDL(planning domain definition language)はSTRIPSに触発されて開発された自動計画を記述する言語です。ASIMOはホンダが開発し、2000年に発表された世界初の二足歩行ロボットです。GPS(general problem solver)はハーバート・サイモンとアレン・ニューウェルが開発した汎用の問題解決のためのプログラムです。

SHRDLUは指示を実際に動作として端末の中で実行してくれるものです。第5世代コンピュータプロジェクトは経済産業省が1982年〜1992年まで行った国家プロジェクトです。シェーキーは移動能力のある世界初の汎用ロボットです。内部ではSTRIPSが使われています。Cycプロジェクトは一般常識をコンピュータに取り組もうというプロジェクトです。

知識表現

エキスパートシステム

第2次AIブームは知識表現の時代です。AIブームの火付けになった1つに1964年〜1966年にジョセフ・ワイゼンバウムによって開発されたELIZAがあります。対話ロボットの中でも決められたルールに従い会話するものを人工無脳と呼びます。ELIZAはオウム返しのような返答をしていましたが、これでも人間と対話していると感じる人は多かったです。

A.L.I.C.E.はELIZAに触発されて開発されました。その年に最も人間に近いと判定された会話ボットに授与されるローブナー賞の同省を過去三回受賞しています。AlexaはAmazonが開発したAIアシスタントの名前です。自由度が高く、新たなスキルセットを開発し公開することができるので、簡単に実務に導入できるツールとして有用です。SiriはApple社製品向けのAIアシスタントです。

昔の日本語のチャットボットは人工無脳と語られるシーンがありました。

チューリングテスト

ある対話式の機械に対して人間的か判定するテストをイギリスの数学者の名前からチューリングテストと言います。何かしらのデバイスを通してAIか人間かを判定者がどれだけ見分けられたかで定量化するテストです。合格基準の1つは判定者の30%以上が対話相手が人間かコンピュータか判断できないと判定することです。2014年にロシアのチャットボット「ユージーン・グーツマン」が13歳の少年という設定で初めて合格しました。

ローブナー賞とは毎年のチューリングテストで聴覚、視覚ともに人間と区別が付かない割合が30%以上ならば金賞で、聴覚のみ同様の評価ならば銀賞としています。2019年までに一度も金賞と銀賞を受賞したAIはおらず、最も人間らしい会話上の振る舞いを見せているコンピュータに送られる銅賞のみが毎年表彰され、賞金を出しています。

エキスパートシステム「Mycin」

1980年代にエキスパートシステムの世界的企業への導入によりAI研究が再度ブームになりました。このエキスパートプログラムの初期の例としてのプログラムはMycin(1970年代)です。これは伝染性の血液疾患を診断し、抗生物質を推奨するようにデザインされているプログラムです。

精度は65%と言われていおり、専門家の精度の80%より低いですが、専門家でない人の診断よりは使えるといったものでした。Dendralは未知の有機化合物を質量分析法で分析したデータと、有機化学の知識を用いて適合する化学構造を割り出すプログラムです。アルゴリズム取引とは価格の変動パターンなど大量の市場データの分析による短期間の市場予測に基づき、取引の執行まで自動的に行うプログラムです。2020年でもMeta Traderというソフトウェアがあり、アルゴリズム群に対してエキスパートアドバイザー(EA)という名前がついています。Macsymaは世界初の数式処理を行うプログラムです。これはMITのProjectの一環で行われたものです。

近年の対話システム

2009年4月にIBMが開発したワトソンはアメリカのクイズ番組「ジェパディ!」にチャレンジました。ワトソンは問題で問われた質問を理解し、文脈も含めて質問の趣旨を理解し、大量の情報の中から適切な解答を選択し回答します。IBMはこの技術を医療やコールセンターの顧客サービスなどに活用できるとして開発を進めています。IBMはこれを人工知能ではなく拡張機能(Augmented intelligence)という形でAIと名付けていて、人間の補佐をする形で機能するものとしています。現在は実用例がありますが、チャットボットによるフルオートな顧客サービスではなく、顧客サービスを行う人の手助けとして機能するものとして提供されています。

日本でも質問応答するAIとして東大合格を目指す東ロボくんというプロジェクトもありました。2011年頃から開発され最終的には進研模試で偏差値57.8をマークしマーチ合格レベルに達したと言われています。2016年に計画断念の報道がありましたが、2019年に研究者本人のツイートから研究は続けられ、2021年までの計画であると発言されました。

進化知能(AAdvanced intelligence)はAbeam Consultingが提供しているDX経営におけるデータ分析サービスです。絶対知能(Absolute intelligence)はDCコミックスのキャラクターです。抽象知能(Abstract intelligence)はアメリカの心理学での言葉です。質問に回答するタスクをQuestion Answering(質疑応答、Q A)と呼びます。open-domain question answeringは膨大なトピックの多数の文書(例えばウイキペディア)を用いて、解答を推定します。QAタスクでは質問に関連する適切な知識に基づいて解答を推定することは求められますが、open-domain question anseringは問題を解くために必要な知識源を規定しません。kaggleでもコンペが開催されています。

東ロボくんは単語の羅列などから確率の高いものを選んでいるだけで、質問の意図や意味は理解していませんでした。しかしマーチレベルに達したことで現代の高校生の読解力に危機感が生まれ新井先生の書籍『AI vs. 教科書が読めない子どもたち』が出版されました。

りんなは2015年に日本マイクロソフト社が開発した会話ボットです。ディープブルーはIBMが開発したチェスAI専用のスーパーコンピュータの名前です。Tayはマイクロソフトが開発した会話ボットです。2016年にツイッターbotとして公開されましたが、調整と称してTayアカウントが停止されました。理由は、複数のユーザーによってTayの会話能力が不適切に訓練され、間違った方向のコメントをするようになったからです。

機械学習

機械学習

レコメンドシステムとは、利用者にとって有用と思われる情報または商品などを選び、それらを利用者の目的に合わせた形で提示するシステムです。

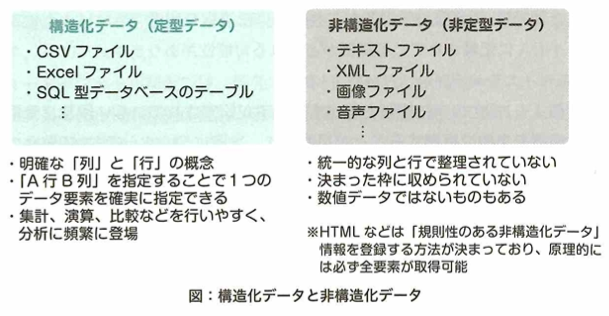

スパムフィルタとは受信したメールが正規のメールかスパムメール(迷惑メール)か判断するシステムです。特定物体認識とは画像中にヨーロッパホラアナライオンのオスといった特定の物体が存在するかしないかを判断します。OCRとは活字や手書き文字の画像データから文字列に変換する文字認識機能のことですが、古典籍のくずし字は認識が難解であるため機械学習を使用した手法は研究が進みつつあります。

一般物体認識は実世界の画像に対して、計算機がその中に含まれる物体を山、ライオン、ラーメンなどの一般的な名称で認識することです。

人工知能における問題

フレーム問題

1969年にジョン・マッカーシーとペトリック・ヘイズによって提唱され、哲学者ダニエル・でネットによりその具体的な思考実験が提案された問題で、ロボットは課題解決の枠にとらわれて、その枠の外を想像するのが難しいという問題をフレーム問題と言います。

The whole puddingという問題をダニエル・デネットは思考実験で考えました。シンボルグラウンディング問題は言葉と、それが示す映像や姿、質感などを機械は結びつけて捉えることができないのではないかという問題です。

中国語の部屋

チューリングテストは機械が人間かどうかを判定するテストとして1950年にアラン・チューリングによって提案されました。1980年に哲学者ジョン・サールによって発表された論文内で、チューリングテストの結果は何の指標にもならないという批判がされました。その論文内で発表された思考実験の名を中国語の部屋と言います。

テセウスの船はパラドックスの1つです。ある物体の構成要素が全て書き換えられた時、それは同一であるといえるかという問題です。哲学的ゾンビとは物理的には人間と同じ構造だが、意識がないものを指します。メアリーの部屋は全てが白黒の部屋で過ごしてきたメアリーは知識として色のついた世界を知っているが、突如色が見える世界に行った場合、新しく学ぶことがあるかという思考実験です。

シンボルグラウンディング問題

認知科学社スティーブン・ハルナッドにより議論されたもので、記号とその対象がいかにして結びつくかの問題をシンボルグラウンディング問題と言います。

身体性の問題とは、1980年代にロボット研究者のロドニー・ブルックスが提唱した「コンピュータには身体がないので、物体の概念までは捉えられないのではないか」という問題です。彼はその後ルンバで有名にあるiRobot社の創業者です。ハルナッドはシンボルグラウンディング問題の提唱者の名前です。

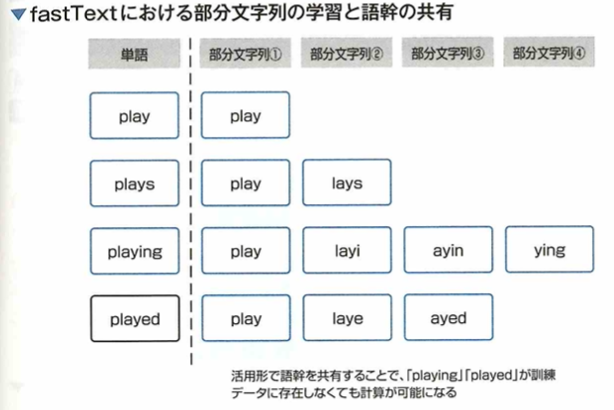

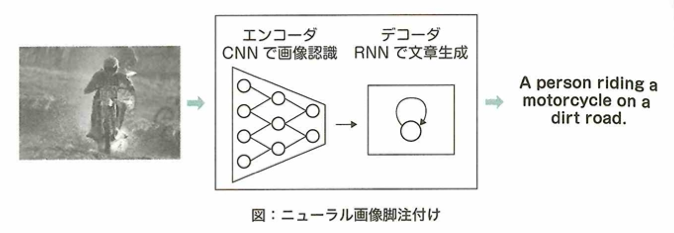

自然言語処理の歴史

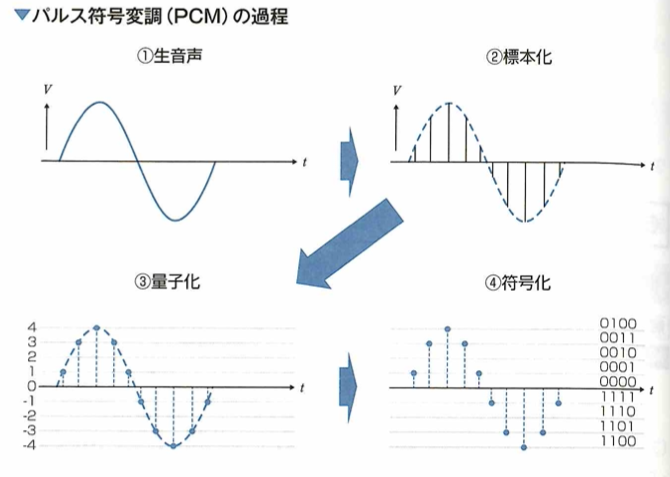

機械が自動的に言語を翻訳できないかという研究は第1次AIブームの時からすでに始まっていました。そういった翻訳を機械翻訳と言います。機械翻訳の手法は歴史に即して大きく3分割できます。

1つは1954年にジョージタウン大学でIBMが主体で研究を始めてから1970年ごろまで行っていたルールベース機械翻訳(PBMT)です。これは各言語の文法を人手で入力していき、変換していったが、限界があることと、言語自体が非常に柔軟であったので使いにくく上手くいきませんでした。

2つは1990年代にIBMが提唱したIBMモデルから取り入れ始めた統計的機械翻訳(SMT)です。この手法は現在の機械学習と類似しており、ある言語とその対訳を学習させてモデルとします。これにより以前の問題である人手でのルール追加による莫大なコストはかからなくなったが、それでも精度には問題がありました。

3つは2014年に発表されたニューラルネットワークを用いたニューラル機械翻訳(NMT)です。これにより精度が向上しました。データが溜まるほど精度が向上するので、現在はこの方法が主流です。しかし上の2つの手法にも利点があるので、一部の機能(構文解析など)は今も使われています。

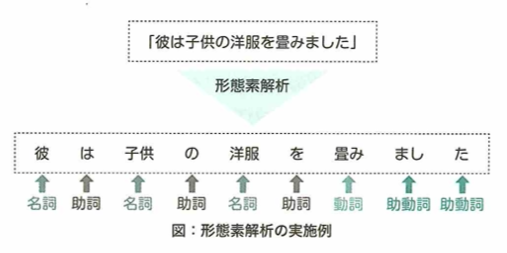

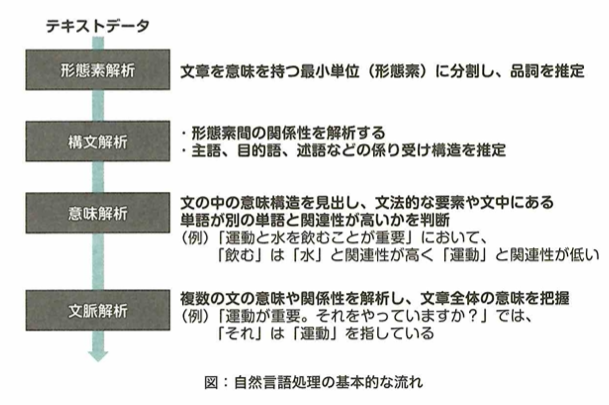

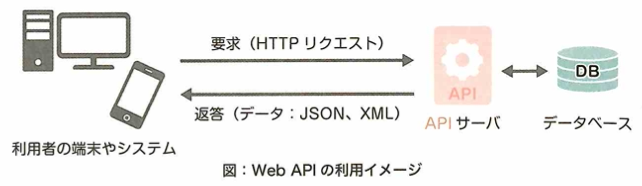

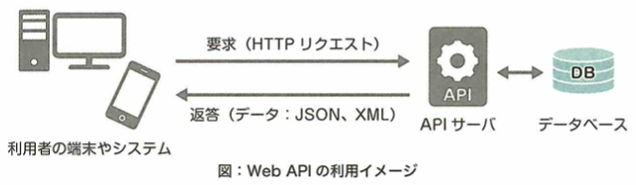

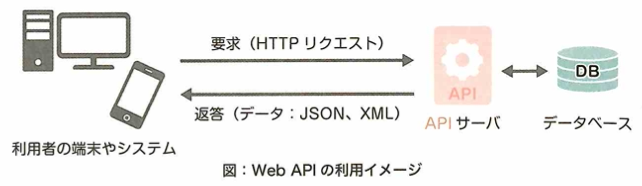

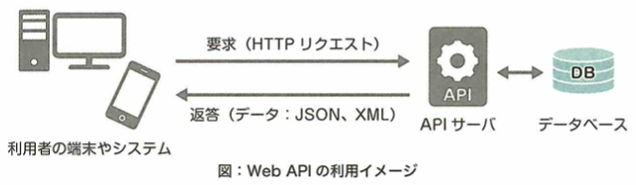

統計的機械翻訳とニューラル機械翻訳は、コーパスベース方式などでまとめられます。形態素とは文をルールに基づいて区切った際の最小単位です。その形態素の品詞や活用形などを判別していく作業を形態素解析と言います。Mecabは形態素解析用パッケージです。構文解析やエンティティ分析という文章に既知のエンティティがあるかどうかを調べ、その単語に関する情報を分析するものなどがあります。現在は自動的に行ってくれるAPI(ある機能の転用を簡単に行えるようにしたもの)も豊富なので、APIを活用したプロダクトも続々と出てきています。

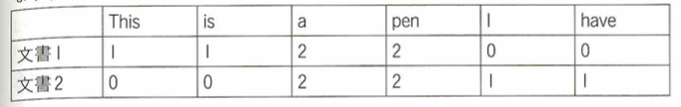

特徴量エンジニアリング

機械学習では、学習器(機械学習モデル)に与えるデータを説明変数(特徴量)と言います。特徴量について工夫する手法である特徴量エンジニアリングについて具体例をいくつか述べます。取引のログから一人当たりの平均取引時間を算出し、新たな特徴量としました。物体の画像データから輪郭情報を取り出し、新たな特徴量としました。文章データから単語の出現頻度を計算し、新たな特徴量としました。

特徴量エンジニアリングとは、取得済みデータから、データを加工し抽出することです。そのため、カメラの画質が悪いのでカメラを変えて取得したデータを特徴量としました。という主張はデータの取得前の話であり、既存のデータを加工することではないので不適切です。

特徴表現学習

予測したい数値に関わるデータを集めることや、データから特徴量を人手で加工・抽出することは機械学習で重要です。しかしディープラーニングを活用すると、後者の過程で特徴量を自動的に得る学習が可能です。こういった特徴量の加工・抽出も学習器にさせることを特徴表現学習と呼びます。

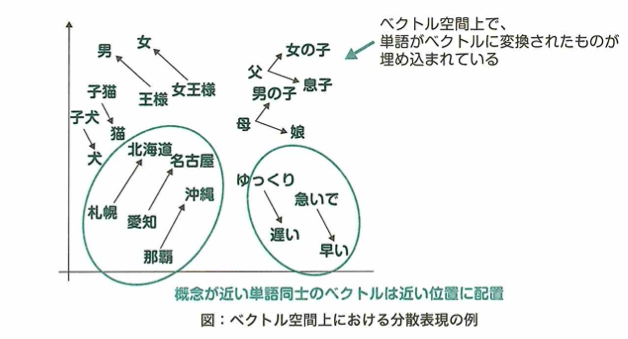

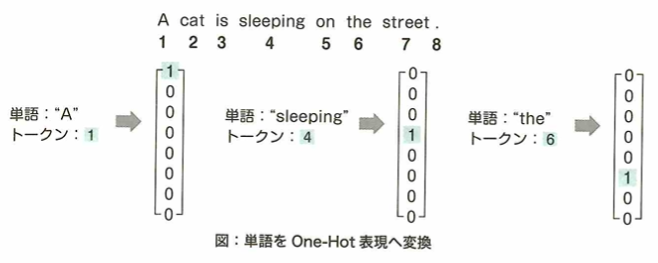

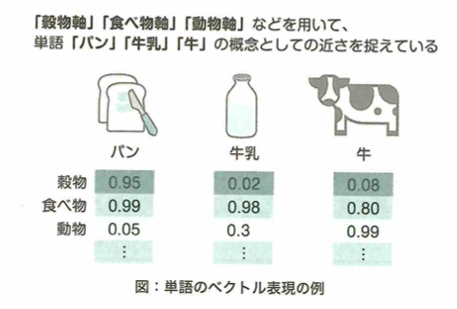

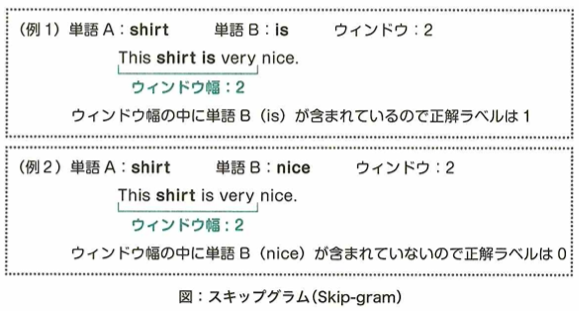

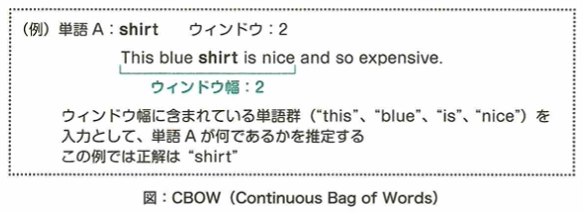

特徴量の加工・抽出まで学習器が行うことを特徴表現学習または表現学習と言います。自然言語学習において機械は単語をそのまま扱うのは難しく、単語をベクトルに変換する必要があります。このようにしてできた表現を分散表現と言います。適切な分散表現が得られれば、機械は文章の意図をつかみやすくなります。適切な分散表現とは、各単語に対して適切な意味を表現するベクトルが得られていることを意味します。この分散学習の仕方と、文章読解を同時に学習することで、適切な表現を得られます。これを表現学習と言いいます。単語の分散表現は他のタスクにも転用でき有用です。

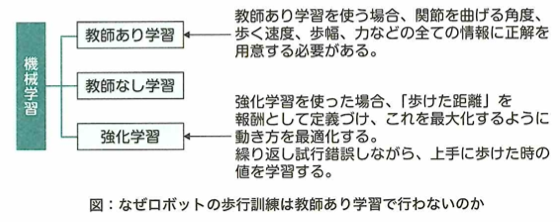

半教師あり学習は、学習の途中までは答え付きのデータで学習させ、そこからは答えのないデータ学習を行います。強化学習は報酬を得るために最適な行動が何かを行動しながら探索する学習のことです。教師なし学習は答えのないデータに対して、データのグループ分けをする学習です。

シンギュラリティ

2005年レイ・カーツワイルが出版した書籍で2045年には人間が自分自身よりも賢い人工知能を作ることにより、技術的特異点シンギュラリティが起きると予言しました。1.0の知能が1.1の知能を生み出すことができるならば、1.1も同様のことができうるはずで、そうなると技術的な進化が爆発的に起きるということを予見したものでした。

エキスパートシステムとは専門家の知識を入れ込みその意思決定能力を誰もが使える形にするもので、知識ベースと推論エンジンにより構成されます。

意味ネットワークとは知識を線で結びその関係性を表したもので、現在でもAIプロダクトの解釈性を高めるために使われます。

オントロジーとは意味ネットワークなどで用いられる知識の結びつけ方の規則です。

以下、黒本『徹底攻略ディープラーニングG検定ジェネラリスト問題集 第3版』の該当章の大事なポイントの復習です。

幅>深さで計算量の多さが変わります。幅優先の方は最短距離が必ず見つかりますが、深さ優先では最短距離が見つかるとは限りません。プランニングは、SHRDLU(積み木の世界)とSTRIPS(前提条件→行動→結果)が備えています。イライザはエキスパートシステムではありません。

セマンティックウェブはウェブサイトの情報リソースに意味を持たせ、コンピュータによってより高度な意味処理を行う技術です。ウェブマイニングはウェブデータを解析して知識を得ることです。LODはコンピュータ処理に適したデータを公開・共有する技術です。Cycプロジェクトは全ての一般常識をコンピュータに入れるプロジェクトです。

オントロジーは用語や概念を体系的に整理するものです。ライトウェイトオントロジー(ウェブマイニング、LOD)は正確性<実用性です。ヘビーウェイトオントロジー(Cycプロジェクト)は知識をどのように記述すべきか哲学的に考えるものです。人間が行うのでコストが高いです。

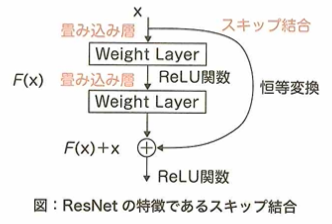

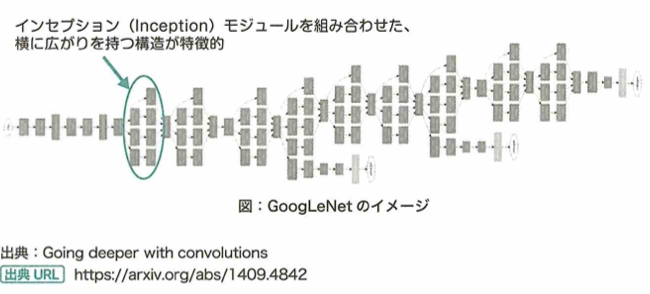

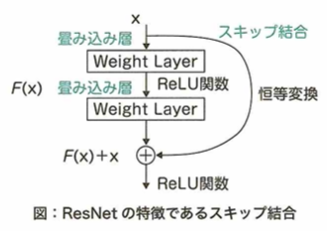

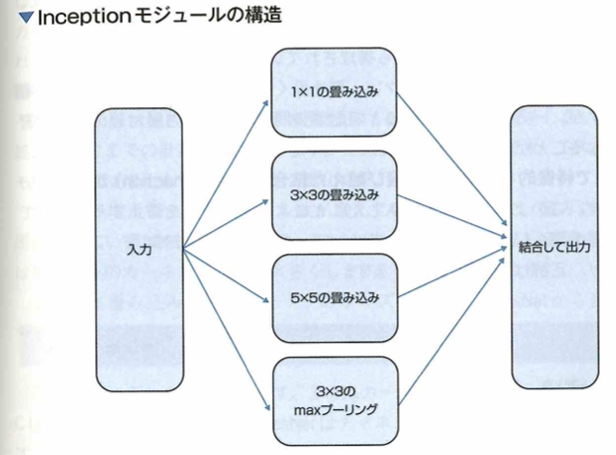

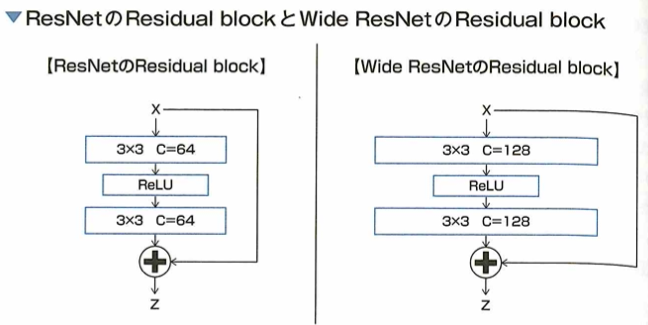

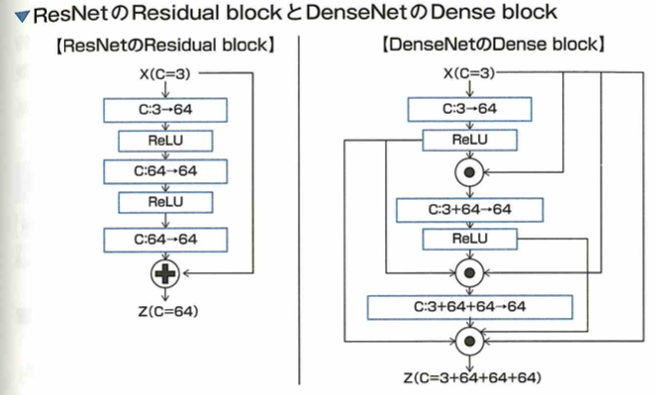

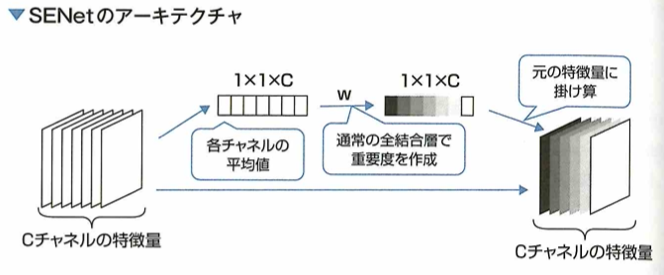

2012年に優勝したのはAlexNetで畳み込みニューラルネットワークを用いています。2014年に優勝したのはGoogLeNetでInceptionモジュールを採用しています。VGGは16層です。2015年に優勝したのはResNetでスキップ結合を用いています。2017年に優勝したのはSeNetでAttentionモデルを用います。MobileNetはDepthwise Separable Convolutionを採用し、DenseNetはResNetを改良したものでDenseブロックを採用しています。

黒本『徹底攻略ディープラーニングG検定ジェネラリスト問題集 第3版』での演習の次は、別の問題集『ディープラーニングG検定(ジェネラリスト)最強の合格問題集[第2版] [究極の332問+模試2回(PDF)] (まっすぐ合格シリーズ)』を用いた問題演習を行い更なる得点力の向上を目指します。

覚えるべき用語は、意味ネットワーク(ラベルをつけられた概念が互いの関係性を示す矢印で繋いだ記号体系)、オントロジー(知識概念の体系的な記述を目指す学術分野)

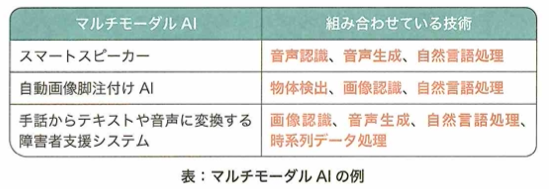

第1次AIブームは複雑な問題が解けない欠点、第2次AIブームは知識獲得のボトルネックが欠点、CASNETは緑内障の診断支援を行うエキスパートシステムです。トイ・プロブレムはルールが決まっている問題を解けても複雑な問題には対応できない問題、モラベックのパラドックスは高度な推論より感覚運動スキルの方が多くの計算資源を要する主張、Cycプロジェクトは現代版バベルの塔と言われます。身体性AIとは物理的な身体があり、環境との相互作用をおこなって初めて知能の構築が可能という考え方です。マルチモーダルAIとは人間の五感のように複数種類の情報を総合的に扱うAIです。

弱いAIは特化型AIとも言われます。ELIZAはエキスパートシステムではありません。人間と対話ができるソフトウェアです。チューリングテストは知能の存在に関する実験です。この反論として中国語の部屋を提唱しました。

意味ネットワークにおいて、下図をおさえます。

オントロジーとは、共通のルールで論理的に記述することで、知識を共有しやすくするための方法論です。

知識ベース(ナレッジベース)は第2次AIブームにおいて登場しました。知識の整備と保守には高いコストがかかりましたが、コンピュータの処理能力や知識を保存するデータベースそのものは問題ではありませんでした。第3次AIブームでディープラーニングが登場し、データから自動的に特徴を抽出し、画像認識などで高精度を出せるようになりました。

WatsonはIBMが発表したライトウェイトオントロジーを応用した質問応答ができるAIです。決定木はレベル3のAIで機械学習の1つです。顔認識はレベル4のAIでディープラーニングを活用しています。掃除ロボットはレベル2のAIで特定の分野において状況に応じた振る舞いができます。ATMには探索や推論の要素が含まれません。

フレーム問題とは、AIは有限な情報処理能力しか持たないので、現実世界に起こりうる問題の全てにはには対処しきれないという問題です。トイ・プロブレムとは、AIは明確なルールが定まっている問題が解けても、要件が曖昧で複雑な実世界の問題には対応できないという問題です。

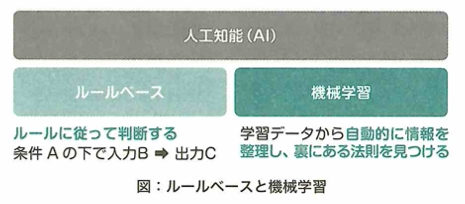

人工知能はルールベースと機械学習の2タイプがあります。

数理統計・機械学習の具体的手法

代表的な手法

学習の種類

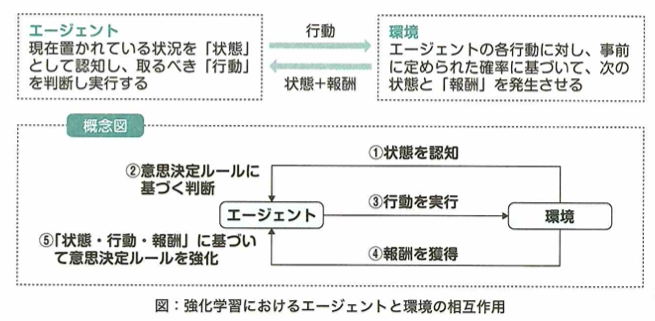

教師あり学習の手法の例は正解データが未知であるサンプルに対しその値を予測するモデルを得ることであり、教師なし学習の例はデータに共通する特徴的な構造や法則を見つけることを目的とすることで、強化学習の手法の例はエージェントが自身の報酬を最大化するような行動指針を獲得することです。

教師あり学習について、正解データは目的変数、その他の変数は説明変数もしくは特徴量と言います。教師なし学習はクラスタリングなどで用います。強化学習は、正解を与える代わりに将来の報酬や利益を最大化するように特定の状況下における行動を学習する仕組みです。ボードゲームなどで目覚ましい活躍をしています。これらはアルゴリズムや手法ではなく、機械学習のタスクの種別の枠組みです。

教師あり学習

教師あり学習は大きく分類問題と回帰問題に分けられます。分類問題では正解データが質的変数(カテゴリ)であり、回帰問題では量的変数(連続値)となります。

分類問題は疾患の有無や性別などのカテゴリーで、回帰問題では年収や気温などの連続値です。分類問題は2値問題と、ラベルが3種類以上である多値分類に区分けできます。多値問題は、個々の観測がただ1つのクラスに属するマルチクラス分類と、同時に複数のクラスに属しうるマルチラベル分類に分けられます。画像の中で特定の物体の領域を予測するタスクや、レコメンデーションにおいて順位をつけた出力を行うタスクも、教師あり学習のアプローチになります。

教師なし学習

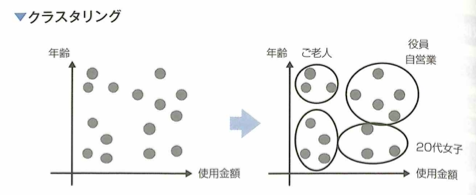

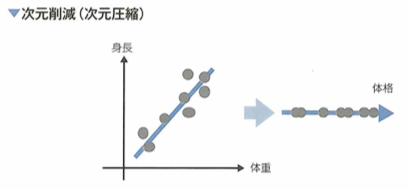

教師なし学習は、正解ラベルがないデータを学習し、データに共通する構造や法則を見つけ出すことを目的とします。その例はクラスタリングや次元削減(または次元圧縮)、確率変数の密度推定などが知られます。データを複数のグループにまとめるクラスタリングでは、グループ数の決定や、観測同士の似ている程度(類似度)の設計などが問題となる時があります。データをより少ない変数で要約しようとする次元削減では、いくつかの変数を用いれば十分か、より解釈しやすい変数の設計などが問題となる場合があります。

クラスタリングにおいて、数百のばらつき(標準偏差など)がある年収と数十程度のばらつきがある年齢が元の変数にある場合、それらをあらかじめ揃えるような前処理、または類似度の設計が重要です。

次元削減の時も、クラスタリングのときと同様に前処理が重要となる他に、重要な情報まで削ぎ落としてはいけないので、圧縮後の次元をいくつにするかが問題となります。例えば主成分分析では、スクリー基準やカイザー基準などが知られています。

異常な観測と正常な観測を分類する異常検知も教師なし学習として解かれることがあります。生存時間解析は、個体が死亡・故障するまでの時間を目的変数とした教師あり学習です。

強化学習

機械学習は、教師あり学習、教師なし学習、強化学習があります。教師あり学習は分類問題と回帰問題に分けられ、入力と出力の対応を学習するものです。教師なし学習は、入力のみのデータから、その背後にある構造を明らかにすることが目的です。代表的な教師なし学習のアルゴリズムには、k-means法や主成分分析があります。

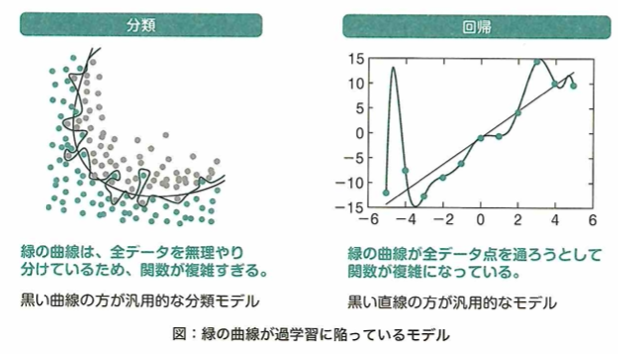

過学習はモデルが特定のデータセットに過剰に適合してしまう状態です。深層学習は、ディープラーニングのことです。オンライン学習は新しくデータが追加されるたびに、そのデータのみを用いてモデルを逐次的に更新する仕組みです。

k-menas法はクラスタリングの代表的な手法の1つです。クラスタリングは正解がない状況下で分類問題を解くことに相当します。

機械学習の代表的な手法は教師あり学習、教師なし学習、強化学習です。しかし半教師あり学習、自己教師あり学習、距離学習などもあります。自己教師あり学習は、ラベルのないデータから機械的にラベルを作って学習する手法です。距離学習は、同じクラスのサンプル間の距離を小さくしながら、異なるクラスのサンプル間の距離を大きくするように学習する手法です。これらのような手法がどれが最適か?について研究することもディープラーニングの1つのテーマです。

教師あり学習の代表的な手法

線形回帰

線形回帰は、説明変数と目的変数の関係に直線や超平面を当てはめ、予測・説明する教師あり学習の手法です。実施は推定された回帰係数が意味のある数字かどうか、偏回帰係数が0を帰無仮説とした統計的仮説検定で判断されます。統計的仮説検定とは、観測された標本を用いて、その母集団の性質を判断する手続きです。多くの場合、ある特定の確率分布を帰無仮説として仮定し、その分布にデータが従っていないかどうか判断します。

正則化

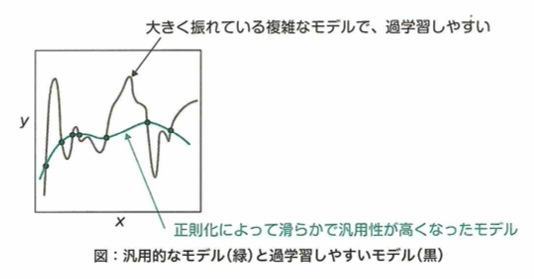

正則化とは、学習の際にペナルティとなる項を追加することで過学習を防ぐことです。

サポートベクターマシンにおけるカーネルトリックの一部は、データを高次元に写像することで線形分離を可能にします。正規化とは平均と標準偏差をそれぞれ0と1にすることです。対数化、Box-Cox化、Yeo-Johnson変換などは、特徴量を標準正規分布に従うように変換しデータの分布を調整することです。

正則化は(最小化したい新たな目的関数)=(通常の目的関数)+(正則化項)で導入されます。Ridge回帰やLasso回帰が有名ですが、ロジスティック回帰やサポートベクターマシン、勾配ブースティング、ニューラルネットワークなど、多様なモデルに適用されることがあります。

正則化を線形回帰モデルに適用した例(L1とL2正則化)

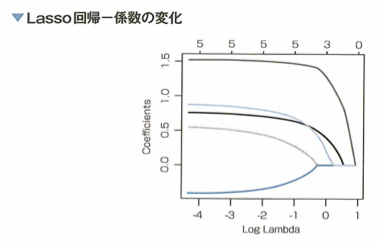

過学習を防ぐためのテクニックに正規化がありますが、線形回帰に対してL1正則化を適用した方法をLasso回帰、L2正則化を適用した方法をRidge回帰と言います。どちらも正規化パラメータを大きくするに従い、Lasso回帰では回帰係数をスパースに(ちょうど0となるものが多くなるように)推定する効果が、Ridge回帰では回帰係数を0に近づける効果が強くなります。解は解析的に書けます。

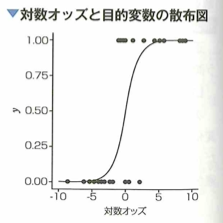

ロジスティック回帰

ロジスティック回帰は、分類問題を解くための手法で、一般化線形モデルの一種です。マーケティングにおける適用としては、見込み顧客が購買行動に至る確率を予測できます。一般化線形モデルの1つであり、分類問題へ適用できるのは、ある事象が起きる確率pと起きない確率1ーpの比の対数、つまり対数オッズを線形回帰するためです。数式で表すと対数オッズは、log(p/(1-p))です。

回帰と名前がありますが、分類問題に適用されるモデルです。オッズという言葉は賭け事などでの賭け金がp/(1-p)倍になるような数値というオッズと同じものです。ただし手数料などが取られない場合です。ロジスティックシグモイド関数では、閾値を定め、回帰後の予測値がその値を上回ると1に、下回ると0と予測します。

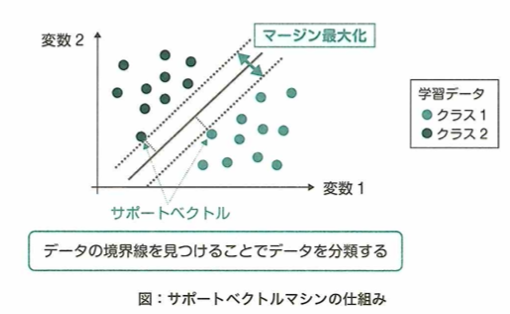

サポートベクターマシン

サポートベクターマシン(SVM)という学習アルゴリズムは、識別境界近傍に位置する学習データサポートベクトルと識別境界との距離であるマージンを最大化するように線形の識別境界を構築し、2クラス分類を行います。データが直線や平面に分類できない時は、データを高次元特徴空間へ写像し、線形分離可能にした状態で判別を行います。写像に伴う計算量の増加を低く抑えるテクニックはカーネルトリックと言われます。

サポートベクターマシン(SVM)は明らかに所属クラスが分かる観測ではなく、判別境界の付近にある判断の難しい観測に着目する分類モデルです。このとき、判別境界に最も近い観測はサポートベクトルと呼ばれます。SVMでは高次元空間に写像することで線形判別を可能にする工夫が行われます。

線形分離可能にする高次元への写像を探すことは難しいですが、カーネル関数という関数を使うことで写像を具体的に探すことなく、高次元空間で学習を行うことができます。その際に計算量の少ない都合の良いカーネル関数を用いることをカーネルトリックと言います。SVMやガウス過程などで用いるカーネル関数には様々なものが存在します。線形カーネル、RBFカーネル、多項式カーネル、周期的カーネルなどです。多層のニューラルネットワークに対応するカーネル関数も存在します。サポートベクトルを用いる回帰モデルに、サポートベクトル回帰(SVR)があります。

カーネルトリックとは、カーネル関数を使うことで、高次元の特徴空間における内積を行わず、入力空間でのカーネルの計算に落とし込むアプローチです。行っていることに対して計算量が大幅に少なくて済みます。

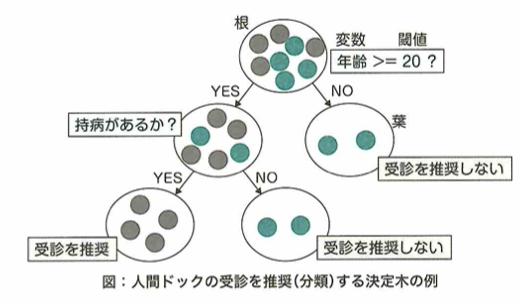

決定木

決定木は、木構造を用いて分類や回帰を行う学習アルゴリズムです。木構造の2つに枝分かれする節では、条件分岐が行われ、先端の葉にたどり着くと、その葉に対応する値が出力・予測値となります。木を成長させていくと最終的には1つの葉に1つのデータが対応してしまうので、過学習が起きます。過学習を避けるために木の深さなどに注意する必要があります。

根ノードから葉ノードへ辿り着くと、数値やクラスなどの値が出力されます。それぞれの分岐は1つの特徴量に関するif文で表されるため、得られたモデルが解釈しやすいのがポイントです。木の幅や深さを増やすと(条件分岐を多くすれば)学習データに対して過剰に学習してしまうので、それらを制御する工夫が必要です。

時系列モデル

時系列モデルとは、時刻が進むにつれ、値が刻々と変化していくデータです。時系列データおよび時系列モデルに関しては、次の内容が大事です。時系列分析で重要な概念は、定常性という概念です。定常性とは、確率的な変動があるものの、時点に依存せず平均と自己共分散が一定である性質で、時系列分析する上で扱いやすいです。時系列データは、トレンド、季節成分(周期性)、ホワイトノイズという基本構造からなるものが多いです。ホワイトノイズとは、平均0、分散一定、かつ自己相関が0であって、何の情報も含まないノイズのことです。ARモデルとは、自己回帰モデルです。ある時刻データが1つ前の値を用いて予測式を作る場合、y_t=ay_(t-1)+e_tなどとできます。自己回帰という名の通り、自分自身の過去の値を用いて予測します。VARモデル(多変量自己回帰モデル)とは、ARモデルを多変量に拡張したモデルです。VARモデルの係数推定には何期分までのラグを取るのかを決定する必要があります。

定常性が満たされている時系列モデルでは分散も一定となります。分散は自己共分散のラグを0としたものであり、自己共分散一定の条件に含まれます。定常性を満たす代表例がホワイトノイズで期待値と分散がそれぞれ、0とσの2乗で、任意のj次の自己共分散が0となります。定常ではない時系列データのうち代表的なものにランダムウォークがあります。分散が時間と共に拡大していくという特徴を持ちます。

VARモデルを構成する各方程式は、自分自身のラグとモデルに含まれる全ての方程式のラグを説明変数とします。定数項を除く場合、4変数でラグが2であれば8個の変数でラグが4であれば32の説明変数が必要となり、自由度が著しく低下します。長いラグを取ると説明変数が増えるので、予測の信頼度が低下します。

擬似相関

仮に相関係数の値が高く出た場合、相関関係が実際にある可能性が高いものは、降水量と傘の売上です。

アイスの消費量と熱中症患者の数は、気温という第3の要素により変化します。年収と血圧、および算数の成績と身長は、年齢という第3の要素によって擬似相関の関係があります。

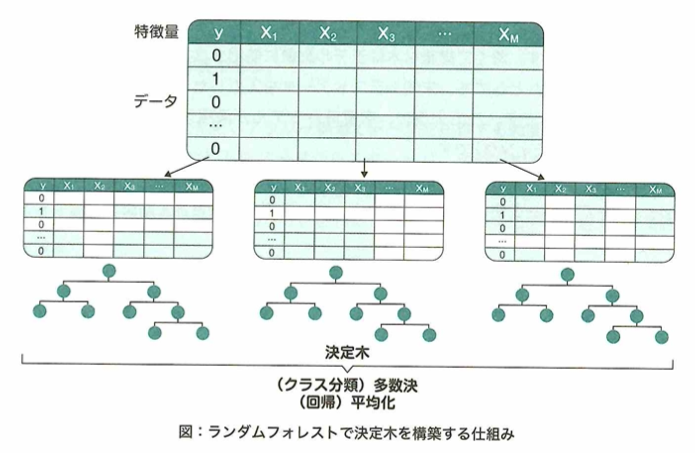

ランダムフォレスト

ランダムフォレストは、複数の決定木による出力の多数決・平均を行うことで分離・回帰を行います。弱学習器を複数合わせて汎化性能を高めることをアンサンブル学習と言います。ランダムフォレストには、木の数を多くしても過学習しにくいメリットがあります。

バギングと呼ばれるアンサンブルの方法が使われ、並列にそれぞれの決定木が学習されます。そのため計算機の環境によっては簡単に高速化できるメリットがあります。決定木をそれぞれ並列に学習することにより、決定木の数が増えても精度が悪くなることはありません。そのため木の本数ではなく、それぞれの決定木のパラメータ(木の深さや葉に入る最小のサンプル数など)を制御することで汎化性能を高めます。このメリットはランダムフォレストの大きな特徴で、ビジネスにおいてもベンチマークとなるモデルとして利用されます。

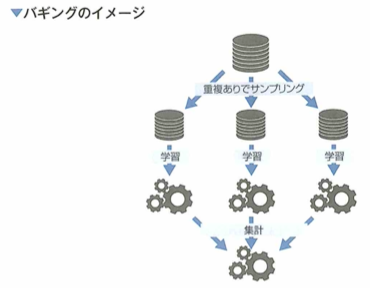

アンサンブル学習は、バギング、ブースティング、スタッキングの3種類があります。

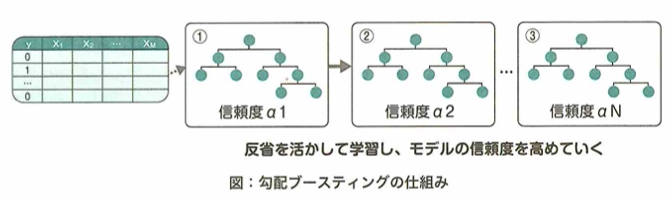

勾配ブースティング

勾配ブースティングとは、特にテーブルデータの教師あり学習において、幅広いデータセットで高い精度を出すモデルです。アンサンブル学習であるブースティングの1つであり、弱い学習器を次々と逐次的に学習するモデルです。2つ目以降の弱学習器は、それまでに学習したモデルによる予測とデータセットの違いを考慮して学習が行われます。弱学習器としては、さまざまなモデルを使用できます。

ランダムフォレストが、弱学習器に決定木を使用する具体的なモデルであることに対し、勾配ブースティングはあくまでもブースティングを実行するための1つの手法です。そのため、弱学習器には具体的なモデルを仮定せず、決定木の他に、線形回帰モデルなどが利用されることもあります。勾配ブースティングの弱学習器に決定木を使用したものは勾配ブースティング木と呼ばれ、特にテーブルデータの教師あり学習で人気のあるモデルです。

GBDTライブラリ

勾配ブースティングの弱学習器に決定木を利用した勾配ブースティング木(GBDT)は、その高い精度と使いやすさから、さまざまなライブラリが開発されてきました。代表的なGBDTのライブラリとして、catboost、lightgbm、xgboostがあります。

adaboostは勾配ブースティングと同様のブースティングの1手法で、GBDTを実装したライブラリではありません。xgboostはDMLC社により開発されたオープンソースのGBDTライブラリです。既存のPythonライブラリに比べて計算が速く、コンペティションで高い精度を誇ったことにより人気が出ています。lightbmはマイクロソフトにより開発されたライブラリで、xgboostよりさらに速い計算速度と、モデルの軽さから人気があります。catboostはロシアの検索エンジンを運営するYandex社により開発されたライブラリで、カテゴリ(質的変数)の扱いなどに工夫があります。適切に学習されたパラメータが設置されていれば、これらのライブラリで精度に大きく差が出ることは稀です。

バギング

アンサンブル学習の1手法であるバギング(bagging)はboostrap aggregatingの訳語です。バギングでは、データセットに多様性を持たせ、それぞれの学習した弱学習器をまとめることで汎化性能を高めます。個々のデータセットは、もとの学習データから同じ大きさのデータを重複ありサンプリングすることにより作られます。この作業はbootstrapやbootstrap samplingと呼ばれ、バギングの名称の由来となっています。

重複ありで同じ大きさのサンプルを得る作業はブートストラップやブートストラップサンプリングと呼ばれ、サンプルを擬似的な母集団とみなす統計的手法です。

ブースティング

アンサンブル学習の1手法であるブースティングは、同じ種類の弱学習器を逐次的に(直列的に)作成する方法です。それまでの学習によるモデルを修正する形で、1つずつモデルを学習させます。そのため弱学習器の数が増えすぎると過学習してしまうという特徴があります。ブースティングを使用したモデルとしては、adaboostや勾配ブースティング木があります。

モデルをよくモニタリングし、適切な弱学習器の数を決定しないといけないことに注意が必要です。

スタッキング

アンサンブル学習の1手法であるスタッキングは、あるモデルによる予測値を新たなモデルの特徴量(メタ特徴量)とする手法です。このとき、もとの特徴量で学習したモデルを1層目のモデル、メタ特徴量で学習したモデルを2層目のモデル、とすると、その階層は3階層になることがあります。foldに分割せずに学習データ全体を用いて学習したモデルで、そのデータに対して予測してしまうと、あらかじめ正解を知ってしまうため過学習が起きてしまいます。よって実際にはデータを分割して使うことが多いです。

データセット1で学習したモデルで、データセット2を予測し、新たなメタ特徴量としますが、学習に使用したデータに対してそのままメタ特徴量を使ってはいけないことに注意が必要です。勾配ブースティング木や線形回帰などを始めとし、多様性の観点から各層でさまざまなモデルが使用されることが普通なので、最終的な解釈性が非常に低くなるという特徴があります。

ベイズの定理

ベイズの定理であるP(A|B)={P(B|A)P(A)}/P(B)において事象A、Bをそれぞれ原因、結果とします。左辺は結果が分かっているもとでの原因の確率なので事後確率で、右辺のP(A)は結果が分かる前のAの確率なので事前確率で、P(B|A)は結果に対する原因のもっともらしさを表すので尤度と呼ばれます。

尤度について、これは原因やパラメータを仮定した(具体的なパラメータで条件付けした)ときのもっともらしさとして解釈できます。

尤度

確率モデルにおいて、想定するパラメータが具体的な値をとる場合に、観測されたデータが起こり得る確率のことを尤度と言います。例えばコインを3回投げて3回とも表のとき、表が出る確率をp=0.4とすると、尤度は0.064となります。

尤度をもとにすることで、パラメータのもっともらしさをモデルで比較することができます。尤度が最も大きくなるようにパラメータを推定する方法を最尤推定と言います。上記の問題文の事象を最尤推定するとp=1と推定されることからも分かるように、データが少ない場合やモデルが複雑な場合の最尤推定では過学習に注意する必要があります。

最尤推定値

最尤推定もしくは最尤法とは、データからモデルのパラメータを推定する方法の1つです。表の出る確率がpのコインがあり、コインを4回投げたところ、出た面は順に、(表、表、裏、表)であったとき、pの最尤推定値は0.75です。

本問では尤度はp^3-p^4になります。これを最大にするpを求めると答えが求まります。

教師なし学習の代表的な手法

k-means法

クラスタリングの1手法としてk-means法が知られています。これは非階層的なクラスタリングであり、あらかじめクラスタ数kを指定する必要があります。各観測が所属するクラスタは1つであり、複数のクラスタを跨ぐことのないハードなクラスタリングです。

次の問題のようなものを階層的クラスタリングと言います。観測が各クラスタに属する割合や確率を出力し、どのクラスタに属するかを決めてしまわない方法をソフトクラスタリングと言います。所属クラスタが複数考えられる状況など、曖昧さを維持したい場合に有用です。

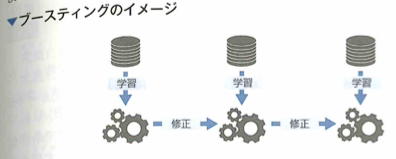

階層的クラスタリング

縦軸はクラスタがまとめられる距離、横軸は各観測のラベルとします。縦軸に対し閾値を定めることで、実際に複数のクラスタに分けられます。閾値を2.5とすると、クラスタ数は2となり、閾値を1.5とすると、クラスタ数は3となります。

レコメンデーションアルゴリズム

ウェブサイト上のコンテンツレコメンデーションの手法には、新着順や人気順にランキングを表示するものをはじめとし、様々なものがあります。これらに付随するコールドスタート問題に対する説明は次が大事です。

コールドスタート問題とは、レコメンデーションに必要なデータが十分に集まっていない段階では、望まれる成果が上がらないような問題のことです。コールドスタート問題の解決策として、売れ筋の商品を提示するなどの、個別のユーザーやアイテムに依存しない方法でレコメンドするといった対策や、ユーザーの行動をできるだけ早くレコメンドに反映できるシステムを強化することなどが考えられます。ビッグデータの活用による解決も考えられます。たとえばあるユーザーが「九州 お寺」「九州 天気 週末」と検索をしているデータから、ユーザーが週末に九州の寺へ参拝に行こうとしているかもしれないという仮説が立てられます。一方で、過去に同じような検索をしたユーザーの予約情報や検索履歴等のビッグデータから作成したレコメンドモデルを用いることで、「九州の寺院巡りツアー」のように、ニーズにある程度合致したプランを提供できると考えられます。

レコメンデーションとして何を推薦するかを決定する仕組みをフィルタリングと言います。

コンテンツベースフィルタリングでは対象アイテムの特徴から、ユーザーの嗜好の傾向にあった特徴を持つアイテムをレコメンドします。この方法では、推薦対象の属性が分かれば推薦が可能という点で、コールドスタート問題には対応しやすいです。協調ベースフィルタリングではユーザーの過去の行動履歴(購入・チェック履歴)からアイテムや利用者間の類似度を計算し、類似したアイテムをレコメンドする方法です。この方法では、レコメンドにおいて他顧客のデータを利用することから、コンテンツベースフィルタリングよりも、意外性のある推薦が行われるのがメリットの1つです。課題としては、新規のアイテムに対してレコメンドができないことです。サービスの利用がほとんどない利用者に対して、嗜好にあったレコメンドを出すことが難しいことが挙げられます。

コールドスタートの具体的な解決策の1つとしてハイブリッドモデル(協調ベースとコンテンツベースのフィルタリングを組み合わせたモデル)を利用します。例えばイギリスのLyst社が開発したLight FMがあります。ユーザーとアイテムのメタ情報(ユーザーの属性、取り扱う商品のジャンル、キーワードなど)を活用し、コールドスタート問題を解決することができます。高精度で動作が軽くPythonのコードセットが準備されていることなどが評価されています。

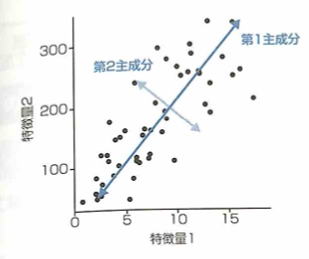

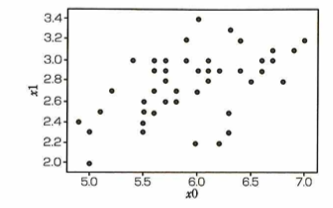

主成分分析

主成分分析とは、相関を持つたくさんの変数から、全体のばらつき(分散)を最も良く表す変数を合成する手法です。主成分は元の変数の数だけ合成されますが、上位の主成分のみ取り出すことで次元削減を行うことができます。また、主成分同士の相関は0となります。

第2主成分は第1主成分の方向と直交するように与えられます。以降も同様です。

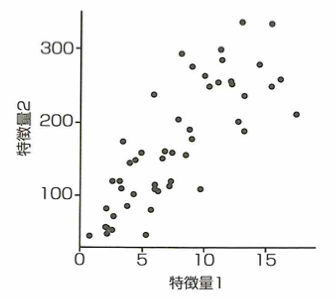

主成分の概念

この図のデータに対して主成分分析を行った結果、第1主成分と第2主成分の軸を描いた図として適切な選択肢を選ぶと、以下になります。

寄与率(主成分がばらつきを説明する大きさ、主成分に対応する固有値の大きさ)の大きい順に第1主成分、第2主成分・・・とします。

特異値分解

特異値分解(singular value decomposition)SVDは行列を分解する方法の1つで、ある行列を特異ベクトルと特異値に分解します。特異値分解ではある行列AをA=UDVT(Tは転置)と表します。これについて以下の内容が大事です。

行列を分解することで、成分の配列という表現からは明らかではない行列の機能的性質について情報を得ることができます。実行列はすべて特異値分解可能です。また特異値分解の方が、固有値分解よりも多くの行列に対して適用できます。

行列Dは正方行列でなくても特異値分解を適用できます。Dが正方行列である必要があるのは、固有値分解です。特異値分解を用いることで、Dが正方行列でない場合にも、固有値分解と同じようなメリットを享受できます。Dの対角成分は行列Aの特異値と呼ばれ、Uの列は左特異ベクトル、Vの列は右特異ベクトルと呼ばれます。

データの視覚化

多次元尺度構成法(multi-dimentional svaling)MDSについて述べると、多次元尺度構成法は、計量的多次元尺度構成法と非計量的多次元尺度構成法に大別でき、前者は量的データを、後者は質的データを扱います。

多次元尺度構成法は、対象間の類似度をできるだけ保つように低次元空間で表す手法です。主に心理学の分野で発展してきた手法です。心理学では、さまざまな要因が絡み合った現象を取り扱うことが多いので、錯綜したデータの処理に利用されてきました。

手法の評価

データの扱い

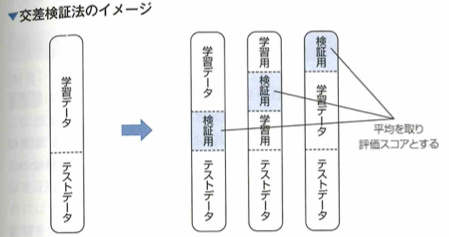

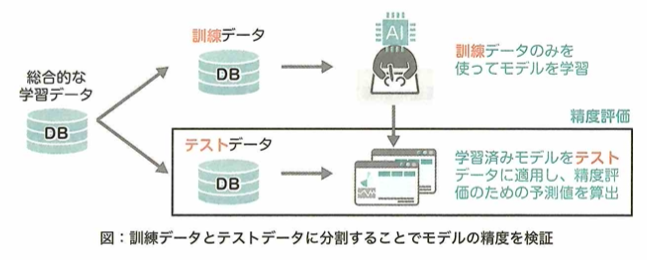

学習データだけでなく、未知のデータに対しても正しく予測できる能力のことを汎化性能と言います。モデルの汎化性能を測るために、交差検証法が利用されることがあります。

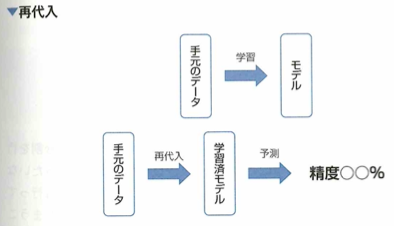

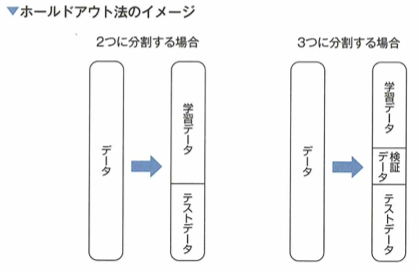

再代入では精度が高く出ても過学習している恐れがあります。モデルの汎化性能を測るための解決策としては、学習データとは別の評価用データを用いることがあります。評価用データの用意の仕方としては、ホールドアウト法や、交差検証法があります。

ホールドアウト法

モデルの性能を測る検証用データの用意の仕方として、ホールドアウト法が知られています。これは学習データを2分割し、一方を学習に、もう片方を評価に用いる手法で、次の内容が欠点となります。学習用データが減ります。パラメータの変更などを何度も行うことにより、評価用データに過学習する恐れがあります。データの分割の仕方によって結果が変わります。

交差検証法

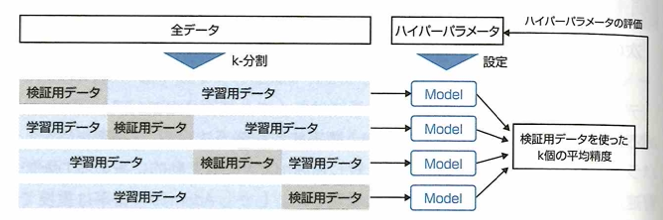

モデルの未知のデータに対する当てはまりを測る方法に、交差検証法(cross validation)があります。これは手元のデータを複数のブロック(fold)に分割し、そのうちの1つをテスト用に使い、残りを学習データとすることを、テスト用データを入れ替えて全てに対して行う方法です。ブロックの数をサンプルの大きさとしたものは1つ抜き(Leave one out)法と呼ばれます。

交差検証法でもホールドアウト法と同様に、分割の仕方で結果が変わるなど、何度もパラメータチューニングや特徴量の推敲を行うと過学習してしまう恐れがあります。

評価指標

回帰

モデルの精度を測る評価指標はさまざまなものが存在します。回帰問題で代表的な評価指標としてRMSEが知られています。これはMSEの平方根を取ったものです。

分類

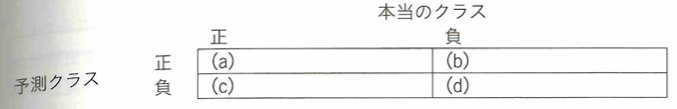

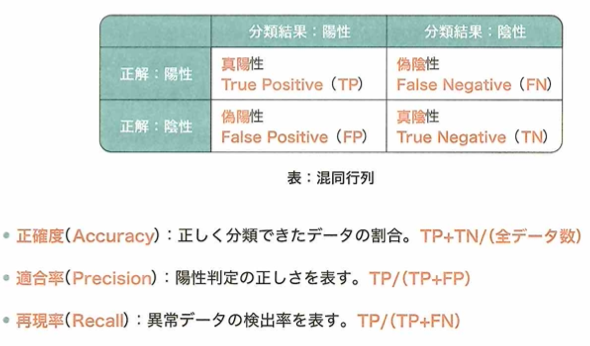

2クラスの分類問題として、モデルによる予測クラスと真のクラスを分割表としてまとめられます。

この表は混同行列と呼ばれ、( )内を埋めると次のようになります。

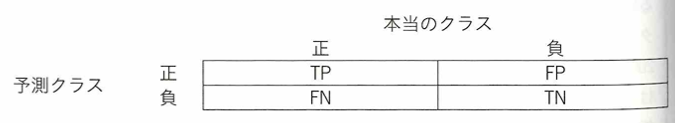

真陽性(TP) 偽陽性(FP)=α過誤(第一種過誤)

偽陰性(FN)=β過誤(第二種過誤) 真陰性(TN)

真偽については、予想が当たっていれば真、外れていれば偽

陽陰については、予測が正であれば陽性、負であれば陰性です。

データリンケージとはデータ漏洩と言われます。予測の時点では利用することができない情報を含むデータを用いて、モデルを構築した際に発生する問題です。例えば2000~2019年のデータがあり2018年の売上を予想したいとき、2018年以外のデータを用いることができますが、未来を予想したいとき、そのさらに先の未来のデータを活用することは不可能のため、利用できないモデルが出来上がってしまいます。

二値分類の評価指標

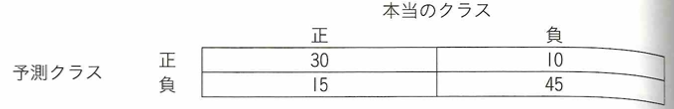

二値分類を行ったところ、混同行列が得られました。このモデルを評価するために、ある指標を用いて精度を測りました。結果(30+45)/100=0.75が評価値として得られました。この評価指標は正確率(accuracy)です。

正例。負例の数によらず正しく当てられた割合を正確率と言います。大半を占めるクラスに対する予測精度の影響を受けるため、少数クラスを正しく予測する場合や、一部のクラスにサンプルの大半が集中ている場合には注意が必要です。

二値分類の評価指標(適合率と再現率)

二値分類における混同行列において、評価指標として適合率や再現率などが知られています。適合率はTP/(TP+FP)、再現率はTP/(TP+FN)です。ある疾患(正例)を検出する問題を考えたとき、適合率は陽性判定のうち実際に疾患を有する人の割合で、再現率は疾患を有する人のうち正しく陽性判定できた割合を示す指標です。

正例(疾患を有する)と予測することを陽性判定と言います。適合率と再現率の間には、一方を高めればもう一方が下がってしまうトレードオフの関係があります。その中庸を取るために、両者の調和平均F値が評価指標として用いられることがあります。

F値

2クラスの分離問題における、モデルの予測精度を測る指標にはさまざまなものが存在します。代表的なものには正解率や適合率、再現率、F値などがあります。正解率は実際に予測が当たっているデータの割合で、適合率は、真と予測したデータのうち実際に真であるものの割合です。F値は、トレードオフの関係にある適合率と再現率の調和平均として定義されます。

陽性を多く出す検査では、FNが減るため再現率が高くなります。しかしFPが増えるため適合率が低くなります。

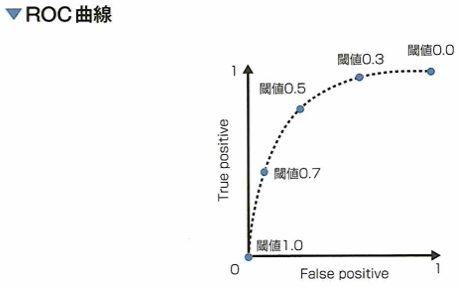

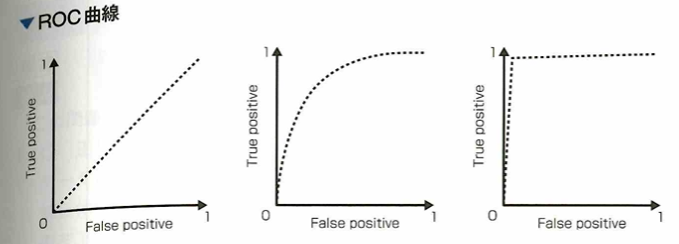

ROC曲線とAUC

二値分類において、モデルの性能を評価するためにROC(receiver operating characteristic)曲線を描くことがあります。この曲線は判別の閾値を動かした時の真陽性率と偽陽性率の関係をプロットしたものです。ここでは横軸に偽陽性率、縦軸に真陽性率をとるものとします。ROC曲線を書いたあとは、曲線の下側の面積であるAUC(area under the curve)でモデルの評価を行うことができます。モデルがランダムな予測をする場合、ROC曲線は直線になり、AUCは0.5となります。モデルの性能が上がるほど曲線は左上に張り出し、AUCは1に近づきます。

各クラスに属する予測確率が与えられたとき、予測確率が1なら正例と判断すれば良いですが。0.9、0.8、0.7となっていったときに、どこからを正例として分類するかは問題によって異なります。予測確率のどこからを正例に分類するか、の閾値をさまざまに変化させたとき、偽陽性率と真陽性率の推移をプロットしたものをROC曲線と言います。

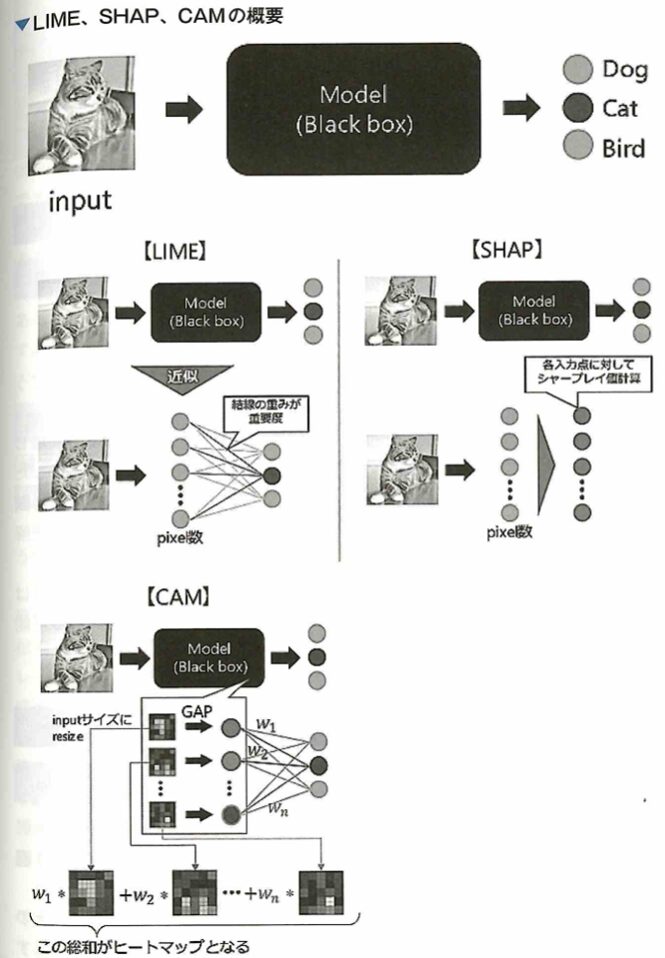

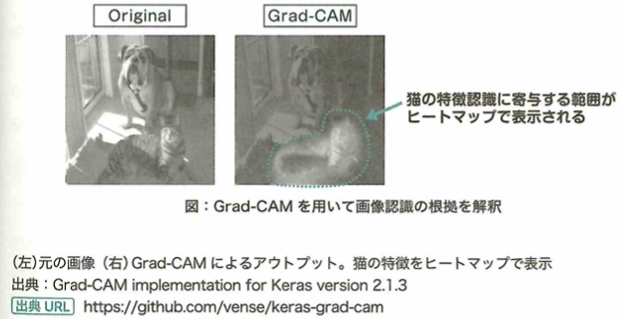

解釈性をもたらす研究

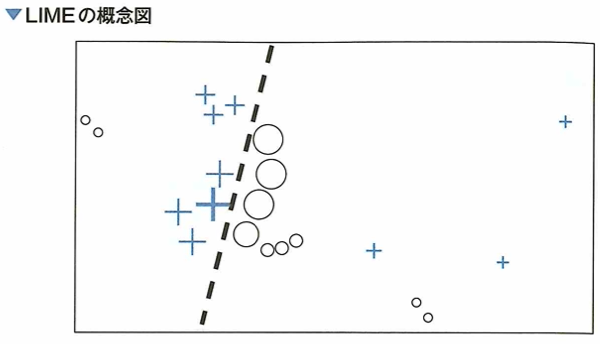

ブラックボックスな(解釈性の低い)モデルを解釈する手法の1つとして、2016年にLundberc ahd Leeにより発表された、強力ゲーム理論を応用しているSHAPが近年注目されています。SHAPは1つのデータにおける予測値の解釈について使えるだけでなく、予測値と変数の関係を見ることができるなど、ミクロな解釈からマクロな解釈まで網羅的に行える有用な解釈手法です。この方法はすでにPythonによるパッケージが開発されており、実務でも多く活用されています。

SHAPは決定木系のアルゴリズムや、ニューラルネットワークの派生アルゴリズムでも多様に活用できます。LIMEは同様の技術でSHAPの前によく使われていました。Anchors、influenceも解釈に関する1つのアプローチです。LIME(local interpretable model-agnostic explanations)はニューラルネットワークやランダムフォレストなどの複雑なモデルを、より平易で解釈しやすい線形モデルやルールモデルに近似し、居所的説明を生成する方法です。ただし、モデル全体を線形回帰モデルで近似することはできないので、居所的なサンプリングにより線形回帰モデルを生成します。

青で塗られる部分は、分類モデルが正(+)と分類する範囲で、白い部分はモデルが負(○)と分類する範囲です。記号の大きさはサンプリングされたインスタンスと興味のあるインスタンス間の近接度による重みづけの効果です。太い線だけでは完全に分類できないことがわかります。LIMEでは太字の+の周辺のデータに対してサンプリングを行い、解釈可能なモデルを学習させ、元の分類モデルを近似します。

モデル自体の評価

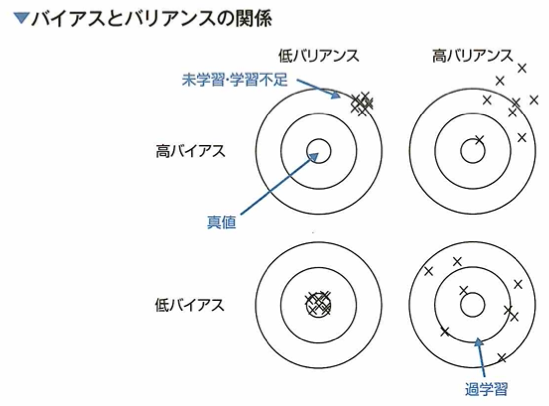

一般に、AIモデルの変数・パラメータが増え、複雑になるにつれて、与えられたデータをうまく説明できるようになります(ある入力データから、予測対象である値やクラスを高精度に推定できることです)しかし、そのようなモデルは不必要に複雑である場合があり、その結果過学習に陥ることもあります。モデルの汎化誤差の構成要素は、バイアスとバリアンス、データに含まれる本質的なノイズです。機械学習モデルの学習の目標は、バイアスの2乗、バリアンス、データに含まれる本質的なノイズの3種類の誤差の和である汎化誤差を最小化することです。オッカムの剃刀とは、ある事柄を説明するには、必要以上に多くを仮定すべきではないという考えです。統計学や機械学習の分野では、モデルの複雑さ、変数の多さとデータへの適合度とのバランスを取るために、オッカムの剃刀的な発想を利用します。AIC(akaike information criterion)赤池情報量基準は、AIC=ー2×(最大対数尤度)+2×(パラメータ数)です。パラメータが増えること自体がペナルティとなります。

バイアスとは予測値の平均と正解値とのずれで、学習データとモデルとの予測の誤差を表現します。バリアンスは、予測値相対のばらつき具合です。モデルを複雑にするとバイアスは減少しますが、バリアンスは増加します。これを過学習と言います。AICを用いることは、誤差が同じ程度ならパラメータ数の少ないモデルを選ぶべきというオッカムの剃刀の考えが強調されます。

この説明はとてもわかりやすいです。本書『最短突破 ディープラーニングG検定(ジェネラリスト) 問題集 第2版』はこのような気付きが多く、素晴らしい1冊です。

以下、黒本『徹底攻略ディープラーニングG検定ジェネラリスト問題集 第3版』の該当章の大事なポイントの復習です。

統計学での説明変数は機械学習では特徴量(教師データを説明できる変数群)と呼ばれ、統計学での目的変数を機械学習では教師やラベルと言います。データから特徴量を作るプロセスを特徴抽出と言います。作成した特徴量からその一部を抽出することを特徴量選択と言います。ロジスティック関数の損失関数を交差エントロピーと言います。

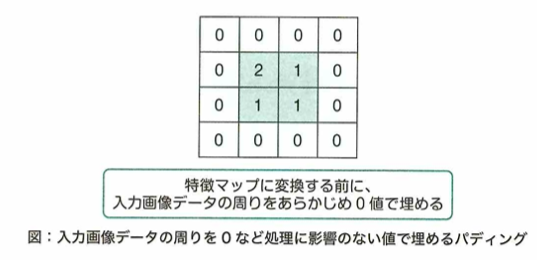

弱学習器とは決定木のような個々のモデルです。パディングとは畳み込みニューラルネットワークで使用します。画像の周囲に0などの定数を埋めて補完する方法です。ブートストラップサンプリングとは全体の一部データを使用します。バギングとはアンサンブル学習で用います。弱学習器で並列で学習を行い、多数決(分類タスク)か平均(回帰タスク)で出力を決定します。対してブースティングは弱学習器を逐次的に学習し予測値を修正していきます。AdaboostやXGBoostがあります。後者は勾配ブースティングを使用します。

白色化は特徴量の相関を除いてから標準化することです。教師あり学習はランダムフォレストやSVMで、教師なし学習はk -means法(非階層)やPCAです。

クラスタリングは教師なし学習です。階層型はウォード法(事前にクラスター数が不要)で非階層型はk-means法(事前にクラスター数が必要)です。

協調フィルタリングは複数のユーザーの過去の情報などから推薦しますが、コールドスタート問題があります。コンテンツベースフィルタリングは商品の特徴を利用します。

強化学習ではエージェントが環境と相互作用しながら最適な環境を学習します。エージェントは報酬を最大化するように学習します。これを方策と言います。その際に割引率を時刻に応じて考えます。そのため後になるほど価値が低くなります。報酬とは将来にわたる累積報酬のことで、これを価値と言います。価値には状態価値関数と行動価値関数があります。行動価値関数のことを価値関数ということもあります。これをQ値として最大化することを考えます。その手法としてQ学習やSARSAがあります。

多腕バンディット問題は複数のスロットマシンから決められた回数内で当たりを多く引くことを目指します。提案と活用で解くアルゴリズムにはε-greedy方策(確率εで提案し、残りの確率で活用)とUCB方策があります。提案とは、未知の情報以外の情報を獲得するために行う行動で、活用とは、既知の情報を利用して最大の報酬を得る行動です。

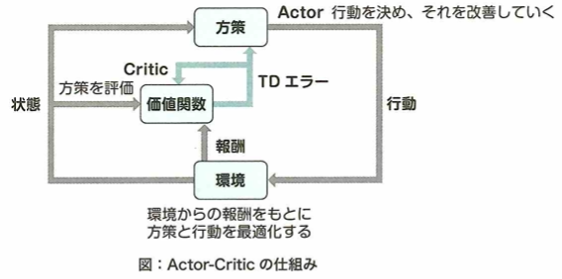

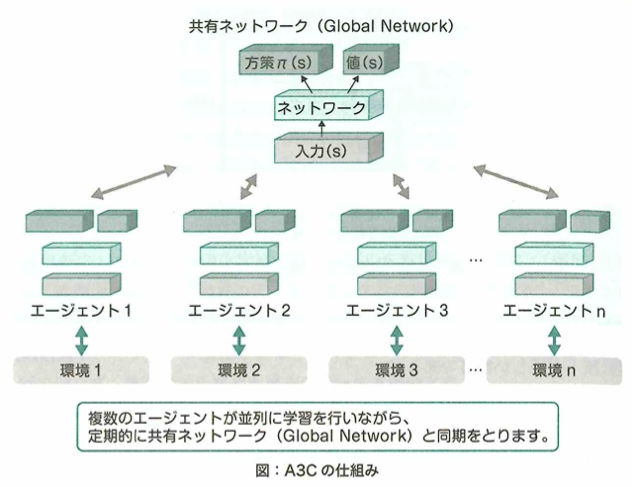

方策勾配法は、方策をあるパラメータを使用した関数で表し、累積報酬を最大化するようパラメータを学習することで、方策を学習するということです。これはロボット制御などに向いています。REINFORCEは方策勾配法の計算を行うアルゴリズムでAlphaGoにも採用されています。他にはActor-Criticがあります。これは方策勾配法と価値関数のアプローチの組み合わせです。つまりActor(行動器)とCritic(評価器)から構成されます。またこの応用がA3Cです。

性能評価は教師あり学習です。検証データとはハイパーパラメータを評価前に最適化するため訓練データを分割したものです。例えばホールドアウト法は訓練データとテストデータを用います。k -分割交差検証法は、データをk個に分けて1個をテストデータで残りのk -1個を訓練データとすることをk回繰り返した結果の平均を考える方法です。データリーケージとは訓練データにテストデータの一部が混入することです。未学習とは訓練誤差と汎化誤差が共に大きい状態で、バイアスが高いつまりモデルの表現力が小さい回帰のような時におきます。過学習とは訓練誤差が小さく汎化誤差が大きい状態で、バリアンスが高いつまりモデルの表現力が高くディープニューラルネットワークのような時におきます。

回帰タスクではMSE(平均二乗誤差)のルートをとったRMSE(平均平方二乗誤差)、そして外れ値の影響を受けにくいMAE(平均絶対誤差)などがあります。

混同行列では、縦軸が正解(陽性・陰性)で横軸が予測(陽性・陰性)で、(1、1)(1、2)(2、1)(2、2)成分は順に、TP(真陽性)、FN(偽り陰性)、FP(偽陽性)、TN(真陰性)です。適合率は確信性(precision)の高い予測のみを陽性としたいので、TP/(TP+FP)となります。再現率は実際の陽性のデータの見逃しを防ぎたい(recall)のでTP/(TP+FN)となります。F値はPとRの調和平均です。またAUCでは横軸にFPR(FP/(FP+FN))、縦軸にTPR=再現率をとって考えます。

適合率はPの形、再現率はRの形で覚えます。

オッカムの剃刀はある事柄の説明をするために必要以上に多くを仮定すべきでないことです。ノーフリーランチ定理はあるゆる問題において優れた汎化性能を持つモデルは存在しない定理です。AICはモデルの煩雑さと予測性能のバランスを考えたもので、-2logL+2k(Lはモデル尤度、kはパラメータ数)です。

黒本『徹底攻略ディープラーニングG検定ジェネラリスト問題集 第3版』での演習の次は、別の問題集『ディープラーニングG検定(ジェネラリスト)最強の合格問題集[第2版] [究極の332問+模試2回(PDF)] (まっすぐ合格シリーズ)』を用いた問題演習を行い更なる得点力の向上を目指します。

教師なし学習にはクラスタリングと次元削減があります。

過学習は、特徴量の数が多すぎる場合、学習データが不足している場合、モデルが複雑な場合、特徴量間の相関が強い場合に起こりやすいです。データリーケージは精度検証に使用するテストデータの一部が訓練データに混じってしまい汎化性能を正しく評価できなくなることです。機械学習は、損失関数(モデルの予測出力と正解の誤差を表す関数)を最小化するように学習します。Elastic Netはラッソ回帰とリッジ回帰を組み合わせた手法です。

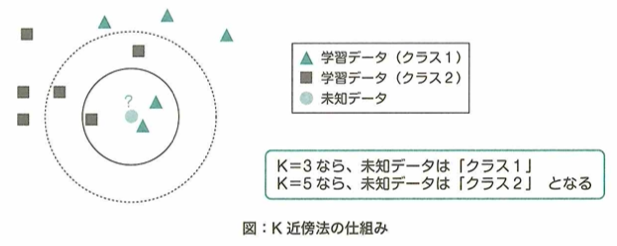

線形回帰は説明変数と定数項の線型結合で表します。カーネル法とはSVMで線形分離不可能なデータを非線形な関数(カーネル関数)で高次元空間に写像し、線形な決定境界(超平面)を求めることです。カーネルトリックはSVMで高速に計算できるように計算量を削減する技術です。ソフトマージンはSVMで新しいデータに対する汎用性を高めるために、誤分類をある程度許容する工夫です。非階層クラスタリングはデータ量が多い場合にも対応しやすいです。K近傍法(KNN)は学習データを特徴量で張られたベクトル空間上にプロットしておき、未知のデータから距離が近い順に任意のデータをK個取得し、多数決でデータが属するクラスを推定する距離ベースのアルゴリズムです。Kの値はユーザが決め、予測結果に影響されます。特徴量の数が多い場合は、次元の呪いが起きやすいので、高次元データには不向きです。ナイーブベイズ手法は確率論のベイズの定理をもとにした分類モデルで、文章の分類問題に利用されます。特徴量同士が無相関という単純化仮定を置くため、単語の出現頻度にのみ注目し、単語同士の関連性は考えません。t -SNEは高次元データを2次元または3次元に変換して可視化する次元削減のアルゴリズムです。

混同行列はクラス分類の精度評価の基準となる行列表現です。縦軸と横軸はそれぞれ正解クラスと予測クラスです。

適合率はPで始まる単語なので、式の分母はどちらもPが入ると覚えましょう。

回帰問題の精度検証では、MSE、RMSE、MAEなどが用いられます。ハイパーパラメータはユーザが指定するパラメータで、モデルの複雑さや学習の進行を制御することで、過学習を防ぎます。訓練データから一定量のバリデーションデータを取り出し、それを用いてハイパーパラメータの調整を行います。グリッドサーチとはユーザが複数種類のハイパーパラメータの値の候補を指定し、その中からベスト精度となる組み合わせを総当たりで探す方法です。ランダムサーチとは、あらかじめユーザが指定した範囲の中で、ランダムにハイパーパラメータを組み合わせて学習させ、最善の組み合わせを探す方法です。

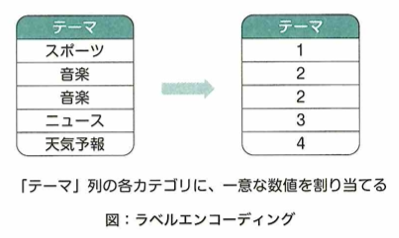

ラベルエンコーディングは1つのカテゴリが1つの数値に対応するようにマッピングを行うことで文字列をダミー数値に変更することです。One -Hotエンコーディングはカテゴリ毎に列を作り、各行について、1つの列項目だけを1、それ以外を0とします。不均衡データについて、特定のクラスに対し、他のクラスのデータ数が、極端に多い、または少ないデータです。そのまま機械学習のモデルの学習に使うと汎化性能が低下するので、事前に適切な処理が必要です。アンダーサンプリングはデータ数の多いクラスに属するデータを少なめにサンプリングします。オーバーサンプリングはデータ数の少ないクラスに属するデータを多めにサンプリングします。SMOTE(Synthetic Minority Oversampling Technique)はオーバーサンプリングの代表的な手法の1つで、少ない方のクラスのデータを、値が近いデータから予測してデータ量を増やします。

多クラス分類(マルチクラス分類)はクラスが3つ以上の分類問題です。マーケティングでの顧客セグメンテーションは教師なし学習のクラスタリングです。最初から来店客の種類や属性は知られていないので、教師ラベルを作ることが困難です。二値分類の例は、「洋服の種類を正解ラベルとする画像データ」、「診断結果を正解ラベルとするカルテのデータ」「赤字か赤字でないか」「来月退会するか、来月退会しないか」とします。回帰の例は、感情スコアなどです。半教師あり学習は、汎化性能が低くなります。また、精度も低くなります。教師あり学習と比べて特に計算コストが低いわけではありません。むしろ2段階で考えるのでコストは高くなります。

次文予測は自然言語処理の技術を用います。PCAでは相関が少ない合成変数に変換をすることでデータの次元圧縮を行います。異常検知は教師なし学習(教師あり学習より学習データの準備コストは低いです)の1例です。なぜなら異常の過去事例が少ないので、学習のための教師データを用意することが難しいからです。

クラスタリングは、マーケティング分野における顧客の分類、広告ターゲティング、レコメンド機能の最適化などを行います。

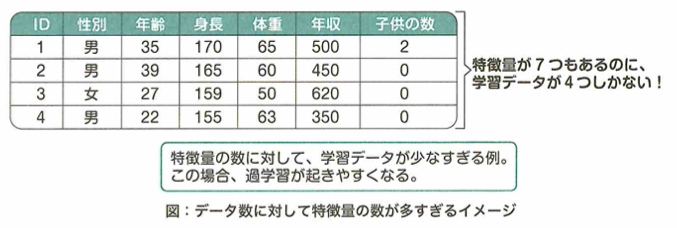

過学習は、モデルを訓練データに過剰に合わせ混みすぎてしまうことにより生じます。

特徴量の数が多すぎると同時に学習データが不足している場合、過学習が起きやすいです。

ハイパーパラメータを調整することで、モデルの複雑さを抑えることができます。また正則化を実施することで、モデルの動きに制限を課し、モデルが複雑になるのを防止します。バイアスとバリアンスはトレードオフの関係にあります。ばらつきの多いデータに複雑で高次元のモデルを当てはめるとバイアスは減るものの、バリアンスが高くなります。推定値もばらつきが大きく、未知データについて汎用性が低いです。一方で、全体としてばらつきが抑えられているモデルではバイアスは高くなりますが、バリアンスは小さくなります。このモデルは未知データに対してもそこそこ正確な推定値を出力できるので汎用性が高まります。バギングはバリアンスを小さくする効果があります。

ニューラルネットワークの訓練において、ミニバッチ毎にデータの正規化を行う操作は、バッチ正規化といい、過学習を抑える効果があります。

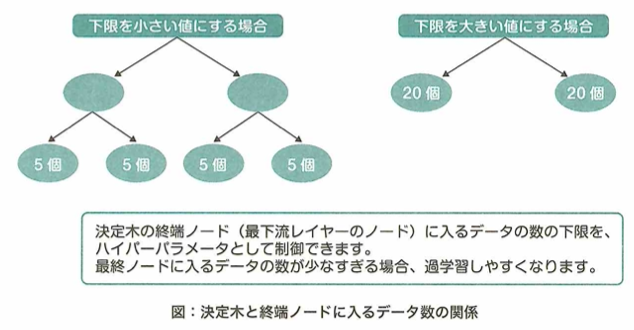

決定木がデータを分割する上で、情報の利得(分割によって得られるデータの明確さを表す指標)が最大になるように特徴量と閾値の組み合わせを最適化します。データ分割の際に1つのノードの中からデータクラスの不純度(誤って分類される割合)が低くなれば利得の値が大きくなります。エントロピーは情報の乱雑さ(正しく分類されていない程度)を表し、決定木の学習において最小化する指標の1つです。決定木の終端ノード(葉)に割り当てるデータの数(の下限)は手動で設定します。これはハイパーパラメータの1つです。デフォルトの値は1です。

アンダーフィッティングは過学習(オーバーフィッティング)の逆でモデルの学習不足を表します。誤差逆伝播はニューラルネットワークの学習の特徴の1つで損失関数の情報を出力層から入力層に向かって逆方向に伝播しながらパラメータの更新を行います。

各々の決定木を構築するとき、データと特徴量の両方をランダムにサンプリングします。データ(行方向)のサンプリングには重複を許す抽出を行うブートストラップ法を用います。特徴量(列方向)については全特徴量がM個とすると、通常は1本の木に√M個程度を抽出して使用します。ランダムフォレストでは訓練データから一部分を抽出し、少しずつ異なる決定木を多数構築し、それぞれの結果の多数決を採用します。

勾配ブースティングでは各弱学習器の予測誤差に関する情報を、後続で訓練する弱学習器が引き継ぎながら、それを参考に誤差を小さくしていくアンサンブル学習です。

SVMのソフトーマージンにおいて、スラック変数をパラメータとして導入します。

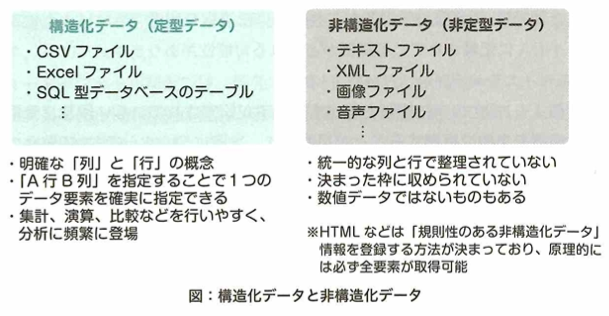

ディープラーニングは他の機械学習の手法と比べて非構造化データを解析することが得意ですが、構造化データを扱えないわけではありません。構造化データを用いた予測問題では、特徴量作りを人間が行えるのでディープラーニングではなく決定木などの、よりシンプルかつ解釈しやすい手法を使うことが多いです。ディープラーニングはブラックボックスです。

K -meansではKというパラメータはユーザが決めます。K近傍法は以下のようなイメージです。

偽陽性を減らそうとすると、陽性か陰性か判断しづらいときに陰性と判断する傾向があります。そうすると偽陰性が増えます。再現率を高くしようとすると、正確度でなく、適合率が低くなります。つまり再現率と適合率はトレードオフの関係です。カテゴリ毎の出現割合が極端に異なる場合、適合率と再現率を同時に見ることが望ましいです。適合率は、陽性判断の正確性を示す指標です。適合率を重視すると不確実性のあるデータは陰性と判断されがちなので、偽陰性が発生しやすくなり、陽性の見逃しが増えるので再現率が下がります。再現率とは陽性判断の網羅性を示す指標です。つまり実際に陽性だったデータのうち陽性として検出できた割合です。再現率を重視すると、不確実性のあるデータは陽性と判断されがちのため、偽陽性が増えるので適合率が下がります。

機械学習のパラメータとは、モデルの挙動に関する設定値や制限値です。その一部は学習のプロセスの中で自動的に最適化されます。例えばニューラルネットワークの重みや決定木の条件分岐の閾値などです。ハイパーパラメータは、例えばニューラルネットワークの学習率や隠れ層の数です。モデルの複雑さや進行を制御する役割を持っています。

カーネル関数は、ガウス関数、線形カーネル、多項式カーネル、シグモイドカーネルなどがあります。これはハイパーパラメータです。学習データは訓練データとテストデータに分かれます。ハイパーパラメータのチューニングは、訓練データから取り出した検証データで行います。

欠損値はデータの一部が空白(歯抜け)になっている状態で、放っておくと機械学習の精度を悪化させます。そのため分析前に欠損値が存在するデータを適切に処理します。該当列を削除しても他の列と予測モデルへの影響がほぼないと判断できれば、その時点で削除して良い場合もあります。

データクレンジングとは学習データからノイズなどの予測の妨げになるものや不要なものを取り除く操作です。白色化は相関をなくしてから正規化をすることです。正規化や標準化の目的は、学習が進みやすいようにデータを値が一定範囲内に収まるように変換することです。平滑化はノイズを除去するデータの前処理です。曲線をなめらかにするイメージです。

ディープラーニングの概要

G検定では、ニューラルネットワークが長年解決できずにいた問題の説明や、改善した手法についても理解しておく必要があります。

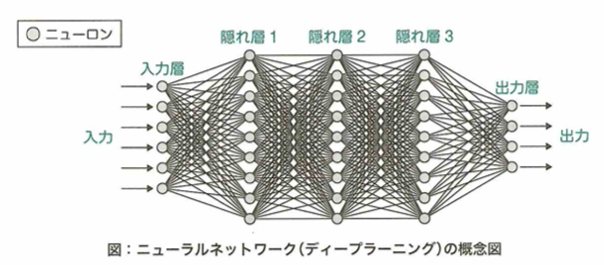

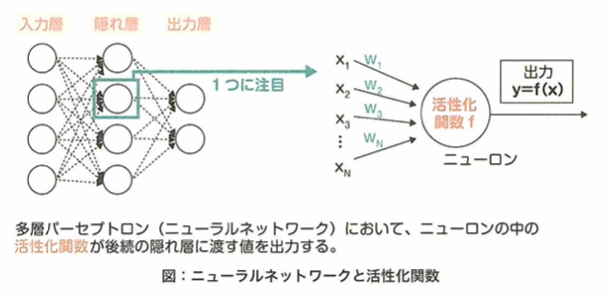

ニューラルネットワークとディープラーニング

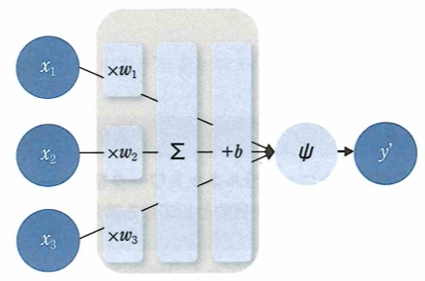

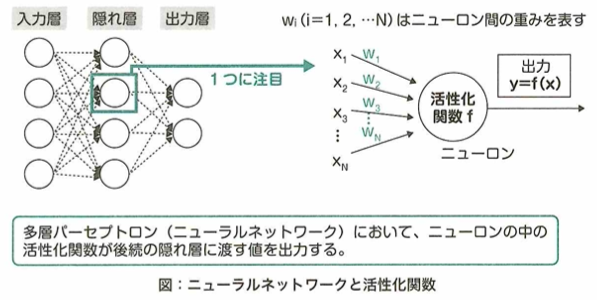

ニューラルネットワークにおける順伝播について重みはwです。

xは入力、bはバイアス、ψは活性化関数、y’は出力です。xを各ノードにし、y’を求めます。重みwとバイアスbを合わせてパラメータと呼びます。例えばアイスの売上を推定したいときに、x1が気温とすると、気温が最も売上に影響を与えるため、それに対する重みw1が大きくなるように学習します。

ニューラルネットワークモデルの構造

ニューラルネットワークは複数のニューロンが集まった層構造を内部に持ちますが、隠れ層に関して、中間層とも呼ばれます。入力と出力を対応づける関数に相当します。複数の層を持つことができます。

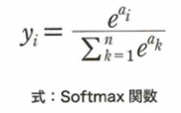

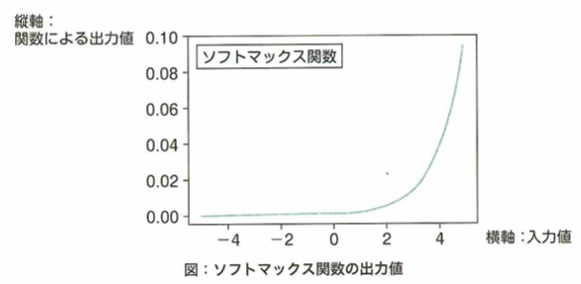

隠れ層のデザインの自由度は高く、その自由度の高さがニューラルネットワークの優れた表現能力の要因となっています。回帰問題では恒等関数が、分類問題ではソフトマックス関数が使われます。隠れ層の活性化関数にはシグモイド関数やReLU関数が使われます。

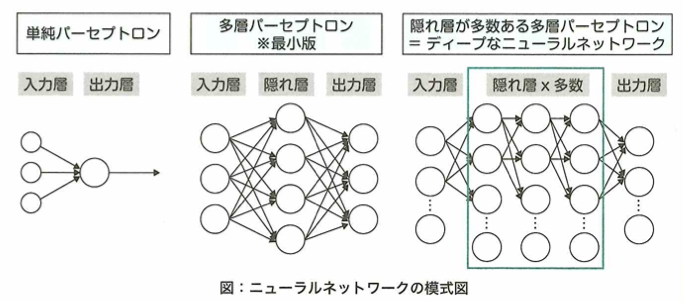

単純パーセプトロンと多層パーセプトロン

ニューラルネットワークの原点として単純パーセプトロンの特徴として適切なものは、隠れ層を持たないことです。

単純パーセプトロンは線形分類しか行えません。多層パーセプトロン(MLP)は1層以上の隠れ層が存在し、入力層と出力層を合わせて3つ以上の層が存在します。これにより非線形分類も可能です。

ニューラルネットワークの層の数と表現力

一般に隠れ層を増やしたニューロンネットワークをディープニューラルネットワークと呼びますが、隠れ層を増やす目的は、モデルの表現力を高めるためです。

層の数に対して表現力は指数関数的に上がっていきます。しかし層を増やせば学習時間も増えるので、他の事前学習済みモデルを目的のモデルの初期値に利用する、転移学習などの効率的な学習のための工夫が求められます。また、モデルの表現力が上がるほど、過学習の可能性が上がります。モデルの表現力が高いと、さまざまな関数を表現することがあるので、複雑な関数であっても過剰適合できてしまうためです。また、層を増やすことで重みが大きくならないようにできる効果はありません。

ニューラルネットワークの原点

ニューラルネットワークはもともと人間の脳の構造を真似しようと考えらえれた手法ですが、そこから解きたい課題の主題に応じて工学的にさまざまなアプローチが考えられ、さまざまなモデルが考案されました。

この原点である形式ニューロンは神経科学社・外科医のマカロックと、論理学者・数学者のピッツにより1943年に発表され、人工知能分野の研究に大きな影響を与えました。心理学者・計算機科学社のローゼンブラットは1958年に形式ニューロンを基にしてパーセプトロンを開発しました。1969年にミンスキーがニューラルネットワークの限界を指摘し、しばらくは人気の手法ではありませんでしたが、バックプロパゲーションの出現や活性化関数の工夫などを経て、今ではニューラルネットワークの層を深くしたディープニューラルネットワークを始めとし、さまざまなディープラーニングのモデルが登場して使わています。

ディープラーニングはニューラルネットワークを応用した手法

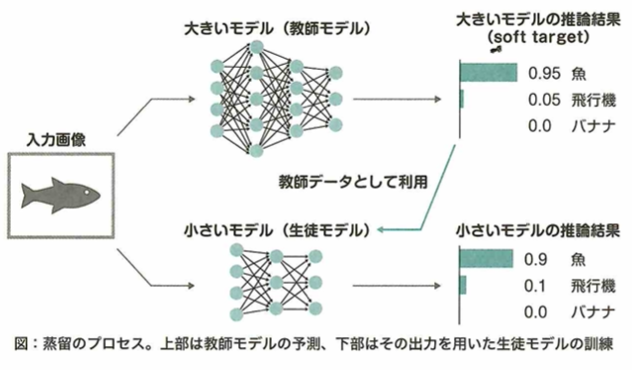

ディープラーニング(深層学習)では、大規模なラベル付けされたデータとニューラルネットワークの構造を利用して学習を行います。

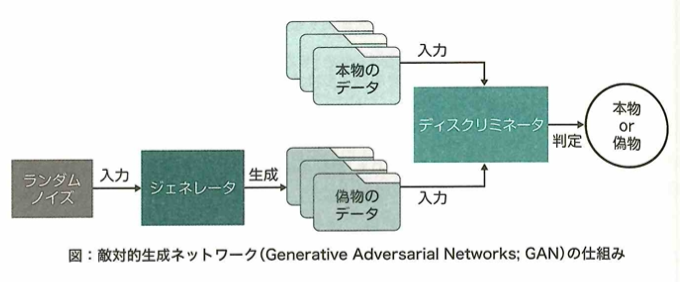

ディープラーニングのモデルはディープニューラルネットワークとも呼ばれます。データから直接特徴量を学習できるので、これまでのような手作業の特徴抽出は必要がなくなりました。GAN(敵対的生成ネットワーク)はGenerator(生成者)とDiscriminator(判定者)の2つのネットワークが競合することで学習されます。Gneratorが入力データに似たデータを生成し、Discriminatorがそれが「学習データ」か「Generatorが生成したデータか」を判定します。それらのネットワークを互いに競わせて入力データの学習を進めることで、徐々に生成データが本物に近づき、クオリティの高いデータを生成できます。強化学習では、将棋や囲碁などのゲームAIが打ち手を学習する際や、自動運転における状況判断の学習に活用されます。

信用割り当て問題と誤差逆伝播法

信用割当問題とは、一連の行動によってある結果が得られたとき、その結果に対して各行動の貢献度がどれくらいであるのかを求める問題です。この問題はニューラルネットワークにおいて、モデル出力に貢献しているパラメータが一体どれなのかを見つける問題として知られています。もし、この問題が解決できないと、どのパラメータを最適化すれば良いかわからないので、モデルの最適化が困難になります。ここで、ニューラルネットワークにおいて、この問題を解決した手法は誤差逆伝播法です。

勾配降下法は、あるパラメータの誤差に対する勾配が分かったときに、その勾配を用いて最適化するものです。グリッドサーチとはニューラルネットワークにおいて学習率などのハイパーパラメータの最適な組み合わせを探索するものです。主成分分析とは。多くの特徴量を少ない特徴量に縮約するために用いられる手法です。

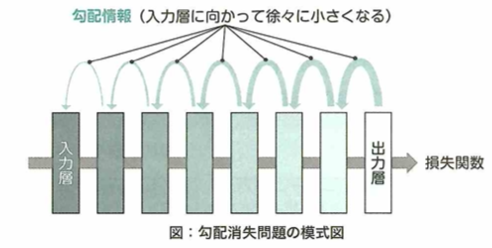

勾配消失問題

ニューラルネットワークを多層化することで生じる問題は勾配が消失し、学習が進みづらくなることです。

ニューラルネットワークを多層化すると、誤差逆伝播法においてそれぞれの層で活性化関数の微分がかかるので、勾配が消失しやすくなり、学習が進まなくなることを勾配消失問題と言います。活性化関数をシグモイド関数からReLU関数に変更したり、事前学習を行なったりすることでこの問題を回避しますが、複雑なモデルでは勾配消失問題は依然として課題となっています。

次元の呪いとは、扱いデータの次元が高くなるほど、計算量が指数関数的に増える現象です。トロッコ問題は、倫理学における思考実験の1つで、ある人を助けるために別の人を犠牲にして良いのか?を問うものです。状態行動空間の爆発は、強化学習における課題で、状態と行動の組みに対して定義される値を保存するための領域が極端に必要になってしまうものです。

ブラックボックス問題とは、AIの自ら膨大なデータを学習し、自律的に答えを導き出す特性上、その思考のプロセスが人間にはわからないということです。

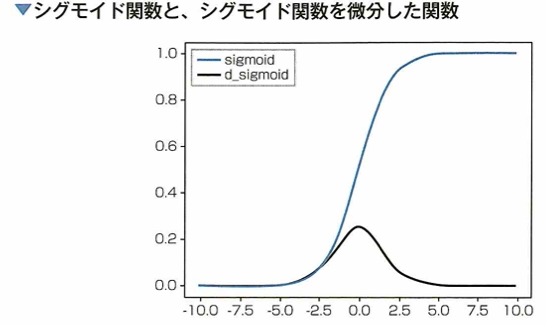

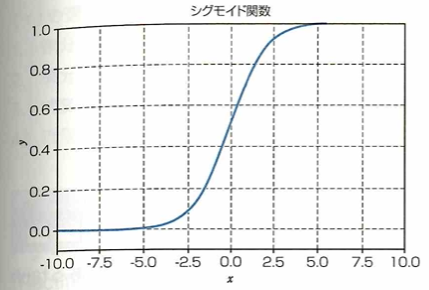

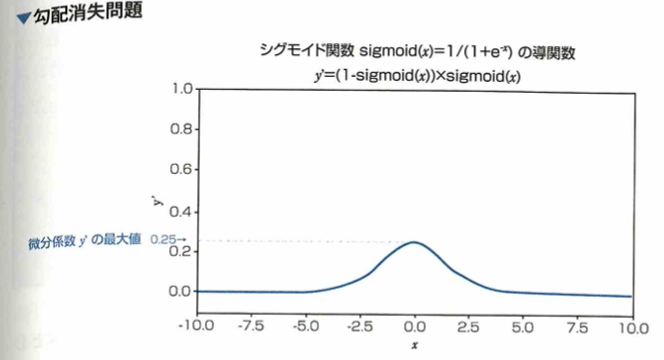

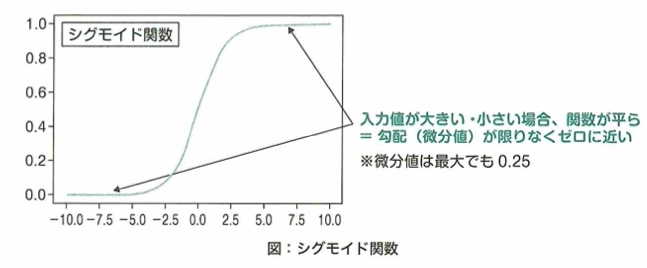

シグモイド関数の微分と誤差逆伝搬法の勾配消失

ニューラルネットワークにおいて、隠れ層を増やすと誤差のフィードバックがうまくいかなくなることがあります。大きな原因の1つにシグモイド関数の特性があります。これは微分すると値が小さくなることです。

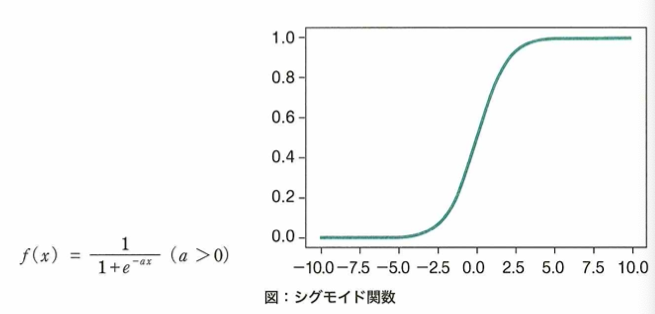

以前にニューラルネットワークの活性化関数として用いられたシグモイド関数についてのグラフは以下です。

シグモイド関数の微分の最大値は0.25です。これは1よりだいぶ小さいので、隠れ層を遡る(活性化関数の微分が掛け合わされる)度に伝播する誤差がどんどん小さくなります。その結果、入力層付近の隠れ層付近に到達するまでに誤差がなくなってしまうという問題です。これを勾配消失問題と言い、ニューラルネットワークを深くする大きな妨げになりました。現在では代わりにReLU関数を用いることで勾配消失が起こりにくくなりました。勾配が消失しやすいと、学習が進まなくなります。

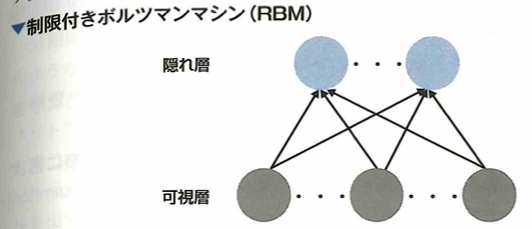

制限付きボルツマンマシン(RBM:resgtricted boltzmann machine)

ディープラーニングにおける事前学習(pre-training)は次元削減に役立つと言われます。その中でも制限付きボルツマンマシン(RBM)とは 2層のニューラルネットワークであり、深層信念ネットワーク(deep belief networks)の構成要素です。

ヒントンにより開発されたRBMは次元削減、分類、回帰などが可能です。

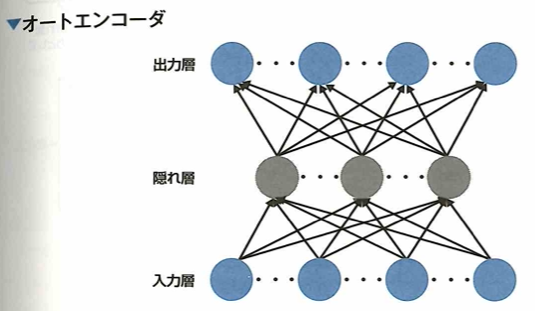

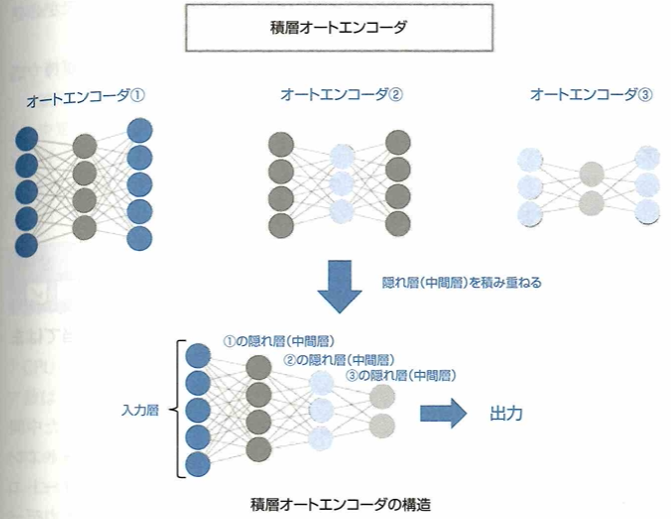

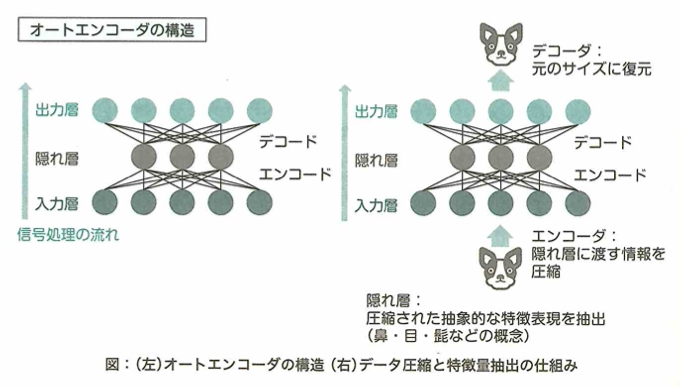

オートエンコーダは出力ユニットが直接入力ユニットに接続される単純な3層ニューラルネットワークです。情報量を小さくした特徴表現を獲得するので、出力を入力に近づけるように学習するニューラルネットワークです。ディープラーニング用に改良したものを積層オートエンコーダ(stacked autoencoder)です。

オートエンコーダも事前学習の1種であり、入力データの最も効率的でコンパクトな表現(エンコード)を見つけます。

事前学習によるアプローチ

オートエンコーダの構造

積層オートエンコーダー(stacked autoencoder)について、これは複数のオートエンコーダの隠れ層(中間層)を積み重ねたもので、次の構造をしています。

ここで積層オートエンコーダでは、勾配消失の問題を回避してニューラルネットワークの積み重ねを学習するために入力層に近い層から順に逐次的に学習を行うという方法で学習を行いました。

これによりそれぞれの層で重ねが調整済みとなっています。このようにオートエンコーダを順番に学習させていく手法を事前学習と言います。

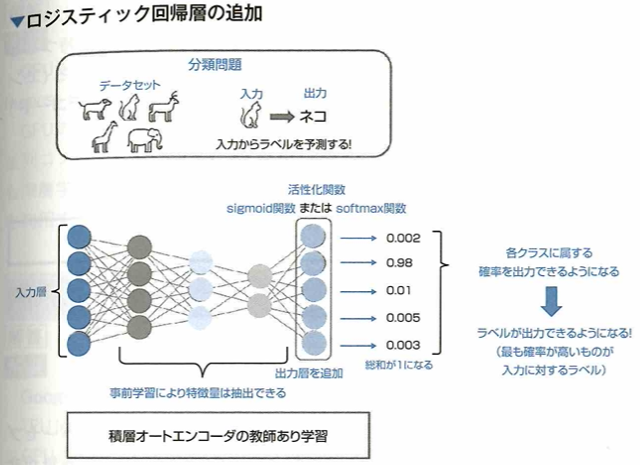

積層オートエンコーダにラベルを出力

積層オートエンコーダにおける事前学習は、入力と出力を同じものになるように学習を進めていきますが、これは教師なし学習です。事前学習によってデータに含まれる重要な特徴を取り出すことができます。一方で、分類問題や回帰問題といった教師あり学習を行うには、事前学習済みの積層オートエンコーダに出力層を追加し、調整を行うといった工夫が必要です。ここで、積層オートエンコーダで分類問題を解く際に追加する出力層が持つ活性化関数はsigmoide関数またはsoftmax関数です。

最後に追加する層は出力層です。二項分類の場合はsigmoid関数、多項分類の場合はsoftmax関数を出力層に考えます。回帰問題の場合は、出力層に線形回帰層を用います。このように新たな出力層を追加した場合は、出力層の重みを調整するためにネットワーク全体を学習して調整するファインチューニングが必要となります。積層オートエンコーダを用いるモデルでは、初めに事前学習によってデータの特徴量を学習し、その後出力層を追加してファインチューニングを行う2つの工程で構成されます。

オートエンコーダの入力データの特徴

オートエンコーダ(自己符号化器)について考えます。基本的にオートエンコーダとは、入力と出力の形が同じになるようにした中間層を1つ持つニューラルネットワークです。ここで、オートエンコーダでは、入力と出力が同じものになるように学習を行います。このときオートエンコーダでは、中間層の次元数を入力層の次元より小さくするような構造にすることで、入力データに含まれる重要な特徴を抽出できます。

一般的にオートエンコーダは入力層の次元数と比べて中間層の次元数が小さくなるような構造をしています。このような構造により、オートエンコーダでは入力されるデータの情報を圧縮している(エンコード)と共に、圧縮されたデータから元のデータを復元している(デコード)と考えることができます。

ハードウェア

ディープラーニングとGPUの相性の良さ

ディープラーニングの根幹のパーセプトロンのアルゴリズム自体は1950年代に提案されましたが、莫大な計算量が必要なものや、SVMなどが人気であったので、長き日に渡り日の目を見ませんでした。近年では、その学習が並列計算と相性が良いことから、GPUを利用して短時間での学習が行われています。

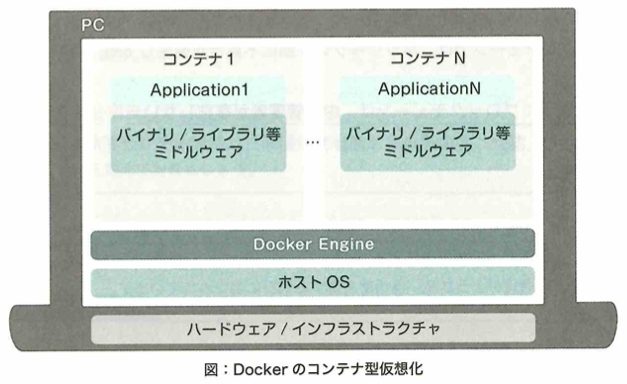

ディープラーニングのアイデアや技術自体は多層パーセプトロンの形で昔からありましたが、層を深くした時の計算量が非現実的でした。計算は行列の積和演算で、これは画像やCGの分野でポリゴンの処理が得意なGPUに向いている計算です。近年はこの相性の良さが注目され、畳み込みニューラルネットワーク(CNN)などのアイデアが次々と実現可能となりました。

CPU

CPUの主な役割はコンピュータ全体の計算であり、複雑な命令の逐次計算な計算を得意とします。CPUのコア数は通常数個であるのに対し、GPUのコア数は数千個です。

CPU(central processing unit)はコンピュータ全体の処理を担います。メモリやハードティスクなどの周辺機器とデータをやり取り・制御しています。そのコアは少数で高性能で、多様なタスクを順番に処理していくことに特化しています。

GPGPU

GPUは画像処理に特化したプロセッサで、GPUを用いて汎用的な演算を行わせるための技術であるGPGPUを適用することで、ディープラーニングに応用できます。NVIDIA社が提供する汎用並列コンピューティングプラットフォームにCUDAがあります。

GPGPU(general-purpose computing on GPU)の主要メーカーのNVIDIA社が開発したCUDAはGPU向けの汎用並列コンピューティングプラットフォームです。深層学習のフレームワークは、Keras、PyTorch、Tensorflowなどです。

TPU

Googleが開発する、ディープラーニングの学習・推論に最適化された計算ユニットにTPUがあります。ディープラーニングでは演算の精度(倍精度演算など)がそこまで求められていないので、精度を犠牲にすることで高速化を行なっています。GPUなどは演算中の途中結果をメモリに読み書きしますが、TPUでは回路内で結果を渡すことでメモリへの読み書きを減らし、高速化を図っています。

TPU(tensor processing unit)はディープラーニングの学習・推論に最適化されており、タスクによってGPUの数十倍のパフォーマスを発揮します。Googleの提供するクラウドサービスGCP(google cloud platform)上で使用でき、誰でも簡単に試せます。

以下、黒本『徹底攻略ディープラーニングG検定ジェネラリスト問題集 第3版』の該当章の大事なポイントの復習です。

能動学習はアノテーション対象のデータの中から学習することで性能向上が見込めるものを戦略に従って選び抜き、限られたコストで精度の高いモデルを開発することを狙う手法です。データが少ない場合は過学習が起きやすくなります。ディープラーニングはブラックボックスです。単純パーセプトロンは線形分離不可能な問題を扱えませんが線形分離可能な2クラス分類問題を解くことはできます。

GPUは並列処理を得意とする演算処理装置です。ただし条件分岐を含むなどして処理方法が異なるような演算を同時に処理することは不得意です。画像処理以外に開発されたGPUであるGPGPU(General-purpose computing on GPU)はディープラーニングの学習を効率的に行うことができます。Googleはテンソルの計算処理に最適なTPUという装置を開発しました。

Leaky ReLUはReLU(これらの関数は隠れ層で使用します。線形関数(恒等写像関数)は主に回帰タスクの出力層の活性化関数として使用します)に改良を加え、入力が負の場合は入力に0.01などの小さな値を乗じて出力します。それ以外はReLUと同じです。そのため傾きが一定の線形関数ではありません。また、入力が0以上の場合は非線形な出力はしません。そのため勾配消失問題が発生しにくくなっています。

ニューラルネットワークの隠れ層における活性化関数は非線形な関数を使用します。これにより隠れ層で非線形変換を繰り返すことで、線形分離不可能な複雑な問題を解くことができます。隠れ層における活性化関数では、入力や出力に関する制約はありません。

損失関数(誤差関数)において回帰タスクではMSEが使用されます。分類タスクでは交差エントロピーを使用します。KL情報量は2つの確率分布の異なり具合を測る指標です。機械学習で交差エントロピーを最小化することとKL情報量の最小化は同義です。 MAE(平均絶対誤差)は回帰タスクで使用されます。

深層距離学習とはデータのペアに対して対してニューラルネットワークを用いてその類似度を学習する手法です。ここでは2つ以上のデータの組に対して距離の情報を考慮した損失を計算します。代表的な損失として、Contrastive Loss、Triplet Lossがあります。前者は画像データをベクトルに変えたものの画像データの距離です。後者は3つのデータの組みを使用して計算する損失です。

L0正規化は0でない大きさを持つパラメータの総数を損失関数に加える手法です。L1正規化はパラメータの大きさの絶対値の総和を損失関数に加える手法で、L2正規化はパラメータの大きさの2乗和を損失関数に加える手法です。

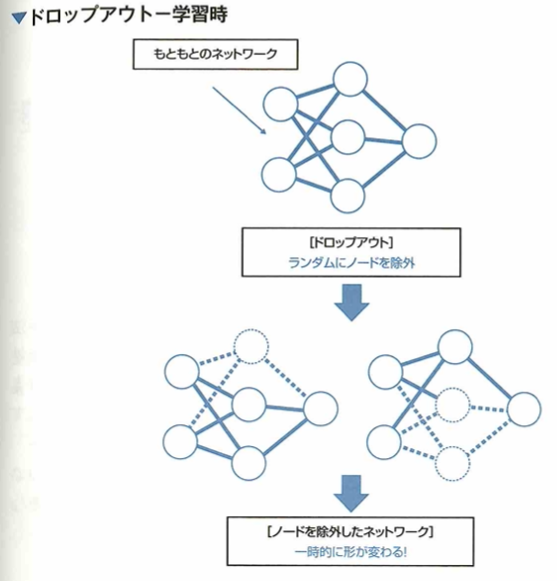

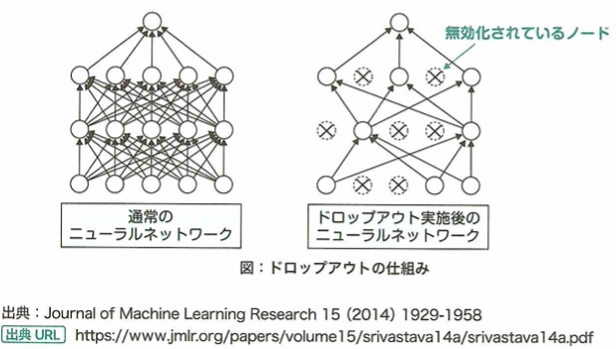

ドロップアウトは過学習を防ぐ手法です。ランダムにニューロンを除外する手法です。訓練時にランダムに選ばれたいくつかのニューロンの重みを0として計算します。学習のたびに除外されるニューロンがランダムに決まるので、毎回異なる構造のネットワークを学習することになるので、アンサンブル学習とみなせます。

信用割り当て問題とは、ニューラルネットワークにおいて、各ニューロンが出力を改善するために、予測結果からどのようにフィードバックを受ければよいかに答えることが簡単ではないことです。

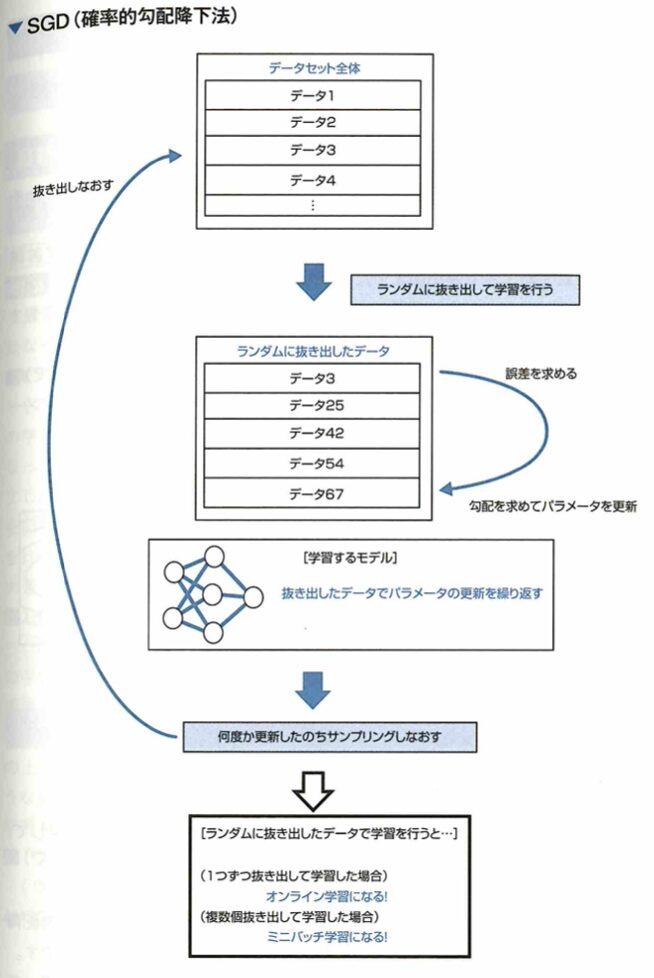

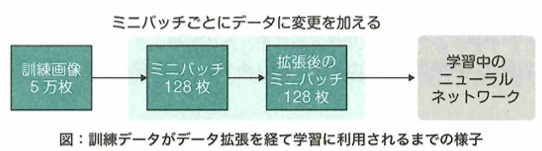

確率的勾配降下法について、勾配降下法が勾配の計算に全ての訓練データを用いることで計算量が増大する問題を解消することに対し、確率的勾配降下法は、訓練データからランダムに抽出した一部のデータを使用して勾配を推定することで学習を高速化します。これを一般化して訓練データから一部のデータをランダムに取り出して学習する手法をミニバッチ学習と言います。訓練データから一度に1つのデータのみを取り出して学習する手法をオンライン学習と言います。

モーメンタムは勾配降下法における学習率を学習中に適度に調整することで鞍点などの学習の停滞を防ぐ手法です。学習率とは勾配降下法において求めた勾配に従ってどの程度パラメータを更新するかを決定する定数(ハイパーパラメータ)のことです。勾配降下法の発表が古い順に、モーメンタム、NAG、AdaGrad、AdaDelta、RMSprop、Adam、AdaBound、AMSBoundなどがあります。最後の2つは同じ論文で提案されたものです。

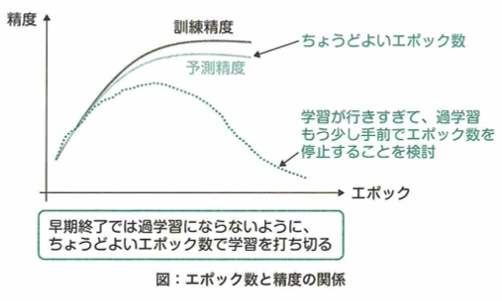

エポックとは訓練データ全体に対する学習の反復回数を表す概念です。1エポックは、全ての訓練データを1度ずつ用いてパラメータを更新した時で定義します。パラメータの更新は主に確率勾配降下法で行われるので、実際のパラメータの更新は訓練データからサンプリングした一部のデータによって行われます。このパラメータ更新の単位がインテレーションです。複数回のインテレーションによってパラメータの更新を繰り返し、全ての訓練データを一巡した段階が1エポックとなります。早期終了とは学習時のエポックとともに検証データにおける誤差を評価し、この誤差がエポックを進めても改善しなくなった時点で学習を打ち切ります。二重降下現象は、横軸をインテレーションやエポック、縦軸に汎化誤差をとった時のグラフで表現できます。二重降下現象は学習中に減少していたテストデータに関する誤差が一度増えた後で再び減少する現象です。

ハイパーパラメータは学習可能なものではありません。このため学習と汎化誤差の評価を繰り返して最適な組み合わせを行います。これをチューニングと言います。代表的な手法としてグリッドサーチとランダムサーチがあります。前者は全ての組み合わせを網羅的に探索し、後者はランダムに選択して探索しますが、最適な組み合わせが見つかるとは限りません。

ディープラーニングの手法(1)

理論的な側面に加えて、多くの用語の違いまで出題されます。それぞれの内容の流れと用語を理解して、区別できるようにしておきましょう。

活性化関数

シグモイド関数

シグモイド関数y=1/(1+e^(-x))は入力x(全ての実数)に対して、出力yの範囲は0≦y≦1となります。近年では、この関数はニューラルネットワークの隠れ層の活性化に用いられることは減っていますが、その理由は勾配消失が起きやすい特徴からです。

ニューラルネットワークでは最適なパラメータを見つけるため誤差を逆向きに掛け合わせて伝播させていく誤差逆伝播法が用いられます。この伝播中に活性化関数の微分を掛け合わせる項がありますが、シグモイド関数では最大で0.25であり、この項を掛けるごとに誤差の値は小さくなり、入力付近に近い層ほど伝播すべき誤差がなくなってしまう勾配消失問題が起きやすくなります。

出力層での活性化関数の特徴

出力層で用いられる活性化関数は出力を確率で表現するため、特定の活性化関数が使われます。二値分類ではシグモイド関数が、多値分類ではソフトマックス関数が用いられます。

ソフトマックス関数はシグモイド関数の一般形で、複数の入力を受け取り、受け取った数と同じ個数の出力を総和が1となるように変換して出力します。

ReLU関数は出力の値が[0,1]に限らないので、出力を確率として表現することは難しいです。

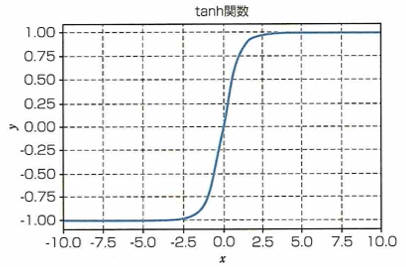

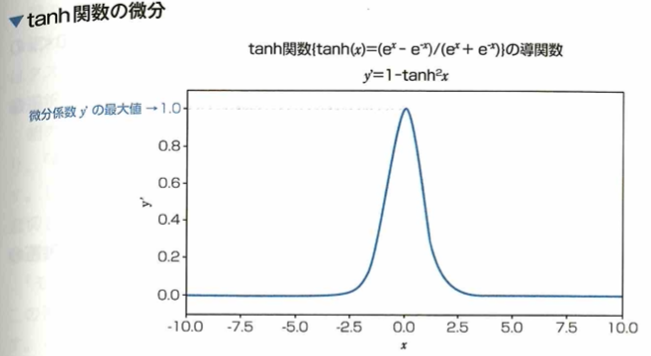

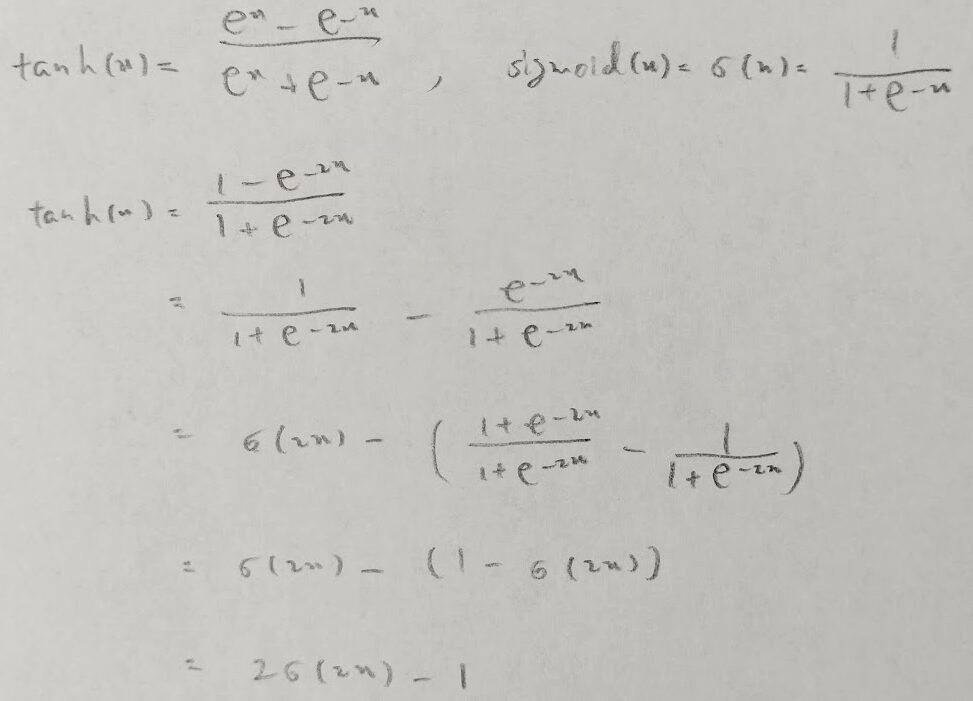

tanh関数とシグモイド関数との関係性

ニューラルネットワークの隠れ層で用いる活性化関数であるtanh関数について、シグモイド関数では、任意の実数で微分したときの最大値が0.25であることに対して、tanh関数は微分したときの最大値がより大きくなるようになっています。このためシグモイド関数と比べて、活性化関数にtanh関数を用いた場合、誤差逆伝搬法を用いて重みなどのパラメータを計算した際に勾配消失問題が緩和されています。またtanh関数はシグモイド関数を式変形(線形変換)することで求めることができます。

微分のおける最大値が大きいから言って、根本的な勾配消失問題の解決には至りません。

またtanh関数(=(e^x-e^(-x))/(e^x+e^(-x)))はシグモイド関数(sigmoide(x)=1/(1+e^(-x)))を用いてtanh(x)=2×sigmoid(2x)-1とかけます。

tanh関数は活性化関数に用いられる関数の1つで、入力xの値を−1≦x≦1の範囲の値に変換します。主に隠れ層(中間層)で用います。

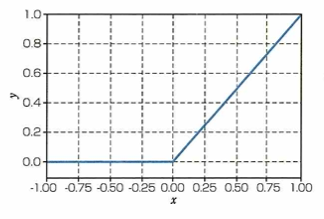

ReLU関数

ディープラーニングで使われる活性化関数の1つであるReLU関数(rectified liner unit)は、多くの種類のモデルでよく使われている活性化関数です。ReLU関数はシグモイド関数やtanh関数と比べて大きく異なった形をしていますが、数式ではy=max(0,x)と簡単に表せます。グラフは下図になります。

これまでの活性化関数より勾配消失問題が起きにくいですが、どんなタスクにおいてもReLU関数を使うことがベストではありません。この関数は非線形の関数であり、x≦0の時は微分係数は常に0、x>0の時の微分係数は常に1となります。

学習の最適化

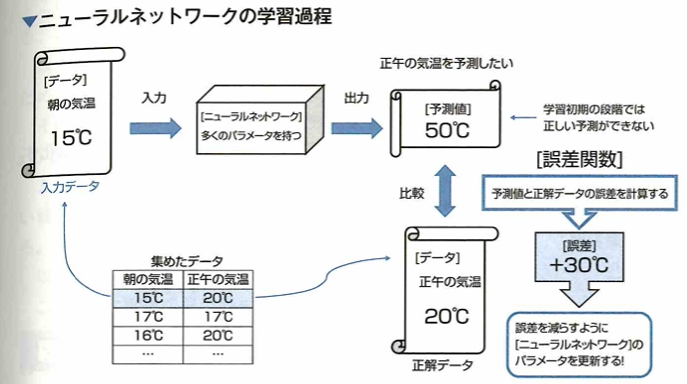

誤差関数

ニューラルネットワークの目標はモデルの予測値を実際の値に近づけることであり、この目標を達成するために誤差関数を最小化するアプローチが取られています。朝の気温から正午の気温を予測するモデルを考えます。朝の気温と正午の気温のセットのデータを所持している状態で、朝の気温の平均が16℃で正午の気温の平均が18℃という統計量が求まりました。このデータから朝の気温から正午の気温を予測するモデル(ニューラルネットワーク)を作るとき、次のイメージになります。

このときの誤差関数は朝の気温に対するモデルの予測値と対応する正午の気温の気温との誤差のように定義されます。

誤差関数とは、モデルの予測値と実際の値(正解データ)との誤差を表した関数です。

傾きの概念

関数の傾きの定義はΔy/Δxです。

微分係数と関数の最小値

上の関数において、x=1のときにyは最小値を取りますが、このxが未知の場合を考えます。初期値としてx=0.5と設定します。この値の微分係数を求めると符号はマイナスです。これを踏まえて初期ちから未知の最小値x=1に近づく方向に進ためには、xの値をxから微分係数を引くように更新すれば良いです。その後に、更新したxの値で再び同じ作業を繰り返せばx=1の値にどんどん近づきます。また、この際にその時の微分係数は0に非常に近くなるので、それ以降の更新によりxの値は変化しにくくなることがわかります。

実際には学習率という数値を導入してxを更新する際の変化量を調整します。

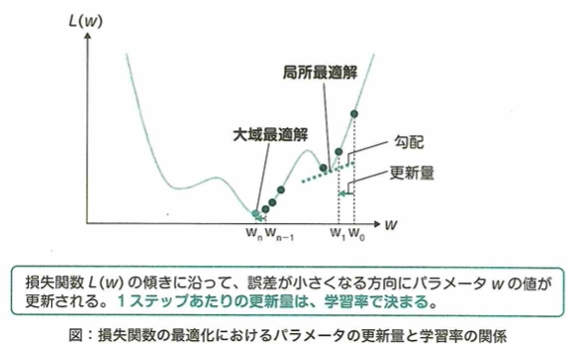

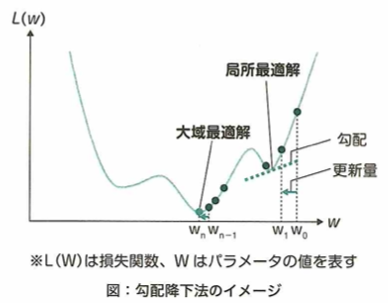

学習率

勾配降下法における学習率について考えます。関数の勾配にあたる微分係数に沿って降りていくことで、最小値を求める手法を勾配降下法と言います。学習率とは勾配に沿って一度にどれだけ降りていくかを設定するものという役割を持ちます。学習率とは、勾配降下法においてパラメータxを更新する前に微分係数に掛かる0より大きい実数です。学習率は勾配降下法において重要な要素の1つで、設定によっては最適解が得られない場合があります。

勾配降下法によりパラメータが最適解にどれだけ近づくかは、同じ学習率でも関数の形や勾配を求めるパラメータの位置で変化します。また現在の値から更新後の値までの距離は、現在の値における勾配の大きさと学習率で決まります。

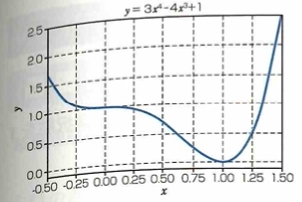

勾配降下法は大域最適化に必ず収束しない

勾配降下法の収束値について考えます。

この関数において、勾配降下法を用いて最小値を探します。xの初期値と学習率をあらゆる値で試したとき、xが収束する可能性がある値は-3、0、6です。ただし学習率の範囲は(0、1] とします。このため勾配降下法は確実に最小値を見つけることができるわけではありません。この関数において真の最小値はx=6のときの値ですが、この真の解を大域最適解といい、x=ー3のような局所的な解を局所最適解と言います。

パラメータが大域最適化に収束しやすい学習率

この関数について初期値をx=ー6に設定して勾配降下法を用いたら、局所最適化のx=−3に収束しました。そのため初期値はそのままにして、学習率を調整するアプローチで大域最適化に収束しやすくすることを考えます。このときインテレーションが少ない段階において学習率は大きくなるように設定すると良いです。インテレーションとは勾配降下法においてパラメータの更新回数のことです。そうすることで、局所最適解と大域最適解の間にある一時的にyの値が大きくなる領域を超えて大域最適解に近づくことが可能です。一方で学習率が大きいのままだと大域最適解付近においても最適解を飛び越えてパラメータの更新を続けてしまうという問題が起きやすくなります。そのため学習率を適切なタイミングで調整し直すことが大事です。

学習率が大きいままであることが原因で、計算誤差が蓄積することはありません。また学習率が大きいままであることが原因で、収束する値が初期値に依存することはありません。しかし、学習初期から学習率が小さい場合においては、初期値に近い局所最適解や大域最適解に収束しやすくなるとは考えられます。エポックとは1つの訓練データを何回学習させるかのハイパーパラメータです。

鞍点

鞍点について考えます。3次元以上の関数に対して勾配降下法を用いる際は、鞍点が学習のうまくいかない原因となることがあります。鞍点は一般的に平坦な領域に囲まれている場合が多く、一度鞍点に陥ると再び鞍点から抜け出すことは困難になります。このような停滞状態にあることをプラトーと言います。

鞍点とはある次元から見ると極大点で、ある次元から見ると極小点となる点です。

確率的勾配降下法(SDG)

ニューラルネットワークの学習では、パラメータに対して最適な値に近づく勾配を求めることが大事です。訓練データをネットワークに入力し、結果(出力)を求めて、その結果と正解の誤差を計測します。このように求めた誤差を減らすことを考えてパラメータを最適化する勾配を求めることができます。最急降下法(Gradient Discent)ではデータセットを全てネットワークに入力して誤差を求め、パラメータを更新することを繰り返します。SDG(Stochastic Gradient Discent)確率的勾配降下法はパラメータxを更新する際に、データは全データの中からデータをランダムに抜き出して利用します。このようにしたときSDGのパラメータを更新する式はx_new=(x_old)×学習率×(抜き出したデータを使って求めた勾配)です。

データセット内のデータを全て用いる手法はバッチ学習と呼ばれ、最急降下法はこのバッチ学習の一種です。対して、データを1つずつ逐次的に学習する手法をオンライン学習、いくつかのデータのまとまりを逐次的に用いて学習する手法をミニバッチ学習と言います。SDGは最急降下法をオンライン学習またはミニバッチ学習に適用したものです。

SDGにおいては求めた勾配を用いてパラメータを更新するとき単純に学習率をかけてパラメータから引くことで更新します。この時の勾配は、ランダムに抜き出されたデータを用いて求めた勾配です。SDGに工夫を加えて改良した手法は、モーメンタム、RMSPropがあります。これらの手法は勾配を求めるところまではSDGと同じですが、SDGでは単純に勾配に学習率をかけて引いていた部分に改良を加えることで、良い手法になっています。

モーメンタム

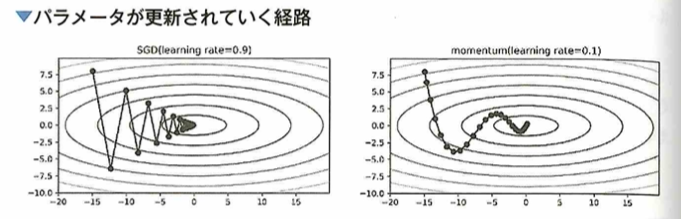

分配下降法の手法について考えます。ニューラルネットワークの学習において基本的な手法であるSGD (Stochastic Gradient Descent: 確率的勾配下降法) は、最急降下法を改良したものの1つです。しかしSGDには局所解に陥ってしまう問題や非効率な経路で学習してしまうといった問題があるので、SGDに改良を加えたモーメンタムと呼ばれる手法が考えられました。この手法自体はディープラーニングブーム以前の1990年代から考えられています。このモーメンタムと呼ばれる手法は、力学の考え方を用いてパラメータの更新に慣性的な性質を持たせ、勾配の方向に減速・加速したり、摩擦抵抗によって減衰したりしていくようにパラメータを更新していくという工夫を加えることでSGDを改善し、学習をより効率的に行えるようにしたものです。

モーメンタムを用いることで最小値まで辿り着く経路がSDGと比べて無駄の少ない動きとなっているとともに、停滞しやすい領域においても学習がうまく行きやすくなるメリットがあります。

勾配降下法の最適化手法

勾配降下法の手法について考えます。ニューラルネットワークの学習において鞍点などに陥る問題に対処するため、ディープラーニングブーム以前からモーメンタムと呼ばれる慣性の考えを用いる手法はありました。その後ディープラーニングのブームを受けてモーメンタムより効率的なさまざまな手法が考えられました。これらはモーメンタム同様に求めた勾配を用いてどのようにパラメータを更新するのかという部分に工夫を加えたものです。古いものからAdaGrad→RMSProp→Adamという手法が考案されています。AdaGradは求めた勾配によりパラメータごとの学習率を自動で調整するものです。RMSPropはAdaGradの学習のステップが進むと、すでに学習率が小さくなり更新されなくなってしまう問題を改良したもので、AdamはRMSPropのいくつかの問題点をさらに改良したものです。

SDGでは手動で学習率を決めてすべてのパラメータに対して同じ値を用いていましたが、AdaGradでは勾配の情報を用いてパラメータごとの学習率を自動で調整していくアルゴリズムです。AdamはRMSPropを改良したもので、2014年に発表されました。

最新のディープラーニングの最適化手法

ディープラーニングを最適化する手法はたくさん提案されています。その1つであるSGD(Stochastic Gradient Descent:確率的勾配下降法)は、学習率を固定してパラメータを更新していきます。これに対しAdamは学習率を動的に求めることで学習速度をSGDに比べて速めることに成功しましたが、Adamの学習率は重要でない勾配に対して大きすぎたり、重要な勾配に対して小さすぎたりすることがあり、学習がうまくいかない場合がありました。そこで重要でない勾配に対して2乗勾配を利用して学習率が大きくなりすぎることを改善するAMSGradという手法が提案されました。しかし、これは学習率が小さくなりすぎることを考慮していないため、学習率の上限と下限を設定し、少しずつ狭めて最終的に1つの値となるようにする手法が生まれました。その手法は2つあり、Adamに対して適応した手法がAdaBound、AMSGradに対して適応した手法がAMSBoundです。これらは学習前半でAdamのように高速に学習し、学習後半でSGDのような学習をします。

AMSGradは、「Adamの学習率が大きくなりすぎることがある」という問題を解決した手法となっています。Adamでは学習率の変化を過去からの勾配情報を用いて行っていましたが、昔の勾配情報を長期的に残すことが困難だったため、重要な勾配情報を忘れてしまうことがありました。AMSGradは現在の勾配情報と過去の勾配情報を比較して重要な方を選択し、保存しておくことで不必要な勾配に関して学習率が大きくなりすぎることを防いでいます。

AdaBoundは「Adamの学習率が大きくなりすぎることや、小さくなりすぎる」という問題を解決した手法となっています。AdaBoundはAdamの学習率の変化に対して、学習率に上限と下限を用意し、その範囲を超えないように学習率を設定します。さらに学習率の上限と下限の幅を次第に狭めていき、最終的に一定値とすることでSGDのような効果を学習後半で期待します。これにより学習前半はAdamのような高効率な学習を行い、学習後半ではSGDのような正確な学習を行うことができます。AMSBoundはAMSGradに対してAdaBoundと同じ手法を適用させたものです。

かなりややこしい部分なので時系列的にまとめます。

最小値を求めたい→学習率→SGD→モーメンタム→AdaGrad→RMSProp→Adam→AMSGrad→(Adamに対して)AdaBound、(AMSGradに対して)AMSBound

ハイパーパラメータ

ハイパーパラメータとは、ニューラルネットワークの学習率や、決定木の深さなど、人が設定するパラメータのことです。機械学習モデルでは、ハイパーパラメータを適切に設定することで学習速度が上がったり、汎化性能が向上したりすることが期待できます。そのハイパーパラメータを探索することをハイパーパラメータチューニングと言います。

ハイパーパラメータチューニングをする方法の1つとして、kー分割交差法を用いた検証を行い評価します。ハイパーパラメータチューニングは、考え得るハイパーパラメータの組み合わせから1つの組を選び、それの学習結果を見て、学習時のハイパーパラメータの良し悪しを決めます。そのハイパーパラメータの選び方として、グリッドサーチとランダムサーチがあります。それぞれの手法特徴はグリッドサーチは考え得るハイパーパラメータの組み合わせを全通り選択し、ランダムサーチはランダムに組み合わせを選択します。

グリッドサーチは、考え得るハイパーパラメータの組み合わせを全通り選択する探索方法です。グリッドサーチは最も良い組み合わせを見つけることができますが、ハイパーパラメータが多いと探索コストが非常に大きくなります(例えば、3つハイパーパラメータがあり、それぞれが5つの値を持っている場合、その組み合わせは5の3乗の125回検証が必要です)。ランダムサーチは、ハイパーパラメータの組み合わせをランダムに選択する探索方法です。グリッドサーチより少ない回数で探索できますが、最適解を見つけられるかはわかりません。そのほかにもベイズ最適化というのもあり、これは結果が良かったハイパーパラメータの組み合わせに似た組み合わせをランダムに探索していきます。

さらなるテクニック

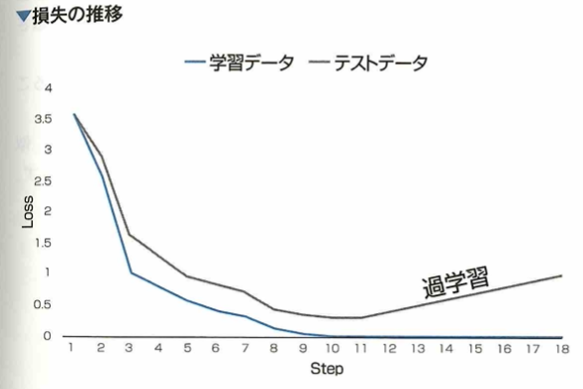

過学習

過学習(オーバーフィッティング)とは、機械学習においてモデルが訓練データに過剰適合することです。過学習が進んでしまっているとき、モデルの予測値と訓練データの間の誤差は十分小さな値に収束する傾向があります。一方でモデルの予測値とテストデータ(学習に用いていないデータ)との間の誤差はだんだん増加していく傾向があります。すなわち、過学習が進んでしまうとモデルの実用性が落ちてしまいます。

二重降下現象

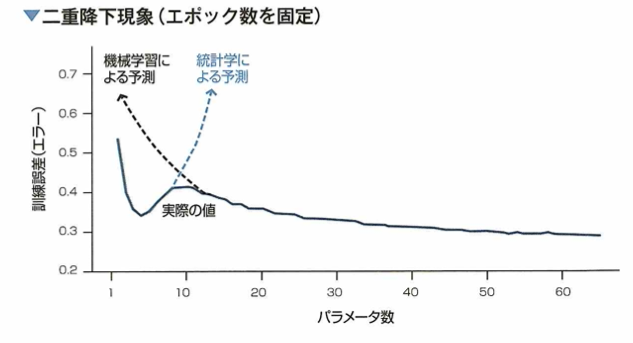

二重降下現象は、モデルのパラメータ数やエポック数を増やすと学習結果のエラーは下降していくが、さらに増やすと上昇して、さらに増やすと下降していく現象です。

二重降下現象とは、モデルのパラメータ数や学習のエポック数(エポックは学習データセット全体を使った一回の学習プロセスを指します)が増えるたびに、学習結果のエラーが二度降下する現象です。上の図においてエポック数は固定します。ことのき機械学習による予測も、統計学による予測もそれぞれ裏切られることになります。二重降下現象の起きる原因は解明されておりません。

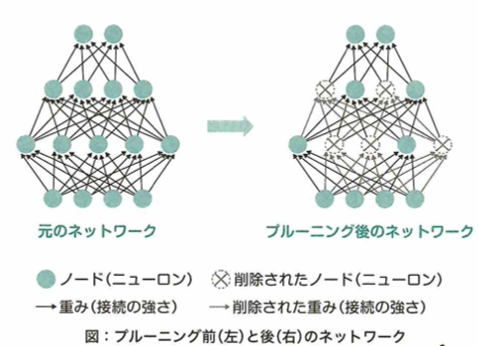

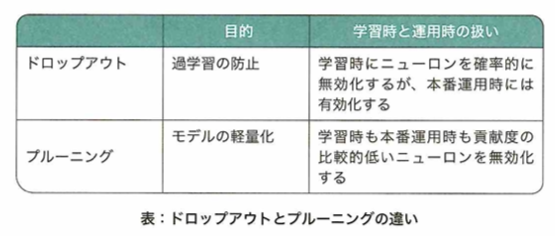

ドロップアウト

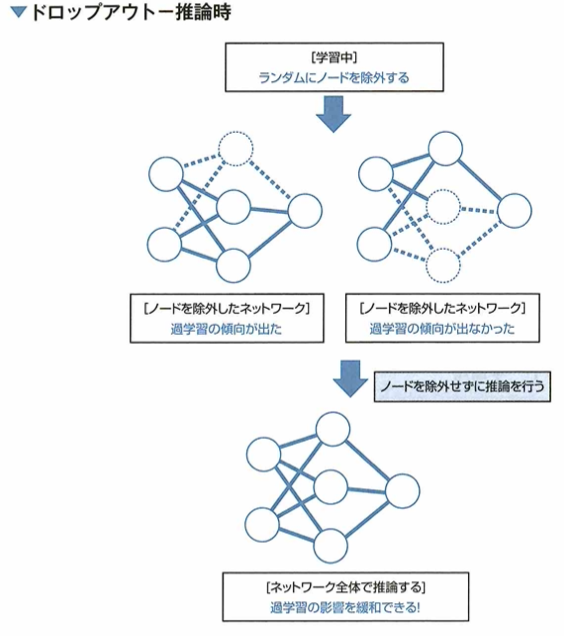

ドロップアウトについて考えます。過学習が進んでしまうとモデルの汎化性能が落ちてしまいます。この問題に対して、ニューラルネットワークの学習においては過学習を防ぐ手法の1つにドロップアウトがあります。ドロップアウトとは、学習の際、一部のノードを無視して学習を行う手法です。すなわち、ドロップアウトによってノードを無視するのは学習時のみで、推論時は除外しません。ドロップアウトにより、学習中のニューラルネットワークの形は更新のたびに異なる形となると考えられます。つまり、ドロップアウトを行った場合、複数のネットワークが同時に学習されることになります。このようにすることで、複数のネットワークのうち、いくつかが過学習してしまったとしても、全体として過学習の影響を抑えることができます。すなわち、ドロップアウトはアンサンブル学習を行っていると考えることができます。

ドロップアウトは学習中ランダムにノードを除外して学習を行う手法です。学習はエポックごとに形の変化したネットワークを学習します。

ドロップアウトを行うと、複数のネットワークで推論を行う手法に近くなるので、アンサンブル学習(複数のモデルを学習し結果を統合する手法)をおこなっていると考えられます。

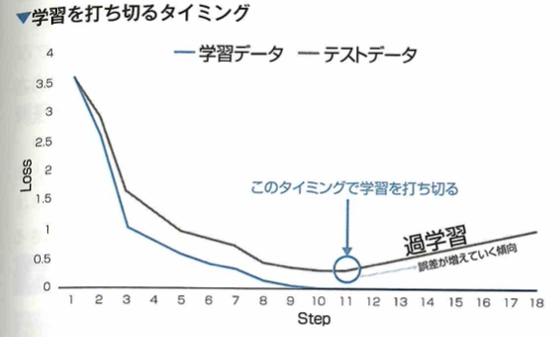

early stopping

early stoppingについて考えます。過学習を防ぐ手法の1つにearly stoppingがあります。 early stoppingとは学習の際、学習を早めに切り上げて終了することです。 このとき学習を打ち切るタイミングをテストデータに対する誤差関数の値が上昇傾向に転じたときとすると、そこが過学習の起きる前の最適な解であると考えることができます。 この手法をニューラルネットワークに適応する際の良い点としてどんな形状のネットワークの学習においても容易に適応できるということです。

early stoppingにはテストデータに対する誤差の値を利用しますが、この誤差を早く減少させるような効果はありません。基本的に適応するモデルにパラメータ数がいくつあっても適応しますが、そのモデルのパラメータを削減する効果はありません。学習の終盤で作用することで過学習を防ぐ効果がありますが、モデルのパラメータの初期値に対する依存度を下げる効果はありません。

ノーフリーランチ定理とは、あらゆる問題に対して性能の良い汎用最適化戦略は理論上不可能であるという定理です。

データの正規化

この例での正規化とは身長と体重を同じm単位に揃えることによりデータ全体を調整することです。このデータを[0,1]に収まるようにするためには、変換として、各特徴量の最大値で対応するデータの特徴量を割る作業を行うと良いです。

データの標準化

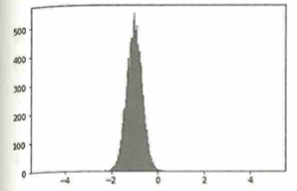

機械学習におけるデータの前処理について、各特徴量を平均0で分散1となるように変換する処理を標準化と言います。例えば任意の実数量をとるデータを10000個集めたとき、次の分布が得られたとします。

このデータを標準化した後の分布は下図になります。

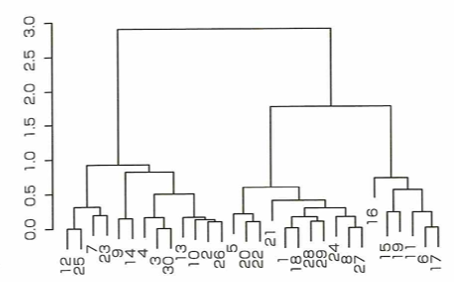

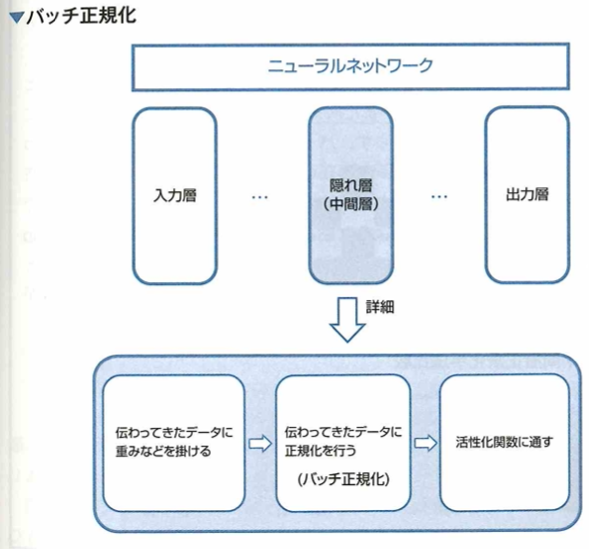

データの白色化

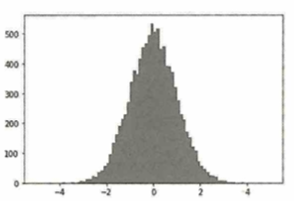

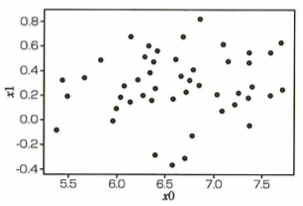

機械学習におけるデータの前処理について、各特徴量を無相関化した上で標準化する処理を白色化と言います。例えば元データが次の散布図があります。

このとき2つの特徴量に対して無相関化を行った後の散布図は下図になります。

問題文のデータは正の相関があります。そのため無相関化を行うと、相関が0のデータ(上図)が得られます。このデータに対して、標準化を行うことで白色化されたデータが得られます。

ニューラルネットワークの重みの初期値

ニューラルネットワークのパラメータの初期値について考えます。ディープラーニングにおいて、入力前にデータの標準化を行うことでデータの分布を揃えることができました。 しかし、深いニューラルネットワークの学習においては、活性化関数を何度も通るためにその分布がだんだんと崩れていってしまいます。このように分布が崩れて偏りが発生すると、勾配消失問題が起きたりネットワークの表現力が落ちてしまう可能性が高いです。

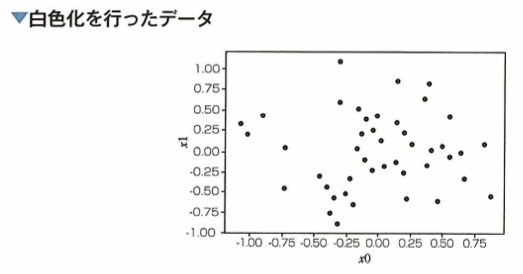

このような問題に対して、ネットワークの重みの初期値を工夫するというアプローチがあります。 これはネットワーク内のある層に対して、ネットワークの大きさと活性化関数の種類に対応する適切な乱数を設定するというものです。 たとえば、ReLU関数は入力が負の値の場合出力が0になることから、各層の出力に適度な広がりを持たせるには、sigmoid関数と比較して初期値がより広い分布を持ったものであると良いと考えられます。 このアプローチについて、ネットワーク内のある層に用いられている活性化関数とその適切な初期値について適切な組み合わせはシグモイド関数:Xavierの初期値、ReLU関数:Heの初期値です。 ここでXavierの初期値とHeの初期値とは、それぞれ次のようなものです。

ニューラルネットワークで用いられる重みの初期値について、各層に用いられている活性化関数によって、どのような初期値を設定するのが良いかを問う問題において、初期値を特定の分布に従った乱数で設定するのは、ニューラルネットワークの各層において、活性化関数を通した後の値に適度なばらつきを持たせたい、ということが目的になります。例えば、このような分布に偏りが生じている場合、ある層での出力が1または0の2種類に偏ってしまうと勾配消失問題が発生し、0.5などの1つの数値に偏ってしまうとネットワークの表現力に制限がかかってしまうと考えられます。

この問題に対し、ノードの初期値を適切な分布から生成される乱数で設定するというアプローチが考えられており、各層で使用している活性化関数がシグモイド関数(sigmoid関数)やtanh関数の場合は、ノードの初期値としてXavierの初期値を用いると良いと提案されています。これは各層の出力を同じくばらつかせることを目的として求められた値であり、上の表で与えられる標準偏差を持つガウス分布より生成される乱数です。ただし、Xavierの論文では、次層のノード数も考慮したより複雑な設定値が提案されており、ここではそれを単純化したものを用いています。

一方、ReLU関数を活性化関数として用いた場合、Heの初期値を用いるのが良いと提案されています。Heの初期値は、Xavierの初期値と比較して、より大きな広がりを持った分布によって生成される乱数です。ReLU関数は入力が負の値の場合出力が0になります。そこで、各層の出力に広がりを持たせるには、初期値により広がりを持たせなければいけないと考えられ、このような設定値となっています。

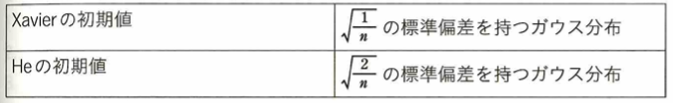

バッチ正規化

ディープラーニングにおいて、活性化関数を通ることでデータの分布が崩れていく問題に対するアプローチには、ネットワークの重みの初期値を工夫するというものの他に、直接的なアプローチとしてバッチ正規化というものがあります。これはネットワークにおいて、各層で伝わってきたデータに対し、正規化を行うというものです。これは無理やりデータを変形しているということであり、どのように調整するかはネットワークが学習します。バッチ正規化の処理を行うことによって、データの分布が強制的に調整され、勾配消失問題などが改善することにより学習がうまくいきやすくなると考えられます。さらにバッチ正規化のメリットには、過学習しにくくなるという効果があることも知られています。

バッチ正規化は、ニューラルネットワークの各層で前の層から伝わってきたデータに対して、もう一度正規化を行うものです。

学習において、重みの初期値に対する依存度を下げる効果が期待できます。他にも学習率を大きな値に設定しも、学習がうまく行きやすくなったりするなど、さまざまなメリットがあり、実際にバッチ正規化は多くのモデルで用いられています。

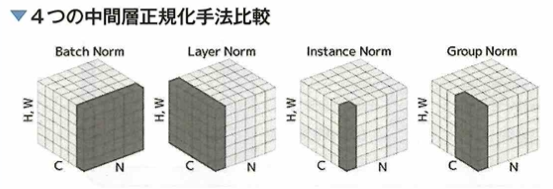

バッチ正規化には、その他の派生としてLayer Normalization、Instance Normalization、Group Normalizationがあります(図参照)。Cが特徴マップのチャネル、Nがミニバッチ数、H、Wが特徴マップのサイズです。グレーの部分が正規化を行う領域を示しており、バッチ正規化がバッチ方向に正規化しているのに対し、Layer Norm.は1サンプルに対しての全特徴マップでの正規化、Instance Norm.は1特徴マップに対しての正規化、Group Norm.はグループ分けした数チャネルに対しての正規化です。

以下の本節の最後の内容は発展事項になります。G検定の合否には関わらない難易度と推測されます。

バッチ正規化は、バッチ数が少ない場合での学習では粗い統計量(平均と分散)を使うためノイズに弱く、また時系列を扱うRNNにおいては各時間に対して統計量が異なるにも関わらず、バッチで扱うのは好ましくないとされています。Layer Norm.は1サンプルにのみ集中することでRNNのような時系列を考慮するモデルに使われます。Instance Norm.は特徴マップレベルへ細分化が必要なStyle Transferのような生成系のモデルで使われます。Group Norm.はグループに分けるバランス調整をする必要がありますが、LayerとInstanceを合わせて使うことで、バッチ正規化よりも精度向上を狙うことができます。

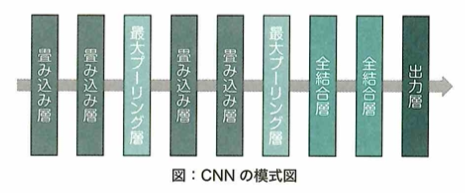

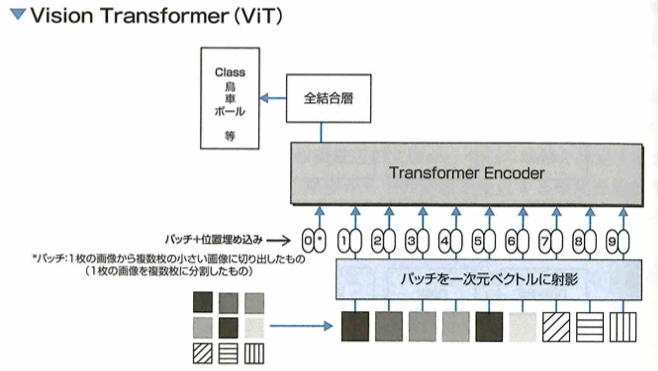

CNN:畳み込みニューラルネットワーク

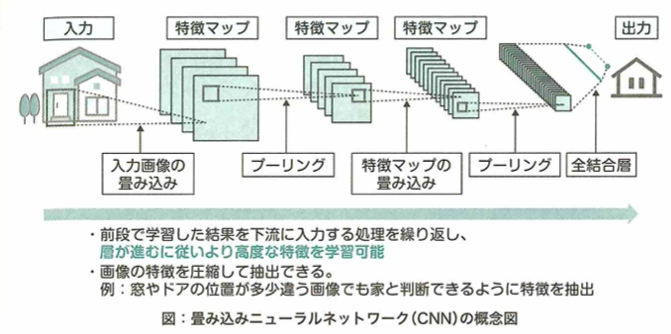

畳み込みニューラルネットワーク(CNN)

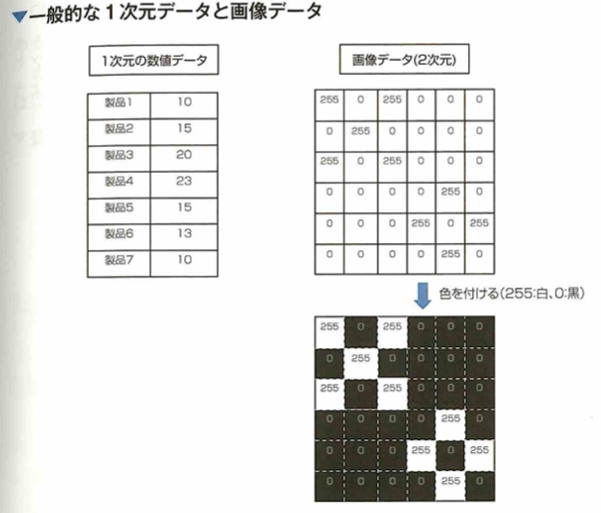

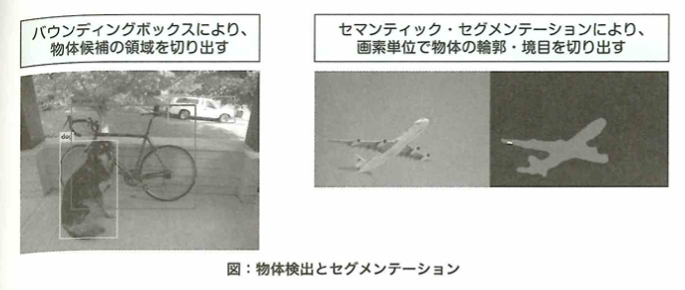

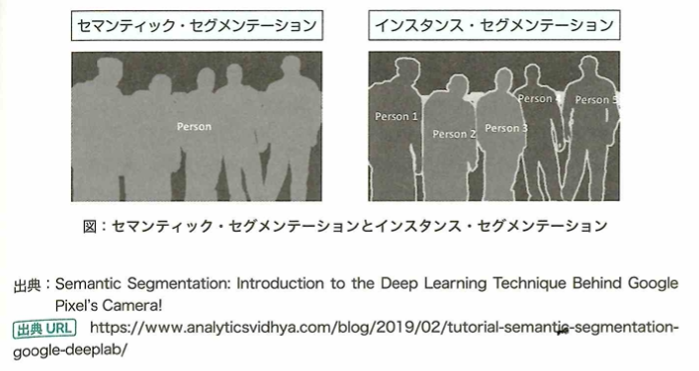

畳み込みニューラルネットワークについて考えます。画像データと数値データの大きな違いの1つに、次元の違いがあります。画像データは縦横の2次元のデータであると考えられ、さらに色情報(RGBなど)が追加されると数値情報としては3次元のデータとなります。通常のネットワーク(多層パーセプトロン)では、この画像データを入力する際に縦横に並んでいる画像を分解して、1次元に並び変えるように変形することでネットワークに入力できる形にする必要があります。したがって、この変形の段階で画像データから画像に映っている物体の位置情報が失われてしまいます。そこで、これらの情報を維持できるように考えられたのが、畳み込みニューラルネットワーク(CNN:Convolutional Neural Network)です。CNNでは、画像を崩すことなく、2次元のまま入力に用いることができます。したがって、画像に映っている物体の位置情報の情報が維持されるため、通常のニューラルネットワークに比べて精度の向上が期待できます。

画像データには他の種類のデータと比べて特徴的な部分があります。画像データからその画像に映っているものの特徴量を学習するには、一つ一つのマスを個別に扱うのではなく、複数のマスの領域から得られる情報を学習することが大事です。位置情報が失われてしまう問題を解決するには、CNNでは畳み込み演算処理を用います。これを用いると画像を2次元データのままネットワークに入力して学習・推論を行うことができます。

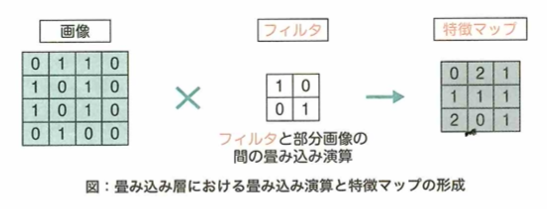

畳み込み演算のイメージ

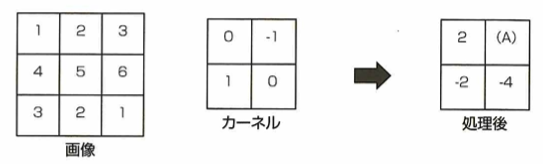

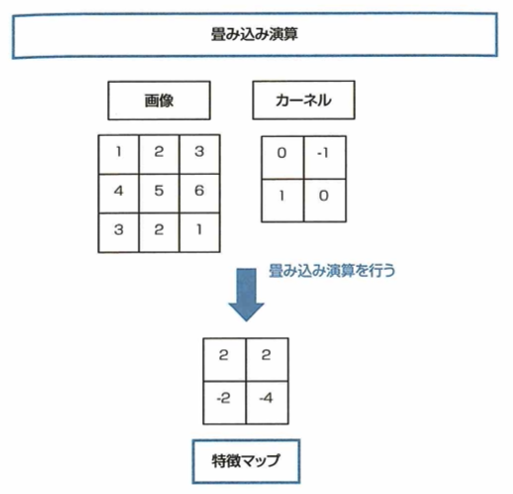

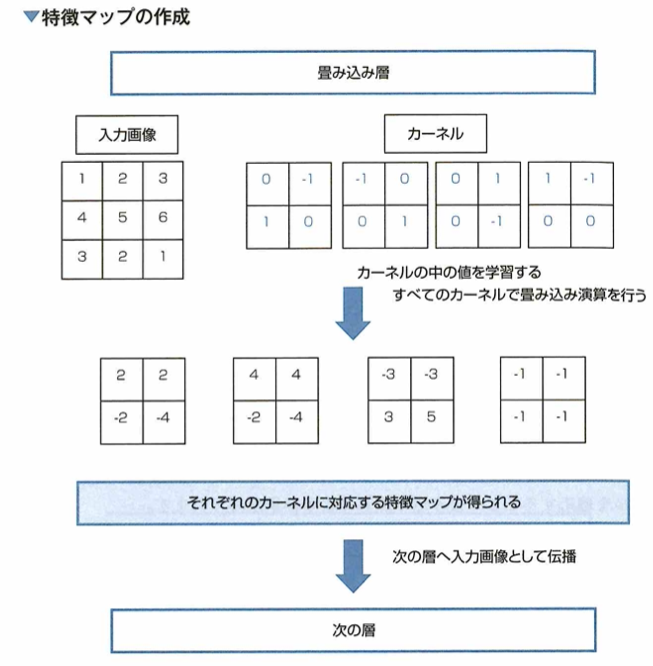

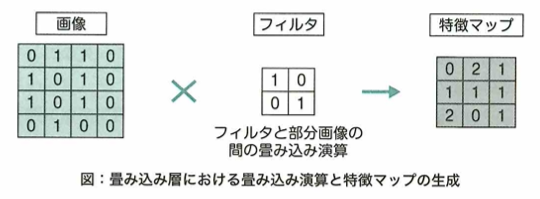

畳み込みニューラルネットワークでは、畳み込みと呼ばれる処理を利用して画像内の一定の領域から情報を得て学習を行うことができます。 畳み込みではカーネルやフィルタと呼ばれるものを用いて計算を行います。具体的にはカーネルを画像の左上から順番に画像上をスライドさせながら移動していき、各領域における画像の値とカーネルの値との積の総和を取っていくという処理になります。 次の画像とフィルタにおいて、畳み込み処理を行っていく場合、(A)の値はカーネルと画像が重なる4ピクセルの領域から計算される値2であることがわかります。 このように畳み込みでは一定の領域を考慮して計算を行うことができます。 畳み込みニューラルネットワークではこの図におけるカーネル内の値をネットワークの重みとすることで、よりうまく画像の特徴が抽出できるように学習が進んでいきます。

この問題については、求める箇所が、元画像の右上の4つのマスに、カーネルを重ねることにより、(2,3,5,6)と(0,-1,1,0)の内積を考えて2となります。

CNNがどのような値をニューラルネットワークの重みとして学習するか

CNNでは畳み込み演算を用いて画像を2次元のままニューラルネットワークに通して学習を行えます。畳み込み演算は、2次元の入力から新たな2次元の出力を得るものと考えられ、このように得られた新たな2次元の出力を特徴マップと言います。

畳み込み演算において、同じ画像が出力された場合でも、カーネルの中の数値が異なると、特徴マップは異なるものが得られます。そのためCNNでは、畳み込み演算によって得られる特徴マップの中に、入力画像に映っている物体の特徴がうまく抽出されるように、カーネルの中の数値を学習によって最適化します。

カーネルサイズやストライド、パティングは学習前に人の手で決定されるパラメータ(ハイパーパラメータ)となります。実際のCNNでは、畳み込み層でこの畳み込み演算が行われますが、1層の中に複数のカーネルが含まれ、カーネルの枚数と同じ枚数の特徴マップが生成されて次の層に伝播します。

ストライドとは畳み込み処理においてカーネルを移動させる幅のことです。パディングとは畳み込み処理前に画像に余白となるような部分を追加し、畳み込み処理後の特徴マップのサイズを調整するものです。

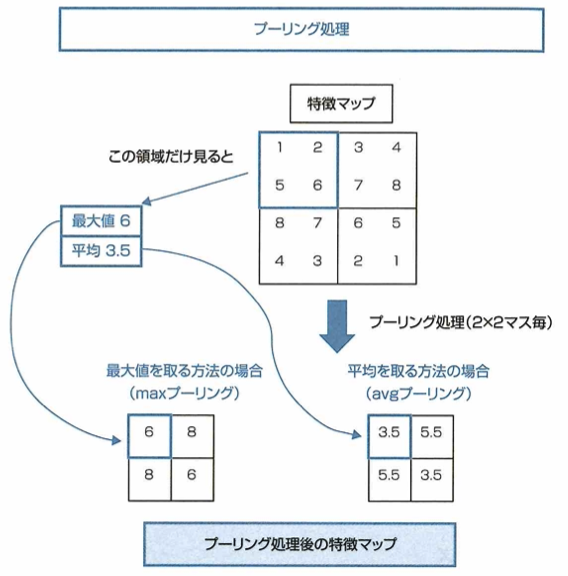

プーリング処理

CNNでは畳み込み演算と組み合わせてプーリング処理も行われます。プーリングは画像や特徴マップなどの入力を小さく圧縮する処理で、圧縮する方法には特定サイズの領域ごとに最大値を抜き出す方法や、平均値をとる方法などがあります。

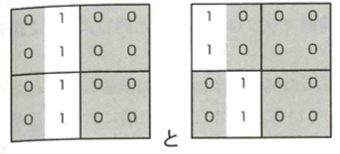

プーリング処理を行うと次の2つの特徴マップは同じマップに変換されます。

ここでは2×2の領域ごとにmaxプーリングを行うとします。プーリング処理によりニューラルネットワークが画像に映っている物体に僅かに物体の位置が変化するといった違いが生じても、同じ特徴量を見つけ出すことができるようになると期待できます。このような物体の位置が変化するといった違いに対する不変性は、CNNにおいて畳み込み層でも獲得することができますが、プーリング処理を行うプーリング層には学習によって最適化されるパラメータが存在しないという特徴があります。

プーリング処理は、特徴マップをより小さな特徴マップへと圧縮します。その中でわずかな位置の違いを含む特徴マップは、先ほどの例のようにプーリング処理によって位置の違いが吸収されてしまうことになります。このため、モデルが画像に映っている物体のわずかな位置の違いを過学習してしまう問題を防ぐことになり、これらの違いを含むデータセットに対して精度が上がることが期待できます。また、プーリング処理は、あらかじめハイパーパラメータとしてどのようなサイズでプーリングを行うかを手動で決定しますが、その後のプーリング処理は「最大値を取る」「平均値を取る」などの決まった計算で実現できます。このためプーリング層は学習によって最適化されるパラメータ(重み)を持っていません。

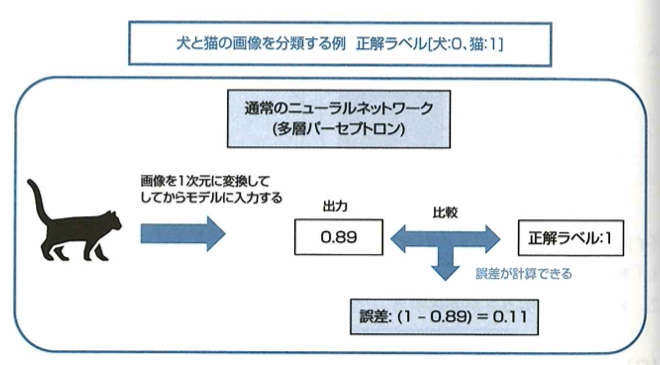

全結合層

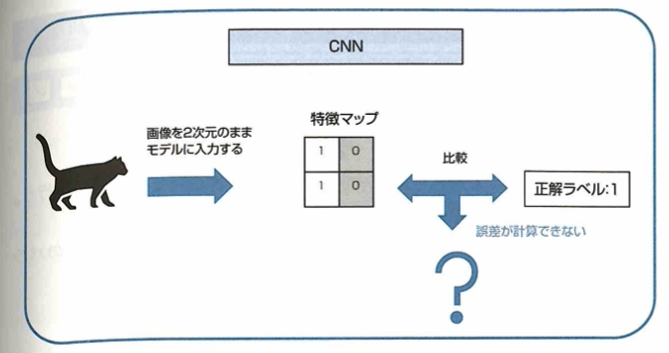

CNNに用いられる全結合層について考えます。CNNでは、入力画像が複数の特徴マップとなり、畳み込み層やプーリング層を伝播していく構造をしています。この構造を局所結合構造といいます。 ここで入力が画像であった場合、特徴マップは入力画像と同じような2次元の形をしていますが、次の犬と猫を分類するモデルの例のように、入力画像に対応付けられている正解ラベルは、1次元の形をしています。 そのため出力層において正解ラベルと特徴マップを比較することができず、パラメータを最適化するために必要な誤差が計算できません。 このような問題を解決するために、基本的なCNNでは特徴マップを1次元の数値に変換したのち、全結合層に接続するといった構造を持っています。 したがって、CNN全結合層の説明として正しいものは多層パーセプトロンに用いられている層と同じ構造をしているです。

全結合層は、CNNではない通常のニューラルネットワーク(多層パーセプトロンなど)に用いられている層と同じ構造をしています。データの全領域を使う全結合層において、畳み込みがデータの局所領域を用いて特徴抽出を行う構造であるため、CNNの畳み込みのような構造を局所結合構造と言います。

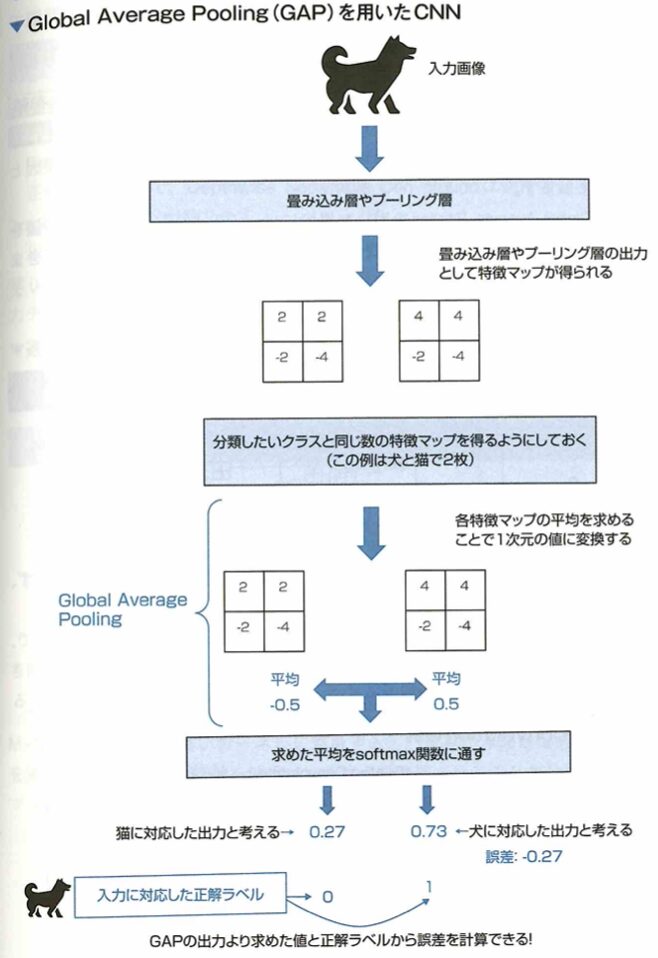

Global Average Pooling

畳み込みニューラルネットワーク(CNN)において、Global Average Poolingという手法が使われることがあります。Global Average Poolingとは、分類したいクラスと特徴マップを1対1対応させ、各特徴マップに含まれる値の平均を取ることで誤差を計算できるようにする手法です。この手法を使うことで、全結合層のみを使う場合と比べてモデルの持つパラメーター(重み)が少なくなるということに繋がるため、過学習が起きにくくなる等のメリットが得られます。

このGAPという手法は、特徴マップと分類したいクラスを1対1対応させる手法です。ここで補足として、Global Average Poolingを行う前に、特徴マップの数と分類したいクラス数を特に合わせたりせずに、GAPを行った後に全結合層を付けることで、分類したいクラス数と出力の数を合わせる方法もあります。特徴マップを1次元に並べるように展開し、全結合層に接続した場合、全結合層では、特徴マップが持っていた値に比例する数のパラメータを持つことになります。多くの場合には非常に多いパラメータ数となり、過学習などの原因となってしまいます。一方、Global Average Poolingを用いた場合には、このような特徴マップの値をすべて使用して全結合をすることがなくなるので、パラメータ数を削減できます。このようにパラメータ数が削減されることで過学習の軽減などに繋がります。

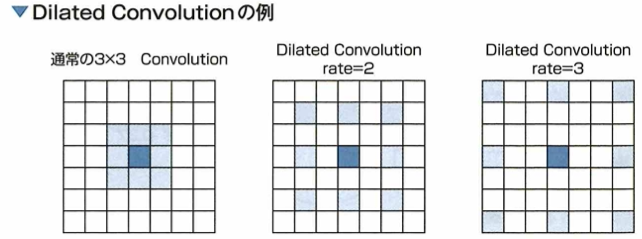

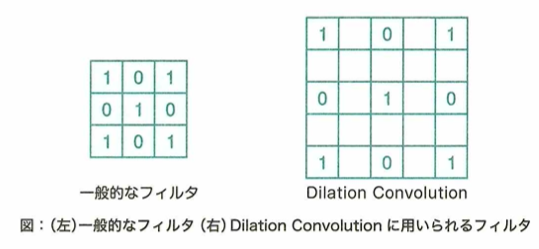

Dilated Convolution

Dilated Convolutionについて、通常のConvolutionのカーネルに隙間のような間隔をあけて畳み込みを行うことにより、広範囲の情報を取得できます。Atrous Convolutionと呼ばれることもあります。カーネルの隙間の間隔はハイパーパラメーターで設定されます。

Direted Convolutionはカーネルのパラメータ数は変わらず、カーネルの間隔を広げることで広範囲の情報を畳み込みます。以下の図では、色が塗られている部分が畳み込みの見る部分で、中心が青色です。この畳み込みの見る範囲はrateの数だけ間隔が開きます。このrateという感覚はハイパーパラメータにより決められます。この方法はAtrus Convolutionとも呼ばれます。

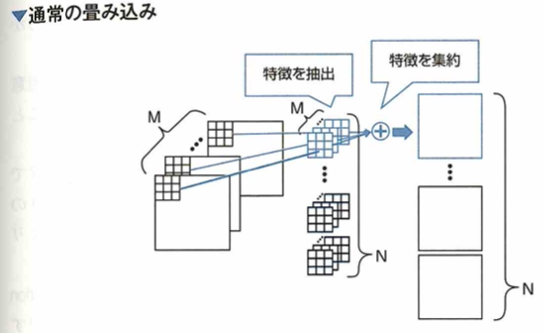

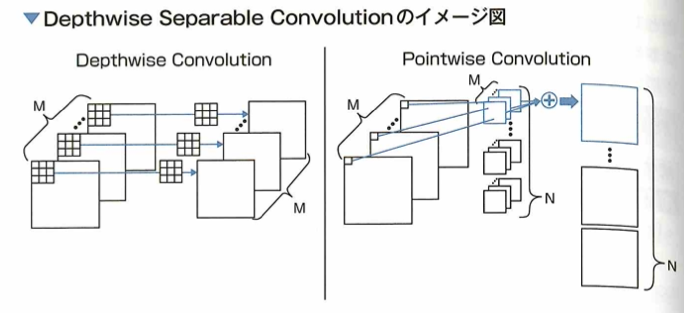

Depthwise Separable Convolution

Depthwise Separable Convolutionについて、通常の畳み込み層を空間方向とチャネル方向の2つの畳み込みに分解することでパラメータ数を減らしました。

Depthwise Separable Convolutionは通常の畳み込み層を2つの畳み込み層に分解します。以下の図での通常の畳み込みはMチャネルの入力に対して、M枚のカーネルを出力チャネルN個分用意します。

今回の例ではカーネルサイズが3×3なので、この畳み込みは3×3のカーネルがM×N個存在します。青いカーネルに着目して、畳み込み層はM個のカーネルを通して各チャネルの特徴を抽出し、それらを集約させることで1つの出力特徴マップが得られます。

それに対して Depthwise Separable Convolution は、通常の畳み込み層を Depthwise Convolution と Pointwise Convolution の 2 つに分解したものです。Depthwise Convolution は空間方向の畳み込みと解釈でき、M チャネルの入力から各チャネルの特徴を取り出します。通常の畳み込み層と異なる点は、入力のチャネル数と同じ数のカーネルを用意して、抽出した特徴を集約しない点です。これにより空間方向の特徴を得ることができます。もう一方の Pointwise Convolution は、チャネル方向の畳み込みと解釈でき、1×1 Convolution を使います。例のように M チャネルの入力に対して 1×1 の Convolution をして得た特徴マップを集約して 1 つの出力とします。これによりチャネル方向の特徴量の集約ができます。

Depthwise Separable Convolution は、Depthwise Convolution の後に Pointwise Convolution を行う構造になっています。通常の畳み込み層のパラメータ数は 3×3×N×M ですが、Depthwise Separable Convolution は 3×3×M + 1×1×N×M = (9 + N) × M となり、パラメータ数を削減することができます。これを使ったモデルとして MobileNet というものが提案されました。

Dilated (Atorus) Convolution は通常の畳み込み層のカーネルの間隔を広げて活用することで、より広い範囲を見るように工夫することです。VGG という CNN モデルでは、通常の畳み込み層のカーネルサイズを3×3または1×1の小さなもののみにして層数を増やすことで性能向上をします。バディングとは、畳み込み層の後の特徴マップが小さくなるのを防ぐため、入力のマップの周りを0や1などの値で埋めることです。

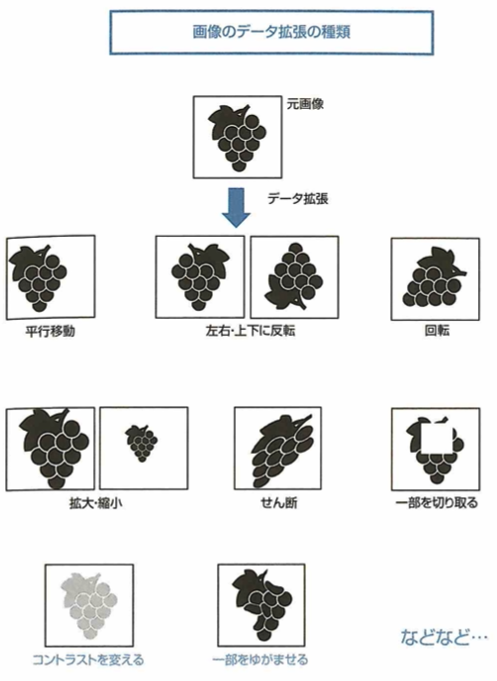

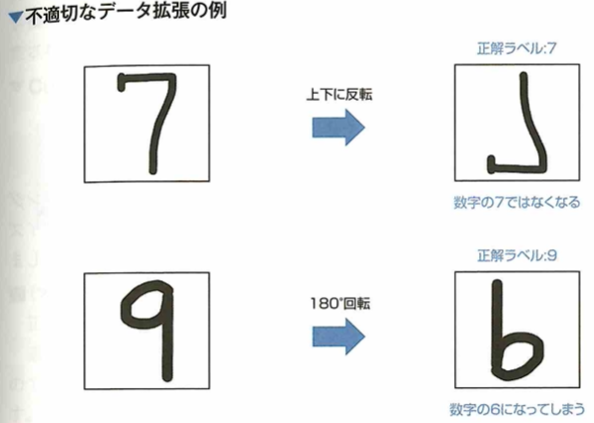

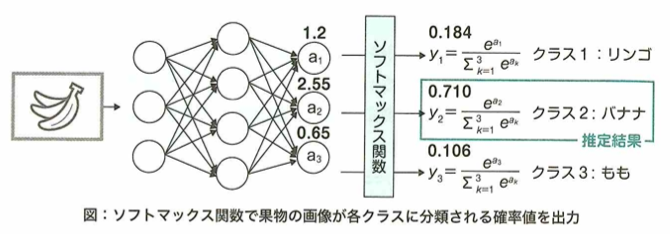

データ拡張

画像データを用いてニューラルネットワークを学習する際に、画像に人工的な加工を行うことでデータの種類を増やせます。具体的な処理は次の通りです。

ここで手書き数字0〜9が映っているデータセットに対してデータ拡張を考えます。ただし画像1枚に対して1文字のみ映っています。このようなデータセットに対して、正解ラベルが6や9のデータに画像を180°回転のような変換を行うことは不適切です。

このような問題の時は、意味のない画像や別の数字として見た方が正確な画像に変換されてしまう場合があります。下記の図では上下斑点の例ですが、「3」は問題ありません。しかし「3」の左右反転は不適切です。このようなデータ拡張を行う際は、データ特徴を意識して、どのような変換を行うか選択する必要があります。

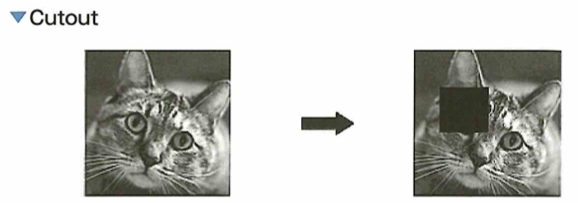

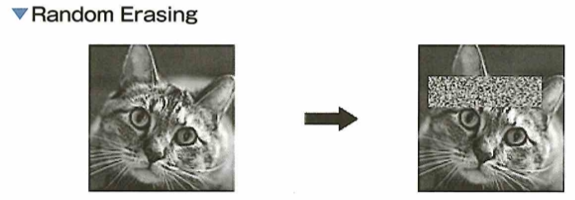

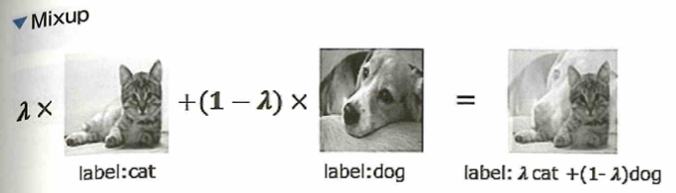

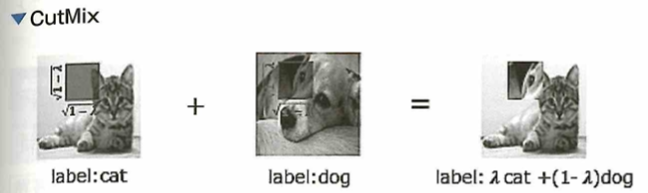

データ拡張の手法

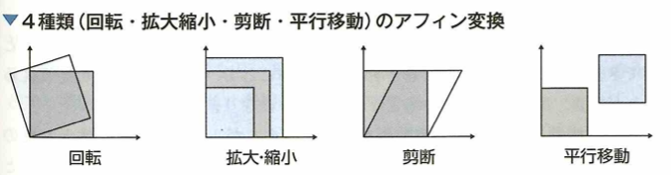

画像に関してのデータ拡張(Data Augmentation)はさまざまな手法が提案されています。たとえば、画像の左右または上下を反転させるフリップや、画像を拡大または縮小するなどがあります。その他にも、手法の1つに画像中のランダムな場所を値の0の正方形領域で削除するcutoutがあります。この手法により一部を失った画像で学習できるため、よりロバスト(頑健)なモデル作成が可能となる。また、ランダムな場所を固定値、もしくはランダムノイズの長方形領域で置き換えるRandom Erasingがあります。こちらもロバストな学習を可能にします。特に最近では2枚の画像をそれぞれランダムな比率で混ぜ合わせるMixupという手法があります。この手法は教師ラベルも同じ比率で混ぜて複数クラスの画像認識との学習を行います。さらに、この手法の派生として、画像のランダムな位置を別の画像で置き換えるCutMixという手法も提案されました。こちらも教師ラベルを置き換えた画像の比率で混ぜ合わせます。どちらの手法も深層学習においてパフォーマンスの向上に成功しました。これらの画像に対するランダムなデータ拡張は学習に対して過学習の抑制が期待できます。

速い収束性については、データ拡張により必ずしも期待できません。メモリの削減については、関係がありません。モデルのスパース化とはモデルのパラメータが0に近い値が多くなることを指しますが、データ拡張でスパース化が起きるとは限りません。

Neural Architecture Search(NAS)

ディープラーニングの発展に伴ってさまざまなモデルが提案されてきました。VGGやResNetはその中でもより深い多層なモデルとなっており、多層にすることで高精度を得られることが実験により示されてきました。しかし、多層にすることでパラメータが増え、モデルの自由度が上がることで汎化性能が下がってしまう問題も同時に存在しました。これまでは正則化項を追加したりすることで汎化性能を上げたり、ハイパーパラメータチューニングをして精度を向上させてきました。それに対してニューラルネットワークの層の数や層の幅といった、アーキテクチャ自体を最適化することを目的とした研究が、昨今盛んに行われています。これをNeural Architecture Search (NAS)といいます。

NASは最適なモデルのアーキテクチャを自動で探索するタスクです。探索方法は様々で、CNNに限定した探索手法ではNASnetやMnasNetなどがあります。

グリッドサーチはハイパーパラメータの探索手法です。ファインチューニングは事前学習したモデルを別のタスクで再学習することです。スクラッチ開発はプログラムを1から書いて開発を行うことです。

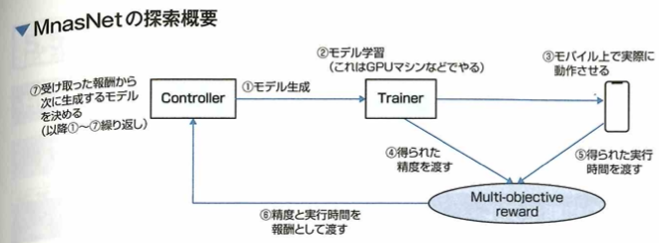

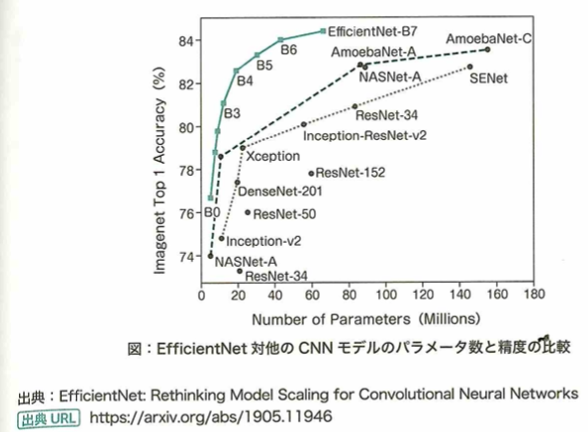

NASによるモデル

NASは、モデルの構造自体を自動で探索する研究です。2017年にNASNetと呼ばれるCNNのみに焦点を当てたNASが提案されました。これは畳み込み層のみに注力して最適な構造を探索しました。また、最近ではMnasNetと呼ばれる強化学習の概念を使って、モバイル用の高効率で高精度なモデルも提案されました。これは強化学習の際に実際にモバイル端末を使って評価することで、モバイル用の最適なモデルを探索したものです。その他にも、モデルの深さ、広さ、解像度(入力画像または特徴マップのサイズ)のスケールアップのバランスを重視して探索されたモデルが提案されました。これはNASによりベースとなるモデルを決定し、ベースモデルのスケールアップによる性能の変化を研究することで、各スケールの最適な広げ方を求めました。このモデルをEfficientNetと言います。従来のモデルと比べてとても少ないパラメータ数で、かつシンプルな構造で高精度を出しました。

NASNetは、CNNのみに焦点を置いて探索されたモデルです。従来では探索する範囲が広すぎて最適モデルを見つけることが困難でしたが、畳み込み層に注力して最適な構造を探索することにより、少ないパラメータ数で高精度なモデルを見つけることに成功しました。

MnasNetは、強化学習の考え方を取り入れ、モデルの精度とモバイル端末上での実際の実行速度を見ながら、より良いモデルを探索したモデルです。次の図に探索のフロー例を示します。

最初にControllerがモデルを生成し(①)、モデルの学習をします(②)。その学習したモデルをモバイル端末上で実行したときの時間とモデルの精度を、Multi-objective rewardに渡します(③④)。それぞれの結果を見て報酬をControllerに渡し(⑤)、次に生成するモデルを決めます。この手順を繰り返すことで高速で高精度なモデルを生成するControllerができます。

EfficientNetは、深さ、広さ、解像度のスケールアップのバランスを重視して探索したモデルです。構造自体もシンプルでかつ従来の高精度モデルよりもパラメータを少なくして、性能向上することに成功しました。現在ではEfficientNetをベースとした新たなモデルでEfficientNet v2なども提案されています。

転移学習とファインチューニング

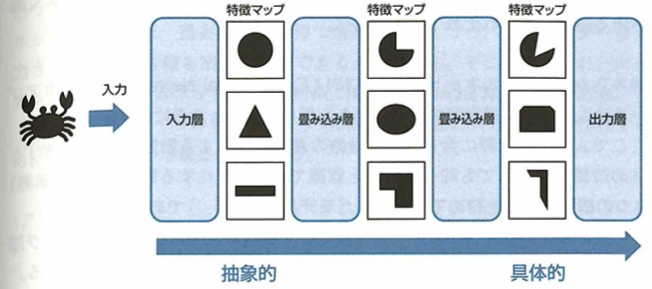

転移学習について考えます。ニューラルネットワークを学習する目的は、予測を行いたい問題に対して最適なパラメータの値を計算することです。したがって、目的の問題に対して理想的なパラメータが分かっていれば、ネットワークの学習を行う必要がなく、モデル作成の時間短縮に繋がります。ここで画像認識などの分野では、さまざまな問題に対して共通する特徴が存在する場合が多いです。そのため学習済みモデルを利用し、これらのモデルに新しく何層か付け足したものを調整するということが行われています。このように学習済みのネットワークを利用して、新しい問題に対するネットワークの作成に利用することを転移学習、またはファインチューニングといいます。特に付け足した(または置き換えた)層のみを学習するときは転移学習といい、利用した学習済みモデルに含まれるパラメータも同時に調整するときはファインチューニングといいます。基本的にニューラルネットワークでは、次のように入力層付近においては画像に含まれる抽象的な特徴量を学習し、出力層付近においては具体的な特徴量を学習することで知られています。

このため、画像データを用いるモデルで転移学習やファインチューニングを行う際は、学習済みモデルにおいて出力層の後に新たな層を追加したり、この層を置き換えて調整を行うと効果的であると考えられます。一方で利用元のモデルと転移先のモデルでデータの種類(ドメイン)の関連性が低い場合では、転移学習やファインチューニングを行うのは不適切であり、精度が逆に悪くなってしまうというような問題が発生する可能性があります。

学習済みネットワークにおける入力層に近い層のパラメータはさまざまな画像の分類問題に応用が効きます。そのためこの部分はそのまま利用し、出力層の後に新たな層を追加したり、出力層を置き換えて調整することで目的の問題に対応させると効果的です。転移学習のメリットは、学習用のデータが少ない場合でも、十分なデータがある問題で学習したモデルで学習したモデルを利用することで、より精度を向上させることが期待できますが、転移学習を行う際には、学習に用いられるデータの特徴を理解しておく必要があります。なぜならデータに共通性が少ない場合では、逆に精度が落ちてしまうからです。

CNNの基本となった初期モデル

畳み込みニューラルネットワーク(CNN: Convolutional Neural Network)のアプローチは人間が持つ視覚野の細胞の働きを模したものであります。ここで人間の視覚野に含まれる、画像の濃淡を検出する細胞(単純型細胞)と物体の位置が変動しても同一の物体と認識できるようにする細胞(複雑型細胞)の2つの細胞の働きを初めて組み込んだモデルはネオコグニトロンです。その後、1998年にヤン・ルカンによって考えられた畳み込み層とプーリング層(サブサンプリング層)を交互に組み合わせたCNNのモデルはLeNetです。

単純型細胞(S細胞)と複雑型細胞(C細胞)の働きを最初に組み込んだモデルは、福島邦彦により1979年に提唱されたネオコグ二トロンです。これはS細胞層とC細胞層を交互に組み合わせた構造で、勾配計算を用いないadd-if silentという方法により隠れ層(中間層)の学習が行われます。LeNetとは1998年にヤン・ルカンによって考えられた畳み込み層とプーリング層を交互に組み合わせたCNNモデルです。この2つのモデルを比べると、2つのモデルは同じ構造をしており、S細胞と畳み込み層、C細胞とプーリング層がそれぞれ対応しています。

RNN:リカレントニューラルネットワーク

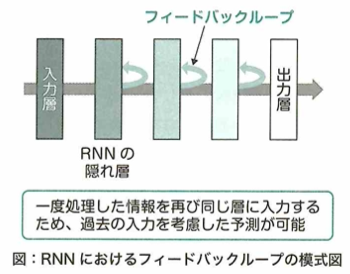

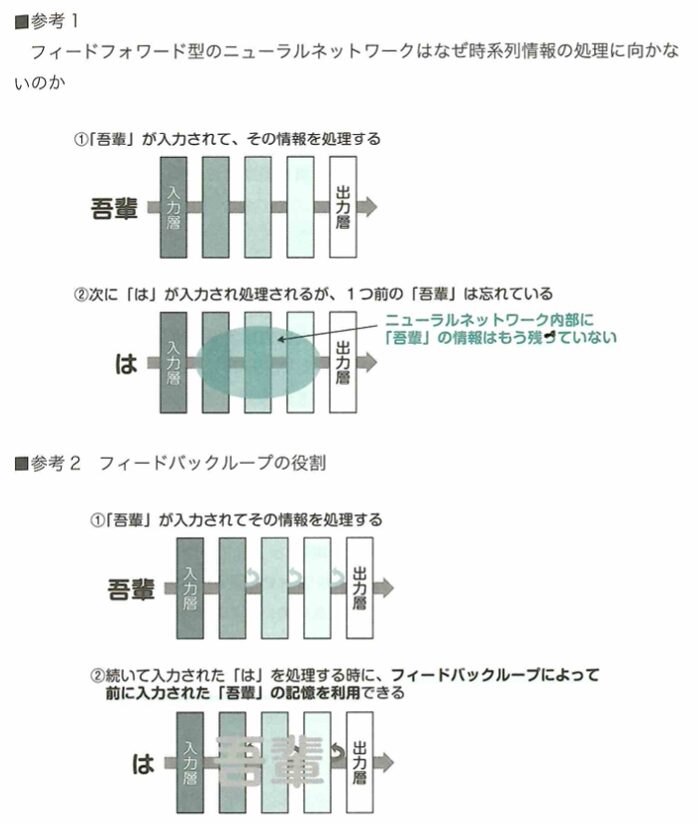

RNNの構造

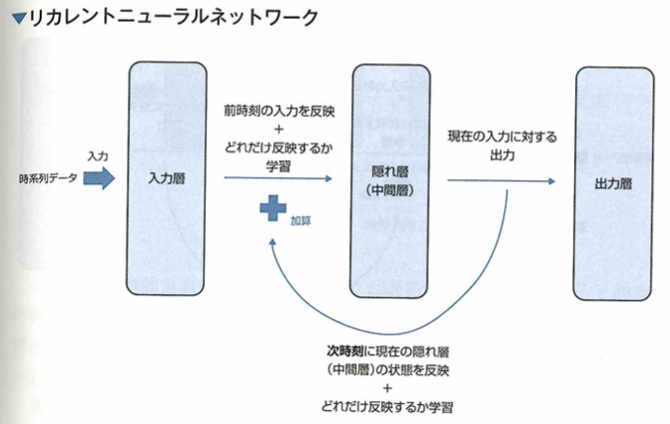

リカレントニューラルネットワークについて考えます。画像データはピクセル間の関係性が重要であり、このようなデータはCNNが有効でした。文章のようなデータから特徴を取り出すためには、ニューラルネットワークを新たな構造にする必要があります。文章では、ある単語がその単語の前後に繋がる単語と深い関係性を持っており、さらにその並び順が非常に重要な意味を持っています。このようなデータを時系列データといいます。ここで時系列データからうまく特徴を取り出すためには、データを時系列に沿って順番にニューラルネットワークに入力できると良いです。このニューラルネットワークでは、過去の入力が持つ情報を保持しつつ、これらのデータが入力された順番の情報を出力に反映できる必要があります。そこで考えられたのがリカレントニューラルネットワーク(RNN:Recurrent Neural Network)です。リカレントニューラルネットワーク(RNN)は、過去の入力の情報を保持するために過去の入力による隠れ層(中間層)の状態を、現在の入力に対する出力を求めるために使うという構造をしています。

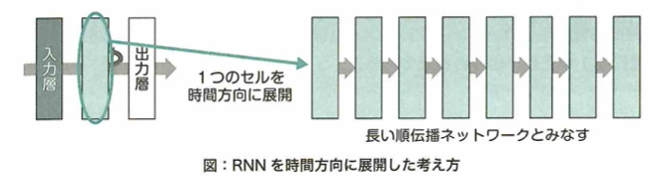

RNNでは現在の入力とそれまでの入力がそれぞれどれくらい現在の出力に影響するかを学習できます。過去も入力の情報が現在の入力に影響を与えることができる構造で、RNNは時系列データの処理に適しています。RNNは誤差を計算する際に、過去の入力に遡って計算していく必要があります。このように計算する方法を通時的誤差逆伝播(BPTT:BackPropagation Througu Time)と言います。

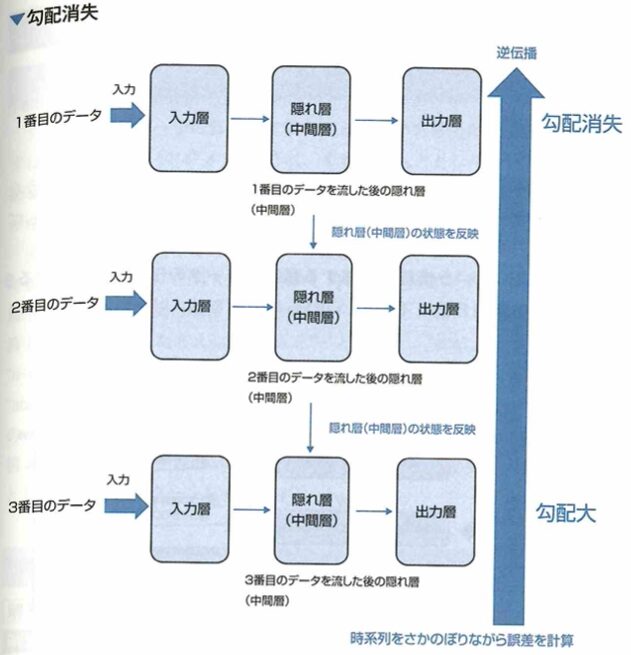

RNNで発生する勾配消失問題

リカレントニューラルネットワーク(RNN)における勾配消失問題について考えます。多層パーセプトロンやCNNにおいては、層が深くなると勾配消失によって入力層付近ほど学習ができなくなるといった課題がありました。ここで時系列データを用いてRNNの学習を行うときは、過去の時系列をさかのぼりながら誤差を計算する通時的誤差逆伝播(BPTT)を用いて勾配が計算されますが、このとき、計算される勾配に対して時系列の古いデータほど勾配消失しやすい特徴があります。

RNNではネットワークは時間方向に深いものとなります。

時系列の古いデータの部分で勾配が消失してしまいやすいです。同様に、時系列の古いデータ部分においては、勾配が大きなりすぎてしまう勾配爆発の問題も起きやすいです。

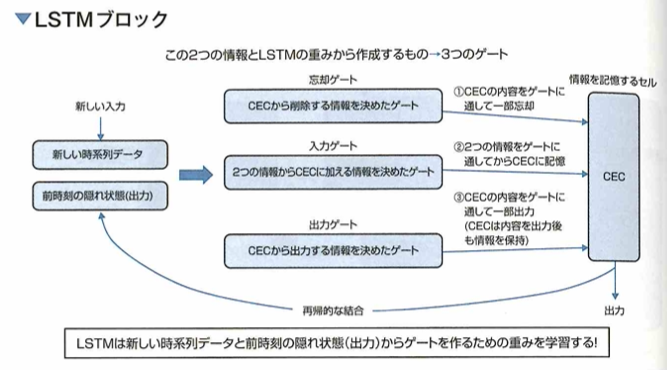

LSTM

RNNの一種であるLSTM(Long-Short-Term Memory)について考えます。RNNは再帰的な構造を持つことにより、過去の入力の状態が現在の出力に影響を与えることができます。もし過去の情報が現在の入力と組み合わせて重要な意味を持つ場合、過去の情報の重みが大きいと考えられます。一方、過去の情報が現在の入力に対してあまり意味を持たない場合は、過去の情報の重みは小さくなります。ここで問題となるのは、現在の入力に対し過去の情報はあまり関係がないが、将来的に重要な情報となる場合です。すなわち、現在の入力に対して過去の情報の重みは小さくてはならないが、将来のために大きな重みを残しておかなければならないという矛盾が生じます。このような問題が、新しいデータの特徴を取り込みときや、隠れ層(中間層)の状態を踏まえて結果を出力するときに発生することを、それぞれ入力重み衝突、出力重み衝突といいます。この問題を解決するために考えられたものが、LSTM(Long Short-Term Memory)です。LSTMは勾配消失の問題や入力重み衝突・出力重み衝突課題を解決するために考えられました。LSTMが持っている構造としてCEC(Constant Error Carousel)という情報を記憶する構造と、データの伝搬量を調整する3つのゲートを持つ構造となります。

入力重み衝突とは、現在の入力に対し、過去の情報の重みは小さくなくてはならないが、将来のために大きな重みを残しておかねばならないという矛盾が、新しいデータの特徴を取り込むときに発生するもので、出力重み衝突とは、現在の入力に対し、過去の情報の重みは小さくなくてはならないが、将来のためにお大きな重みを残しておけねばならない矛盾が、現在の状態を次時刻の隠れ層(中間層)へ出力するときに発生することです。

3つのゲートを持つ構造と情報を記憶するセルの構造のセットはLSTMブロックと言います。実際のLSTMでは隠れ層(中間層)にこのLSTMブロックが複数個並んでいます。このLSTMブロックの構造において、忘却ゲート、入力ゲート、出力ゲートがあります。これらのゲートと情報を記憶するセル(CEC)により、LSTMは重要な情報を必要なタイミングで利用したり、不必要になった情報削除のタイミングをコントロールできるようになります。CECにゲートを介して情報をやり取りする構造のおかげで、逆伝播の際に勾配消失の問題も起きにくくなります。

LSTMやRNNなどの学習における損失関数の1つとして、Connectionist Temporal Classification (CTC) lossというものがあります。例えば、スピーチの音声を文章化するタスクを考えたときに、学習音声データは単語毎に分割(セグメント)させ、それらを入力としたネットワークの出力とその単語ラベルの損失が計算されますが、これだと最初のデータの分割にコストがかかってしまいます。そこで、CTC lossはそのセグメントなしで学習することができる損失関数として提案されました。CTC lossはblankと呼ばれる空文字が出力されることと、連続して同じ単語が出た場合は1つに集約する(例えば、“aaabcc”は“abc”)ことを許します。これを例えば、blankを“_”とすると、“abc”という単語=“ab_ccc”、a_bb-c-、“aaabcc”などが同じ意味であることを示します。CTC lossはラベル“abc”に対して“ab-ccc”、a-bb-c-、“aaabcc”、など同じ意味となる単語のすべてのパターンを使って損失を計算できるため、セグメントせずとも入力の時系列と答えのタイミングを合わせることができます(この例では、出力単語の長さを7としてすべてのパターンを考えます)。

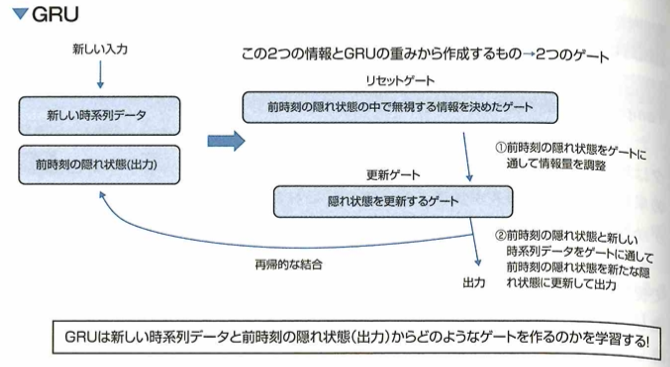

GRU

リカレントニューラルネットワーク(RNN)の一種であるGRU(Gated Recurrent Unit)について考えます。RNNには情報を記憶するためのセルと3つのゲートの構造を持つLSTMがあります。LSTMはRNNの勾配消失の問題と、入力重み衝突・出力重み衝突の問題を解決するのに貢献しましたが、一方でLSTMには計算量が多いという問題がありました。そこでLSTMを軽量化したモデルの1つがGRU(Gated Recurrent Unit)です。GRUはLSTMと同じようにゲートを用いた構造のままパラメータを削減し、計算時間が短縮されています。具体的な構造としてGRUはリセットゲートと更新ゲートという2つのゲートを用いた構造を持つブロックの組み合わせによって構成されています。

実際のGRUでは、このような2つのゲートを持つ構造のブロックを隠れ層(中間層)に複数個並べることで構成します。GRUはLSTMが持つ情報を記憶するセルのような構造を必要とせず、よりシンプルな構造をしています。

双方向RNN

RNN(BiRRN:Bidirectional RNN)は2つのRNNが組み合わさった構造で、一方はデータを時系列通りに学習し、もう一方は時系列を逆順に並び替えて学習を行います。このような時系列データの特徴を双方向から捉える構造によるメリットは過去と未来の両方の情報を踏まえた出力ができることです。

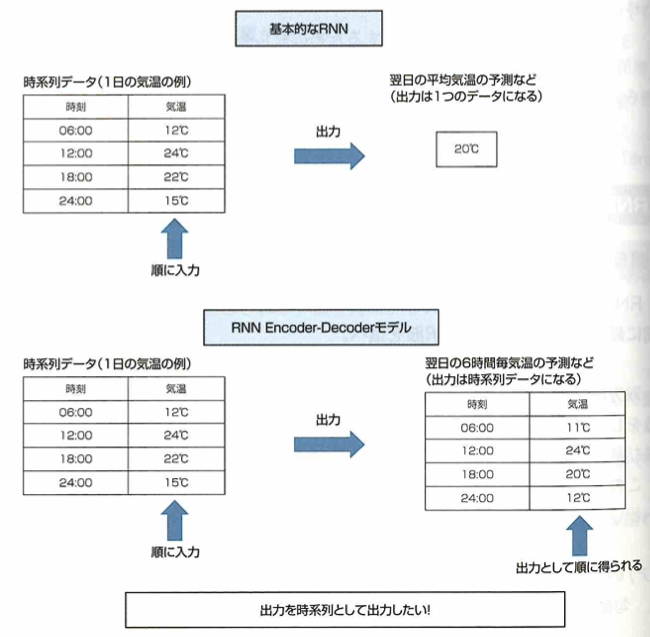

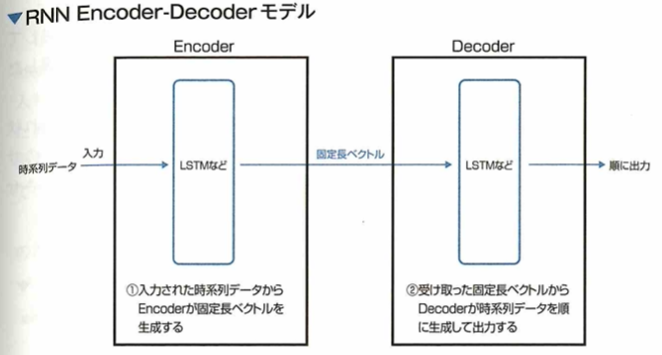

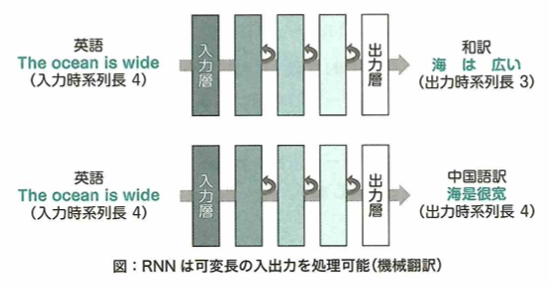

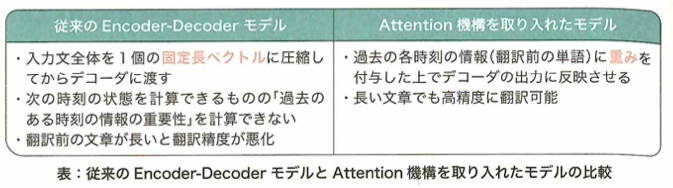

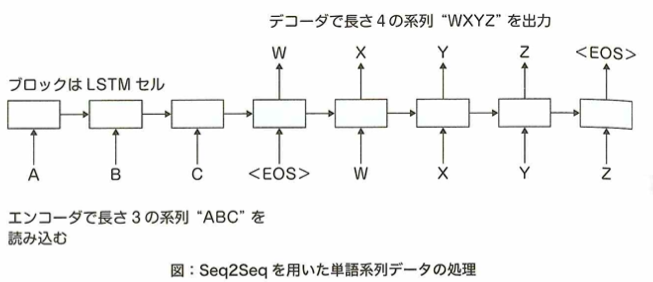

Encoder-Decoderモデルとsequence-to-sequenceの問題

RNNを応用したRNN Encoder-Decoderと呼ばれるモデルについて考えます。これまでのRNNは時系列データから1つの予測を出力するものです。一方で、入力の時系列に対して出力も時系列として予測したい問題もあります。このような問題をsequence-to-sequence(seq2seq)と言います。このsequence-to-sequence問題を解決するためにRNN Encoder-Decoderが考えれられました。これまでのRNNとの出力の違いは下図です。

このような時系列での出力を得るためにRUN Encoder-Decoderモデルでは、エンコーダ(Encoder)とデコーダ(Decoder)と呼ばれる2つのRNN(LSTMなど)から構成されます。ここでエンコーダは入力される時系列データから固定長のベクトルを生成します。その後に、デコーダでは固定長のベクトルから時系列データを作成します。

Encoderの出力は、最後の隠れ層(中間層)の状態です。これらの情報は固定長のベクトルなので、Encoderは任意の長さの時系列データを固定長のベクトルに圧縮していると考えられます。

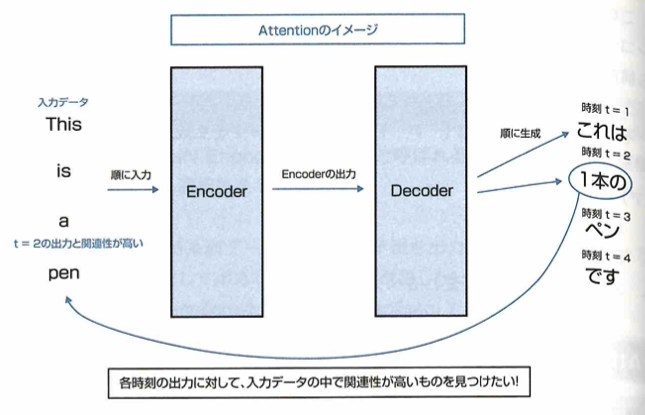

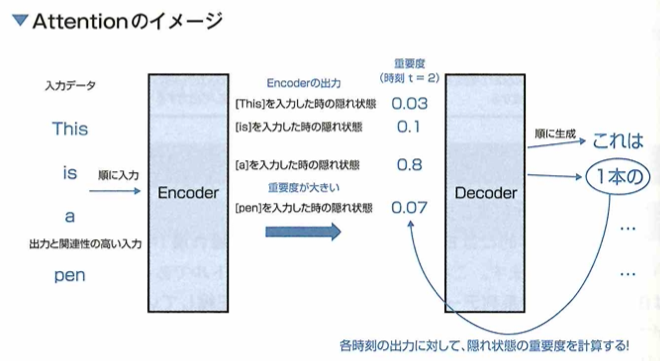

Attention

Attentionについて考えます。seq2seqの問題に対応したモデルとしては、RNNのEncoder-Decoderモデルがあります。しかし、このEncoder-Decoderモデルでは、Encoderによって時系列データを固定長のベクトルに圧縮しなければなりません。したがって、長い時系列データが入力されたときなどで固定長のベクトルの中に情報が入りきらないといった問題が発生してしまいます。このような問題を解決できる手法としてAttentionと呼ばれるものがあります。Attentionとは、入力データと出力データにおける重要度のようなもの(アライメント)を計算する手法であり、seq2seqのモデルに用いた場合は「入力の時系列データ」と「出力の時系列データ」の各要素間で対応するものを選択するようなイメージになります。すなわち次の図のように、Decoderである時刻のデータを生成する際に、Encoderに入力された時系列データの中から影響力の高いデータに注意を向けるということです。

ここでAttentionを持つEncoder-Decoderモデルではこのような動作を実現するために、encoderは隠れ状態を時刻ごとに出力してDecoderに渡しています。このことからAttentionの動作は時系列データにおいては「過去の入力のどの時点がどれくらいの影響を持っているか」を直接的に求めることでデータの対応関係を求めていると考えられます。

この問題におけるAttentionの手法は、soft Attentionのような、重要度を各時刻における隠れ層の状態(入力データの要素に対応)の重み付き平均を、デコーダでの推論に使用する手法を想定しています。 seq2seqに用いられるAttentionでは、各時刻のエンコーダの隠れ状態に対して出力に影響を与える重要度が計算されます。またデコーダでは重要度を考慮した隠れ状態を用いて入力データから新たな時系列データを生成します。 このような計算をするために、下図のようにEncoderはすべての時刻の隠れ状態を出力してDecoderに渡しています。したがってEncoderの出力は固定長のサイズに縛られることなく、入力となる時系列データのサイズに比例して変化させることができるようになっています。ここでEncoderの出力となる各時刻の隠れ状態には、その時刻に入力された時系列データの要素の特徴が多く含まれていると考えられます。そのため各時刻の隠れ状態は、その時刻にエンコーダに入力された要素とみなせます。ここでこれらの隠れ状態に対する重要度を求めることでAttentionは過去の入力のどの時点がどれくらいの影響を持っているかを直接的に求めていると考えられます。Attentionの手法には、self Attentionといった1つのデータ内での要素間の対応を計算するものなど、様々な手法が考えられています。

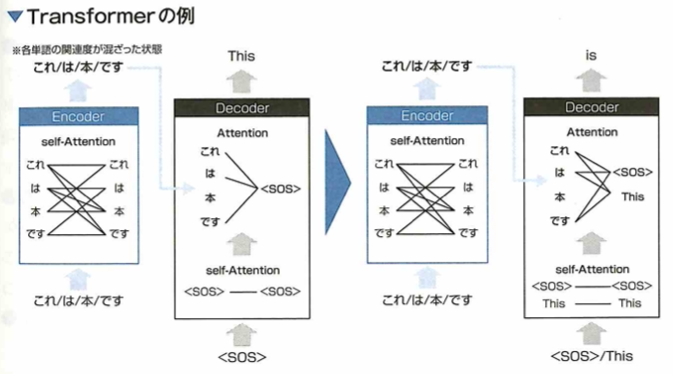

Transformer

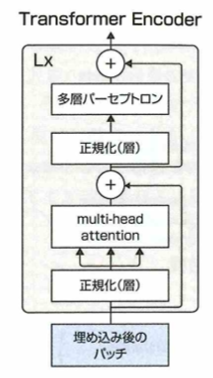

量み込みや再帰的構造を使わず、完全にAttentionをベースとしたモデルとしてTransformerがあります。Transformerは通常のAttentionとself-Attentionの二つを組み合わせてEncoder-Decoderとし、時系列データの未来予測や言語の翻訳などタスクの精度を上げました。このAttentionとは、入力間の関係性を見ることができます。たとえば、「私/は/この/本/が/好き/。」と「I/lik/this/book/.」の2つの文章の関連を測ります。ここで「/」は各単語の区切りを意味します。この場合、「好き」と「like」の関連度が最も高くなりそうな予想ができます。self-Attentionとは、入力されるデータ自身でAttentionを計算するためselfという単語がついています。例えば、先程の例で、日本語文章自身のAttentionを取ると「好き」と関連度が高い単語は「本」となるなどといった、自身の文章内の各単語間の関連度を計算できるのです。Transformerは、この2つをEncoderに対してself-Attention、Decoderに対してself-Attentionと通常のAttentionを使った構造となっています。

TransformerはEncoder時にself-Attention、Decoder時にself-Attentionと通常のAttentionを使います。なぜならEncoderの入力には予測をするための元データを入れ、Decoderの入力はEncoderの出力と一時点前の予測結果を入れます。そのためEncoderは入力自体のみを使うself-Attentionで実装し、DecoderはEncoderの出力と予測を使う通常のAttentionで実装します。このときDecoderの一時点前までの予測結果に対しては、self-Attentionをします。 以下にすごくシンプルな構造に落とし込んだTransformerの例を示します。この例は「これは本です」を英語に翻訳する例です。

Encoderは入力「これは/本/です」の各単語間のself-Attentionを計算し、その出力はDecoderの途中部分に入力されます。Decoderでは「<SOS>」という最初の単語(Start of Sequenceの略)が入り、その単語のself-Attentionをします。そしてその出力とEncoderの出力に対してAttentionを取ります。これを経て「This」が予測値として出てきます。2単語目(図右半分)も同様の手順で、このときDecoderの入力には1つ前までのすべての予測値「<SOS>/This」が使われます。ただし、実際のTransformerは各Attentionを何度か通し、各単語の位置情報を付与する、単語間で数値計算ができるよう単語を数値ベクトル化するなどさまざまな工夫がされています。

Transformerは難しい概念ですね。

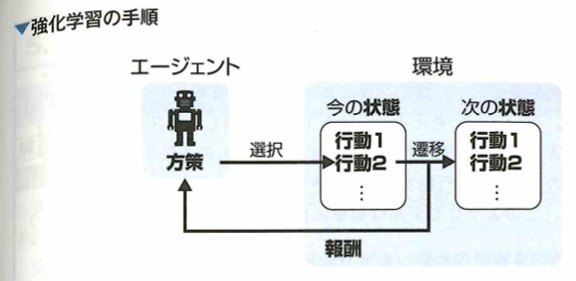

強化学習の特徴

強化学習の用語確認

強化学習では環境と学習目的を設定します。環境は状態、行動、報酬、推移確率などを内包します。行動主体であるエージェントが環境内で学習目的を達成するように、状態に対する最適な行動選択の学習を行います。また、行動選択の結果、エージェントは報酬を得ます。学習目的に近づく行動選択であったか報酬に基づいて評価することで行動選択を改善します。

方策はエージェントが持つ行動選択のルールのことです。個々の行動によって得た報酬をもとに、一連の行動選択による報酬和を最大化する方策を求めることが強化学習のゴールです。

方策の学習

行動選択を行なった後に報酬が得られない環境でも方策が学習できます。例えば以後のように勝敗が決した状態に達した時のみ報酬が得られる場合です。このような報酬を疎な報酬と言い、学習には時間がかかります。

強化学習を用いて最適な方策を学習させることについて、意図した目的を達成するために、状態を必要十分に設定することは難しいです。また報酬の設定によって方策の学習結果が異なりますので、達成したい目的に合わせた報酬を設定しないと意図しないものとなることがあります。また、状態や行動の数が多い場合には、現実的な時間で状態と適切な行動を結びつけることが多いです。

深層強化学習

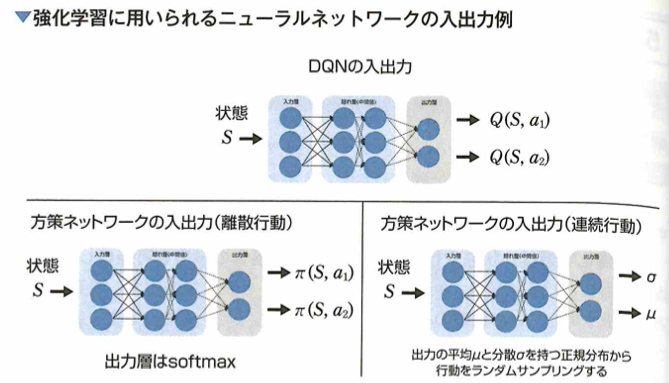

強化学習においてディープラーニングを用いる理由

深層強化学習について、ニューラルネットワークを用いて状態の重要な情報のみを縮約表現します。これにより状態数が多い問題に対しても強化学習が適用できるようになりました。

ディープラーニングを用いてなくとも、確率分布関数などで方策をパラメトリックに表現できます。Deep Q Network(DQN)という深層強化学習手法では、状態や行動の価値をニューラルネットワークで表現できますが、その価値の算出に報酬を用います。深層強化学習はあくまで強化学習の手法にニューラルネットワークを用いた手法です。強化学習では行動の組み合わせを直接学習しません。

Q学習

Q学習について考えます。Q学習とは、状態と行動の組に対してその後得られる報酬和の期待値(Q関数)を推定し、期待値が最大である行動を選択するアルゴリズムです。

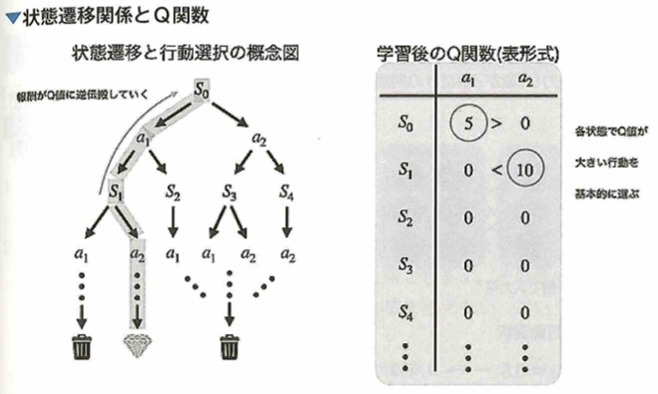

Q学習は価値ベースの強化学習手法です。価値推定を行う部分と推定した価値を参考にして行動選択する部分に分かれます。状態sと状態aの組の価値を、状態s行動aを選んだ後、得られる報酬和の期待値で表現します。これをQ関数と呼びます。アルゴリズムSARSAではある状態sにおける行動aの価値であるQ関数Q(s,a)の推定値を求める計算では、次の状態s’において方策を用いて選択した行動a'のQ関数Q(s',a')が用いられますが、Q学習ではQ(s,a)の推定値を求める計算では、次の状態s'のQ関数のうち、最大の値を持つQ関数Q(s',a*)が用いられます。しかしQ値が最大である行動のみ選択すると、局所解に陥る場合があります。そこで一定の確率でQ値を無視した選択をします。Q値を参考にする行動選択を利用、Q値を無視した行動選択を探索と言います。探索と利用の間にはジレンマがあります。モンテカルロ木探索とは、ある状態から行動選択を繰り返して報酬和を計算するということを複数回行なった後、報酬和の平均値をある状態の価値とする価値推定方法です。TD学習とは、常態価値の推定において、直後に得られた報酬と次の状態の価値を用いる手法です。

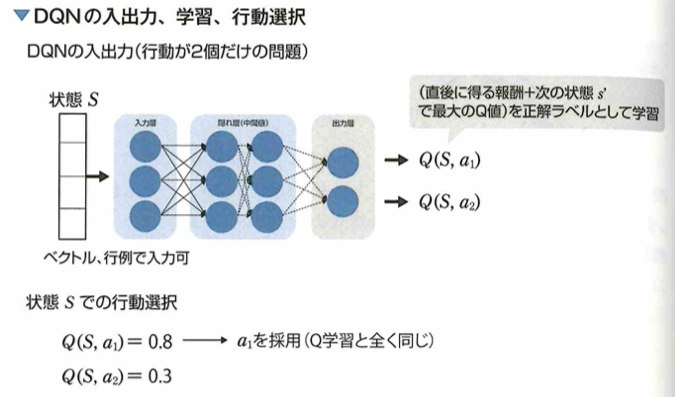

DQN

Deep Q Network(DQN)について考えます。ニューラルネットワークでは、入力に状態を表現するベクトルを受け取り、Q関数を近似します。行動選択などの制御はあらかじめ設定した方策によって行います。

このときの出力層の各ノードは各行動の価値になります。Q関数以外の行動選択の部分はQ学習と変わらないので、DQN学習はQ学習におけるQ関数の近似計算だけをニューラルネットワークで下請けさせるアルゴリズムです。方策勾配法系の強化学習のアルゴリズムでは入力に状態を受け取り、出力に行動(または行動をとる確率)を出力するニューラルネットワークです。Q学習における次の状態s’において最大の値をとるQ関数を用いることを方策オフ型の学習と呼び、SARSAのアルゴリズムでは方策オン型の学習と言います。

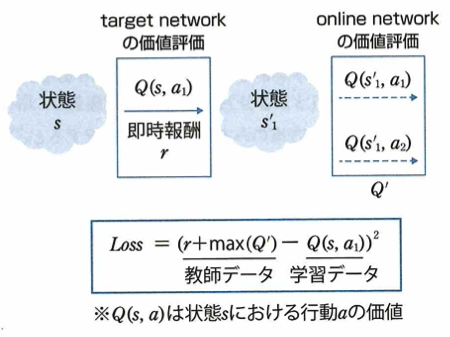

Double DQN

DQNを改良したDouble DQN手法について、強化学習において、多くの手法はデータのサンプリングを前提として学習が行われます。以下の図は、通常のDQNにおいて現状状態sで行動a_1を選択したときに得られた即時報酬rと、現状状態sと次状態s_1の状態行動価値(Q値)からDQNの損失関数を計算する過程を示しています。

DQNはニューラルネットワークを用いてQ値を推論することで価値評価を行なっており、target networkのパラメータは学習を進めるのに従って変化します。ここで通常のDQNではtarget networkとonline networkは同じ重みを利用しています。一方で通常のDQNを改良したDouble DQNという手法は、価値評価に用いる2つのネットワークで違う重みを利用するようにした手法です。Double DQN手法において、2つの価値評価を異なるネットワークで行うことのメリットは偏ったQ値の過大評価を改善することができることです。

通常のDQNでは2つの価値評価を学習中の同じネットワークの出力でおこないますが、推論したQ値がノイズによって偏ると、偏ったQ値を過大評価してしまう問題があります。Double DQNでは、targetnetworkにonline networkとは別のノイズが乗ったネットワークを利用するので、ノイズによる過大評価を改善します。このときtarget networkにはonline networkの過去のパラメータを利用しています。Double DQNではメモリの使用量が減ることにはなりません。学習済みネットワークを利用する実運用の際はonline neteworkを使用します。また、時系列データに適した構造となっているものではありません。

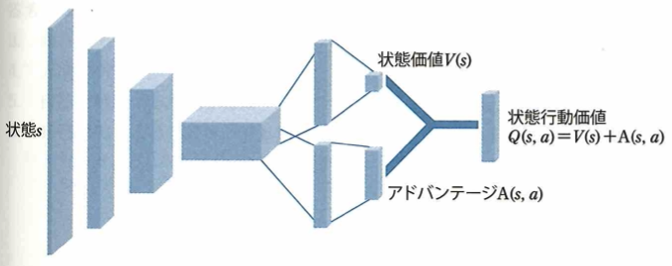

Dueling Network

DQNを改良したDueling Network手法について考えます。通常のDQNは状態を入力としてQ値を推論するニューラルネットワークです。ここで通常のDQNを改良したDueling Networkの手法では、DQN同様に状態sを入力としてQ値を出力しますが、以下のようにネットワーク内部でQ値(状態行動価値)を状態価値V(s)とアドバンテージA(s,a)に分解しています。

状態価値V(s)とはその状態にいることがどれだけ良いのかを測るもので、アドバンテージA(s,a)とはそれぞれの行動の重要性を相対的に測るものです。Duleing Network手法において、Q値を分解するアイデアの元となった洞察について、行動選択が報酬の獲得にほとんど影響を与えない状態が多く存在することです。

Dueling Networkのアイデアは、多くの状態では、行動選択の重要性が高くない洞察をもとにしています。Dueling Networkで、各行動の選択が重要になるのは、ゲームなどにおいて、障害物が接近した状況などです。Dueling Networkにおいて、分割した構造は、それぞれ状態価値とアドバンテージという異なるものを推論するものであり、推論結果を平均するものではありません。Dueling Networkは、元々直接Q値を推論していた構造を2つに分けたもので、パラメータ数を削減することを目的としたものではありません。

Noisy Network

DQNを改良したNoisy Network手法について考えます。通常のDQNでは方策として、ε-greedy法が用いられます。ε-greedy法では、εの確率でランダムな行動選択を行うことで、新たな行動を探索するものです。しかし、εの値の設定は、ハイパーパラメータとして手動で設定するものであり、モデルの性能を決める必要なパラメータであるとともに、適切な値の設定が難しいという問題があります。ここで通常のDQNを改良した手法にNoisy Networkと呼ばれる手法が存在します。この手法は、ネットワーク内部でランダムなノイズを発生させることで、ε-greedy法を用いなくてもランダムな行動を起こし、新たな行動を探索できるようになっています。Noisy Network法がネットワーク内部でノイズを発生する仕組みとして、平均と標準偏差を学習しつつ、ガウス分布による乱数をネットワークの重みとして用います。

このとき、ノードの出力にノイズを加算するものではありません。ランダムにノードの出力を0にするのはDropout法で、ネットワークの正規化に用いられます。入力データにノイズを加えるものでもありません。

AlphaGo

AlphaGoに用いられる各ニューラルネットワークの入力データと出力データと教師データを考えます。ここでは教師あり学習フェーズと強化学習フェーズの2段階で以後の強さを高めます。

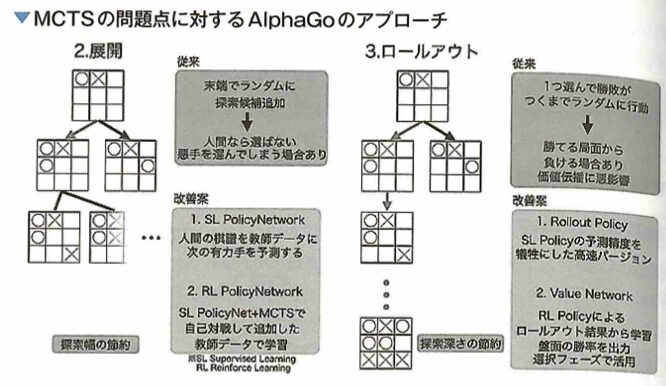

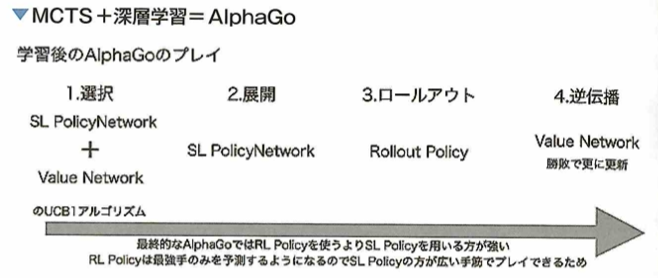

教師あり学習フェーズでは、2つのネットワークを学習させます。 Supervised Learning Policy Network(SL Policy)が、人間の棋譜を教師データとして、ある盤面を見て次の盤面を予測します。これによって人間が考える有望な手のみを探索することができるので、悪い手まで探索する計算を省くことができます。よって入力データが「現在の盤面状態」で出力データが「次の盤面状態」で教師データは「人間の棋譜」です。Rollout Policyは、SL Policyと同様に現在の盤面から次の盤面を予測します。Rollout Policyの特徴は予測性能を下げる代わりに計算を高速にしたことです。そしてSL Policyで探索すると決めた手から終局までざっと計算して勝敗を決めます。これによってSL Policyの手がどれだけ良かったかを勝敗で評価できます。よってSL Policyと同じで、入力データが「現在の盤面状態」、出力データが「次の盤面状態」、教師データは「人間の棋譜」です。

強化学習フェーズでは、SL PolicyとRollout Policyの組み合わせで、人間を参考にした囲碁がざっくりとできるようになったので、強化学習フェーズに入ります。 まず、SL Policy同士で対戦を行わせます。そして勝った方が取った手を方策漸進法で強化していきます。すると、徐々にPolicyが強くなっていくので最強のPolicyをそれ以外のPolicyからランダムに選んで対戦を行います。この繰り返しでPolicyを強化学習していきます。Reinforcement Learning Policy Network (RL Policy)でPolicyの方策を強化学習させ、入力データが「現在の盤面状態」で、出力データが「次の盤面状態」で、教師データは「自己対戦によるエピソードと報酬」でとなります。つまり、RL Policyは勝敗を報酬として強化学習する方策ネットワークということです。 次に学習したRL PolicyとSL Policyを用いて自己対戦を行い、Value Networkという盤面と入力し勝率を予測するネットワークを学習させるためのデータセットを作成します。 自己対戦はランダムな手数ではSL Policyを使い、その後1手はランダムに手を打ち、以降はRL Policyを使って終局まで対戦を行います。このような対局を何度も行い、ランダムに手を打ったときの局面と勝敗を記録することでValue Network用のデータセットを作成します。よって、入力データが「現在の盤面状態」で、出力データが入力盤面の「勝率」で、教師データは「自己対戦による局面と勝敗」です。Value Networkの導入によって、最終的なAlphaGoでは打ち手を選択する際に、最終的な勝敗まで加味することができます。 最後に学習済みの各ネットワークを、モンテカルロ木探索のアルゴリズムの行動選択部分に組み込むことで、AlphaGoが完成します。 すべてのネットワークは、入力が19×19の盤面であるためCNNを用います。 ちなみに最終的なAlphaGoでは、SL PolicyとValue Networkで行動選択を行います。RL PolicyではなくSL Policyを用いる方が高い勝率を上げたそうで、元置きでの手の多様性をもたせたからではないかと考察しています。

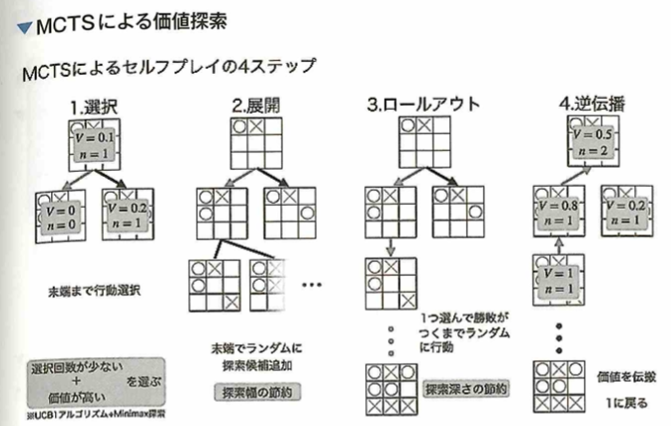

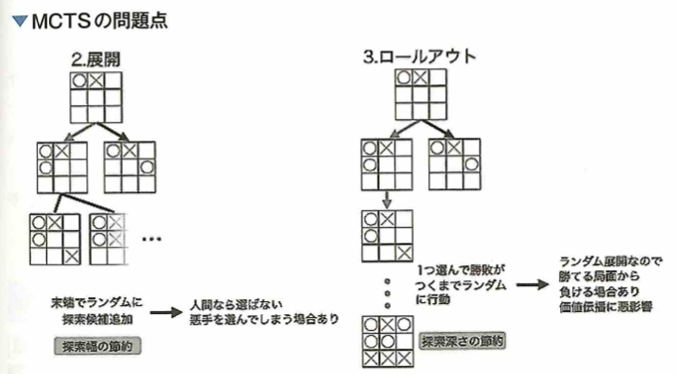

AlphaGoの手法

スタートの状態から遷移できる状態をいくつかランダムに列挙します。列挙した状態から1つ選び、この状態を起点としてゲームの勝敗がつくまでランダムに状態遷移のシミュレーションをします。勝敗がつくシミュレーションの起点以前の状態に価値付けを行います。状態の価値付けができたのでスタートの状態から価値の高い状態へ遷移します。すでに列挙済みの状態の中の終端を新しいスタートの状態とします。以上を繰り返します。価値の高い状態を起点としたシミュレーションによって効率的に手の探索を行うアルゴリズムをモンテカルロ木探索(MCTS)と呼びます。囲碁などの状態数と行動数が多いゲームでは価値の全探索が難しいが、このアルゴリズムを用いることで、価値を探索する幅と深さを限定し効率的に状態の価値付けができます。しかし、探索の幅を限定する際、つまりある状態から次の盤面を列挙するときにランダムに選ぶのでは人間が選ばないような悪い手を選んでしまう点、シミュレーションはランダム状態遷移で行うため、同じ状態を起点としても勝ち負けが変わってしまい、価値付けがうまくできない問題がありました。AlphaGoでは、CNNを用いて4つのニューラルネットワークを学習させます。人間の棋譜の遷移関係を学習させることで1つ次の手を予測し勝ちに繋がりやすい状態を列挙するSL Policy、SL Policyの予測性能を落とす代わりに計算速度を上げたRollout Policy、SL Policyのネットワーク同士の対戦による学習で予測性能を向上させたRL Policy、またある盤面からRL PolicyとRollout Policyのネットワークを用いて勝敗がつくまでゲームを進めその勝敗をもとに盤面の勝利確率を学習させ、予測するValue Networkを学習させます。これらのニューラルネットワークによって改善したモンテカルロ木探索(MCTS)で作った囲碁AI同士を対戦させることで、新しい棋譜データを自動生成し、各ネットワークを学習させることで強い囲碁AIを作ります。

AlphaGo以前ではゲームAIの作成方法としてモンテカルロ木探索(MCTS)がありました。MCTSではゲームの手番の進行を木構造で表現します。ゲームの初期では、打ち手が勝敗に繋がるか評価することができません。しかし、すべての打ち手に関して勝敗がつくまで木構造を拡張する膨大な組み合わせという計算ができません。そこでMCTSでは、木構造に含める打ち手をいくつか全打ち手からランダムに選出することと、木構造を段階的に深くする方針を取ります。木構造を段階的に深くしながらランダムに選出した打ち手からさらに選んで勝敗がつくまでランダムに手番を行います(ロールアウト)。これで勝敗がつくので、スタート状態から勝敗がついた状態までの状態を評価することができます。これを繰り返して、価値の探索を行う箇所を限定しながら有望な打ち手の周辺のみを探索できます。しかし、木構造に含める打ち手をランダムに選ぶ時点で最有望手を含まなかったり、ロールアウトを行う際に同じ盤面からスタートしても、勝ち負けが変わってしまったりする問題がありました。これらの問題に対して、盤面から有望手を決めるSupervised Learning Policy Network(SL Policy)を人間の棋譜から学習させ、探索する木の幅を狭くしました。このとき同じく人間の棋譜から学習させ、SL Policyより精度が低い代わりに計算の速いRollout Policyも学習させておきます。ここまでが教師あり学習フェーズです。